Библия Nutanix

Авторские права (c) 2018: Библия Nutanix и NutanixBible.com, 2018. Несанкционированное использование и/или копирование этого материала без письменного разрешения автора и / или владельца этого блога строго запрещено. Выдержки и Ссылки могут быть использованы при условии, что Стивену Пойтрасу и NutanixBible.com будет предоставлена вся информация о факте, целях и назначении их использования с обязательной отсылкой к оригинальному содержимому сайта.

От переводчика: С тех пор, как я перевел первую версию Библии Nutanix прошло немало времени и старый перевод устарел. Я принял решение освежить его. В этот раз я постараюсь поддерживать его в актуальном состоянии и своевременно исправлять недочеты перевода.

Отзывы, предложения и опечатки отправляйте на адрес: avarlamov@protonmail.com

Локализованные версии:

Версия в формате PDF доступна на английском языке (В данной версии могут отсутствовать последние изменения):

Предисловие

Дирай Пандей, CEO, Nutanix

Для меня большая честь писать предисловие к этой книге, которую мы зовем Библия Nutanix. В первую очередь, я хотел бы обратиться к названию этой книги, которое может показаться некоторым людям не вполне уместным по отношению к их вероисповеданию, а также к агностикам и атеистам. Согласно словарю Мериам Вебстер значение слова "библия" не подразумевает по собой Писание как таковое: "выдающаяся публикация, имеющая авторитет у широкой читательской аудитории". Именно так и следует интерпретировать его корни. Данный материал был написан одним их самых скромных и сведущих сотрудников компании Nutanix - Стивеном Пойтрасом, нашим первым Архитектором решений, который является очень авторитетным, при этом, не кичась статусом одного из первых сотрудников компании. Знания не были для него его собственной прерогативой, наоборот - постоянный обмен и распространение знаний делает его чрезвычайно влиятельным в этой компании. Стив олицетворяет культуру этой компании, помогает сотрудникам делясь своей глубокой компетенцией, помогая автоматизировать задачи коллег при помощи Power Shell или Python, создавая прекрасное описание архитектуры (тут важно отметить прекрасный баланс между формой и содержанием), а так же помогая всем, кто нуждается в его помощи в реальном времени в Yammer и Twitter, сохраняя прозрачность перед инженерами, говоря о необходимости самокритики и самосовершенствования, о необходимости быть амбициозным.

Когда Стив решил написать этот блог его мечтой было стать лидером, со всей прозрачностью, создать сторонников в отрасли, кто будет помогать приходить к компромиссным решениям в дизайне продукта. Открытие таких подробностей огромная редкость для компаний, никто не рассказывал столько сколько Стив в своем блоге. Даже Open Source компании, которые выглядят прозрачно на первый взгляд, никогда не раскрывают подробности о том, как их продукт работает. Мы же считаем, что, когда наши конкуренты знают о слабостях нашего продукта и архитектуры — это делает нас сильнее, не остается секретов. Публичная критика или обсуждение слабых мест архитектуры в кратчайшее время приводит в Yammer всю компанию, где мы пытаемся понять - является ли отмеченный недостаток недостатком, так наш продукт становится лучше. В этом сила честного общения с партнерами и клиентами.

Этот постоянно совершенствующийся артефакт, помимо авторитета, имеет широчайшую читательскую аудиторию во всем мире. Архитекторы, менеджеры и ИТ-директора, останавливали меня в конференц-залах, чтобы поговорить о том, насколько прозрачен стиль письма, с подробными иллюстрациями, фигурами для visio и схемами. Стив потратил много времени, чтобы рассказать историю web-scale архитектуры, не навешивая ярлыков. Популяризировать нашу распределенную архитектуру было непросто, в мире, где ИТ-специалисты завалены решением "неотложных" задач и проблем. Библия позволяет сократить разрыв между ИТ и DevOps, она объясняет самые сложные вещи из глубин ИТ простыми словами. Мы надеемся, что в ближайшие 3-5 лет ИТ станет использовать простые термины, и приблизится к Web-Scale DevOps.

С первым изданием мы превращаем блог Стивена в книгу. День, когда мы перестанем обновлять этот материал, станет началом конца этой компании. Я ожидаю, что каждый из вас будет продолжать напоминать нам о том, что привело нас к сюда: правда, только правда и ничего кроме правды освободит вас (от самодовольства и гордыни).

Будьте честными.

--Дирай Пандей, CEO, Nutanix

Стюарт Минимэн, Главный Научный Сотрудник, Wikibon

Сегодня пользователи каждый день сталкиваются с новыми технологиями. У сферы ИТ нет пределов для совершенствования, однако принятие обществом новых технологий, и тем более - изменение каких-либо привычных процессов и операций дело сложное и непростое. Быстрый рост технологий с открытым исходным кодом, например, сдерживается отсутствием полноценной документации. В качестве попытки борьбы с этой проблемой был реализован проект Wikibon. Библия Nutanix, начинавшаяся как блог Стивена Пойтраса со временем стала ценным источником информации для ИТ-специалистов, которые хотят узнать о принципах гиперконвергентной и web-scale архитектуры, поглубже погрузиться в особенности архитектуры гипервизора и платформы Nutanix. Концепции, о которых пишет Стив — это передовые технологии и решения, которые создаются одними из лучших инженеров отрасли. В этой книге сложные понятия описаны доступным языком, понятным широкому кругу читателей, и при этом без ущерба техническим подробностям.

Концепция распределенных систем и программно-определяемой инфраструктуры являются самой передовой на текущий момент, это очень важно донести до всех ИТ-специалистов. Я призываю прочитать эту книгу всех, кто хочет понять, что скрывается под этой концепцией. Технологии описанные здесь являются основой самых крупных центров обработки данных в Мире.

--Стюарт Минимэн, Главный Научный Сотрудник, Wikibon

Введение

Стивен Пойтрас, Главный архитектор решений, Nutanix

Добро пожаловать в Библию Nutanix! Я работаю с платформой Nutanix на постоянной основе – пытаюсь выявить проблемы, увеличить допустимые максимумы, а также администрирую платформу в своей лаборатории. Этот материал я задумывал, как документ, который будет содержать советы и приемы по работе с решениями компании от меня и инженеров, которые работают с платформой каждый день.

Примечание: Данный материал позволяет взглянуть на платформу изнутри и получить представление как все устроено. Для успешной работы с Nutanix Вам не потребуется глубоких знаний по всем упомянутым в данном материале темам.

Наслаждайтесь!

--Стивен Пойтрас, Главный архитектор решений, Nutanix

Часть I. Краткий экскурс в историю

Краткий обзор истории ИТ-инфраструктуры и предпосылок которые привели нас туда, где мы находимся сейчас.

Эволюция центров обработки данных

Центры обработки данных очень изменились за последние несколько десятков лет. В следующих разделах мы рассмотрим каждую эру.

Эра мейнфреймов

Мейнфремы правили в ЦОД в течение многих лет и заложили основу большинства современных технологий. Мейнфремы обеспечивали:

- Встроенный конвергентный процессор, оперативную память, и хранилище

- Резервирование на аппаратном уровне

Однако, имели следующие недостатки:

- Высокая стоимость инфраструктуры

- Чрезмерная сложность

- Недостаточная гибкость

Переход на классические серверы

Использование мейнфреймов было слишком дорогим и сложным для бизнеса, и это стало причиной появления классических серверов шириной 19". Их основные особенности:

- Центральный процессор, оперативная память, локальные диски

- Большая гибкость, чем у мейнфреймов

- Сетевые интерфейсы и доступ по сети

Такие серверные решения несли за собой следующие минусы:

- Увеличение количества оборудования

- Низкий уровень утилизации оборудования

- Каждый сервер становился единой точкой отказа, как для хранилища так и для вычислений

Централизованное хранилище

Основная задача бизнеса - заработок денег, и данные являются одним из ключевых инструментов. Когда организации используют классические хранилища - им всегда требуется больше емкости и обеспечении высокой доступности данных, чтобы выход из строя сервера не приводил к их потере.

Так классические СХД заменили локальные емкости серверного оборудования и мейнфреймов, обеспечив сохранность данных. Их основные характеристики:

- Объединенные ресурсы хранения и их эффективное использование

- Централизованная защита данных при помощи технологии RAID

- Доступ к данным по сети

Вот некоторые недостатки, которые привнесли классические выделенные хранилища:

- Классические СХД являются дорогостоящими, однако данные дороже

- Выросла сложность инфраструктуры (Фабрики SAN, адресация WWPN, RAID-группы, тома, количество шпинделей и так далее)

- Требуется использовать специальное ПО и команду

Внедрение виртуализации

Виртуализация позволила увеличить плотность вычислений запуская несколько разнородных задач в рамках одного классического сервера. Виртуализация помогла Бизнесу утилизировать их оборудование, но увеличила последствия выхода оборудования из строя.

Основные характеристики виртуализации:

- Позволяет перенести вычисления на уровень выше от оборудования - создать виртуальные машины

- Очень эффективное использование вычислительных ресурсов и консолидация нагрузок

Виртуализация привнесла следующие вопросы:

- Количество оборудования выросло, управление ими усложнилось

- Без технологий HA отказ сервера приводил к влиянию на большее количество сервисов

- Отсутствие общих ресурсов

- Снова требовалась отдельная команда и специальное ПО

Развитие виртуализации

Гипервизоры стали функциональным и эффективным решением. С появлением технологий VMware vMotion, HA, и DRS, пользователи получили возможность обеспечивать HA для ВМ и динамически распределять нагрузку на оборудование. Однако централизованное хранилище все еще являлось проблемой - конкуренция ВМ за ресурсы увеличивало нагрузку на хранилища.

Ключевые характеристики:

- Кластеризация привела к объединению вычислительных ресурсов

- Появилась возможность динамического перераспределения нагрузки (DRS / vMotion)

- Высокая доступность ВМ позволяла сохранить работоспособность ПО при выходе из строя аппаратного сервера

- Требовалось использовать централизованное хранилище

Вопросы:

- Увеличились требования к производительности централизованного хранилища

- Требования к хранилищу снова увеличивали количество оборудования

- Вместе с производительностью хранилища выросла и стоимость хранения

- Конкуренция за ресурсы хранения влияла на производительность

- Все это делало конфигурацию хранилища еще сложнее, требовалось следить за:

- количеством ВМ использующих хранилище и томов созданных на СХД

- количеством шпинделей, чтобы обеспечивать приемлемую производительность

Твердотельные накопители

SSD помогли устранить узкое место в I/O, обеспечивая гораздо более высокую производительность без необходимости добавлять и добавлять шпиндели. Однако, контроллеры и сеть все еще не были готовы к такой производительности.

Ключевые характеристики:

- Гораздо более высокие характеристики I/O, чем у HDD

- Время отклика сильно сократилось

Вопросы:

- Узкое место переместилось с уровня хранилища на уровень контроллеров и сетей

- Количество оборудования все еще было велико

- Сложность конфигурации СХД сохранялась

Пришествие облаков

Термин Облако можно трактовать по-разному. Одним словом — это возможность предоставлять расположенный где-то сервис пользователям, которые расположены где-то еще.

С появлением облаков изменились перспективы ИТ, Бизнеса и конечных пользователей.

Бизнес требует от ИТ, чтобы ресурсы предоставлялись по облачной модели - как можно быстрее. Если это не происходит - Бизнес уходит непосредственно в облака и сталкивается там с проблемами безопасности.

Основные столпы любого облачного сервиса:

-

Самообслуживание / Получение ресурсов по требованию

- Быстрая окупаемость / низкий порог входа

-

Фокус на сервисе и SLA

- Гарантии времени работы, уровня доступности, производительности

-

Гранулярная модель потребления

- Плати за то, что используешь. При этом некоторые сервисы могут быть бесплатными

Классификация облаков

Облака могут быть разделены на три основных типа:

-

ПО как сервис (SaaS)

- Любое ПО или услуга доступные через url

- Примеры: Workday, Salesforce.com, Google search, etc.

-

Платформа как сервис (PaaS)

- Платформа для разработки и размещения приложений

- Примеры: Amazon Elastic Beanstalk / Relational Database Services (RDS), Google App Engine, и так далее

-

Инфраструктура как сервис (IaaS)

- Виртуальные машины/Контейнеры/Вируализация сетевых функций

- Примеры: Amazon EC2/ECS, Microsoft Azure, Google Compute Engine (GCE), и так далее

Сдвиг фокуса в области ИТ

Облака ставят перед ИТ интересный вопрос - ответом на который может стать использование внешних облачных платформ/провайдеров или же обеспечение какой-то альтернативы им. При этом, все хотят сохранить свои бизнес-данные внутри компании, предложить пользователям удобный портал самообслуживания и высокую скорость развертывания сервисов.

То есть, сдвиг фокуса в сторону облачных сервисов толкает ИТ к тому, чтобы стать "облачным" сервис-провайдером для собственных конечных пользователей (сотрудников компании).

Важность задержек при работе с данными

В таблице ниже приведены задержки для разных типов I/O:

| Операция | Задержка | Комментарии |

|---|---|---|

| Доступ к кэшу первого уровня | 0.5 ns | |

| Доступ к кэшу второго уровня | 7 ns | 14x L1 cache |

| Доступ к DRAM | 100 ns | 20x L2 cache, 200x L1 cache |

| 3D XPoint на основе чтения NVMe SSD | 10,000 of ns (ожидаемо) | 10 us or 0.01 ms |

| NAND NVMe SSD R/W | 20,000 ns | 20 us or 0.02 ms |

| NAND SATA SSD R/W | 50,000-60,000 ns | 50-60 us or 0.05-0.06 ms |

| Случайное чтение блоков 4K с SSD | 150,000 ns | 150 us or 0.15 ms |

| Задержка P2P TCP/IP (физика на физику) | 150,000 ns | 150 us or 0.15 ms |

| Задержка P2P TCP/IP (ВМ на ВМ) | 250,000 ns | 250 us or 0.25 ms |

| Последовательное чтение 1MB из памяти | 250,000 ns | 250 us or 0.25 ms |

| В среднем по ЦОД | 500,000 ns | 500 us or 0.5 ms |

| Последовательное чтение 1MB с SSD | 1,000,000 ns | 1 ms, 4x memory |

| Поиск диска | 10,000,000 ns или 10,000 us | 10 ms, 20x от среднего по ЦОД |

| Последовательное чтение 1MB с диска | 20,000,000 ns or 20,000 us | 20 ms, 80x memory, 20x SSD |

| Отправлка пакетов Калифорния -> Нидерланды -> Калифорния | 150,000,000 ns | 150 ms |

(автор: Джефф Дин, https://gist.github.com/jboner/2841832)

Таблица показывает, что ЦПУ может получить доступ к КЭШ в среднем за ~0.5-7ns (L1 vs. L2). Для основной памяти ~100ns, когда локальное чтение 4K SSD ~150,000ns или же 0.15ms.

Если мы возьмем для примера стандартные SSD уровня предприятия (в нашем случае Intel S3700 - SPEC), то сможем получить:

- Производительность случайных операций I/O:

- Случайное чтение, блоки по 4K: до 75,000 IOPS

- Случайная запись, блоки по 4K: до 36,000 IOPS

- Пропускная способность при последовательных операциях I/O:

- Последовательное чтение: до 500MB/s

- Последовательная запись: до to 460MB/s

- Задержки:

- Чтение: 50us

- Запись: 65us

Поговорим о пропускной способности

Классические СХД используют две пары основных видов транспорта I/O:

- SAN (FC)

- 4-, 8-, 16- и 32-Gb

- LAN (включая FCoE)

- 1-, 10-Gb, (40-Gb IB), и т.д.

Для расчетов, приведенных ниже мы используем пропускную способность 500MB/s для чтения и 460MB/s для записи на базе Intel S3700.

Расчет производится следующим образом:

numSSD = ROUNDUP((numConnections * connBW (in GB/s))/ ssdBW (R or W))

Примечание: Полученные значения были округлены. А также мы не берем в расчет ЦПУ, предполагая что у него нет ограничений

| Пропускная способность сети | Количество SSD необходимых для утилизации канала | ||

|---|---|---|---|

| Тип подключения контроллера | Доступная пропускная способность | I/O чтения | I/O записи |

| Двойной 4Gb FC | 8Gb == 1GB | 2 | 3 |

| Двойной 8Gb FC | 16Gb == 2GB | 4 | 5 |

| Двойной 16Gb FC | 32Gb == 4GB | 8 | 9 |

| Двойной 32Gb FC | 64Gb == 8GB | 16 | 19 |

| Двойной 1Gb ETH | 2Gb == 0.25GB | 1 | 1 |

| Двойной 10Gb ETH | 20Gb == 2.5GB | 5 | 6 |

Из таблицы видно, что если вы хотите использовать SSD на максимум, то сеть может быть узким местом при появлении 1-9 таких дисков, в зависимости от типа сети

Задержки при работе с памятью

Стандартная задержка при работе с памятью ~100ns, значит можно выполнить следующие расчеты:

- Задержка при доступе к локальной памяти = 100ns + [накладные расходы на ОС / гипервизор]

- Задержка при чтении из памяти по сети = 100ns + задержки RTT + [2 x накладные расходы на ОС / гипервизор]

Если принять, что RTT для стандартной сети равен ~0.5ms (может отличаться в зависимости от производителя оборудования) т.е. ~500,000ns, то:

- Задержка при чтении из памяти по сети = 100ns + 500,000ns + [2 x накладные расходы на ОС / гипервизор]

Если мы предположим, что имеем очень быструю сеть с RTT = 10,000ns, то:

- Задержка при чтении из памяти по сети = 100ns + 10,000ns + [2 x накладные расходы на ОС / гипервизор]

Т.е. даже при наличии сверхбыстрой сети мы имеем 10,000% накладных расходов по сравнению с локальной памятью. Если сеть медленная то, накладные расходы могут увеличится до 500,000%.

Чтобы эти накладные расходы как-то нивелировать, используется кэширование данных

Пространство пользователей и ядра

Одной из самых жарких и часто обсуждаемых тем является обсуждение плюсов и минусов использования пользовательского пространства и пространства ядра операционной системы. Тут я остановлюсь на плюсах и минусах этих подходов.

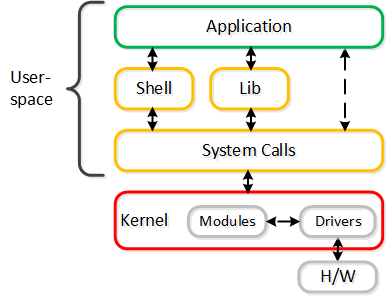

Все операции ОС выполняются в двух основных пространствах:

-

Пространство ядра

- Наиболее привилегированная часть ОС

- Управление задачами, памятью и так далее

- Работают драйверы и происходит управление оборудованием

-

Пространство пользователя

- Стандартное пространство для запуска пользовательских процессов

- Тут функционируют почти все процессы

- Память на этом уровне защищена, происходит выполнение процессов

Оба этих пространства позволяют ОС функционировать.Теперь давайте определим несколько ключевых элементов:

-

Системный вызов

- Или же - вызов ядра, который осуществляется через прерывание из активного процесса

-

Переключение контекста

- Перенос выполнения между ядром и процессом

Например рассмотрим, как осуществляеся запись данных приложением на диск:

- Приложение хочет записать данные на диск

- Осуществляется вызов системного вызова

- Контекст переключается на ядро

- Ядро осуществляет копирование

- Осуществляется запись на диск с использованием драйвера

Схема взаимодействия:

Одно пространство лучше другого? В реальности есть следующие плюсы и минусы:

-

Пространство пользователя

- Очень гибкое

- Изолированные домены (сервисы)

- Может быть неэффективным

- Переключение контекстов требует времени(~1,000ns)

-

Пространство ядра

- Очень жесткое

- Один большой домен

- Может быть эффективным

- Меньше переключений контекста

Опрос против прерываний

Еще одним ключевым моментом является тип взаимодействия между пространствами:

-

Опрос

- Постоянный опрос - непрерывный запрос какой-то информации

- Пример: движение мышки, частота обновления монитора и так далее

- Постоянный расход процессорного времени

- Исключает использование обработчика прерываний ядра, низкие задержки

- Исключает контекстный переключатель

- Прерывания

- Периодические запросы ресурсов

- Пример: Студент поднимает руку, чтобы задать вопрос

- Может быть более эффективным, но не всегда

- Обычно задержка намного выше, чем при опросе

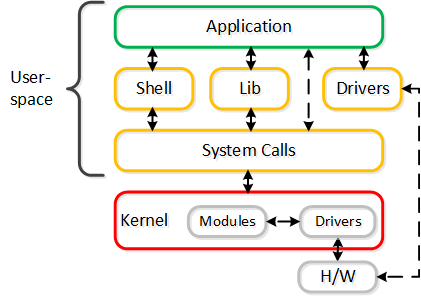

Пространство пользователя

Чем быстрее устройство (например: NVMe, Intel Optane, pMEM), тем более узким местом становится процесс взаимодействия ядра и устройства. Чтобы как-то решить эту проблему, многие производители переносят задачи из пространства ядра в пользовательское пространство и используют механизм опроса, для получения лучших результатов производительности.

Прекрасный пример - Intel Storage Performance Development Kit (SPDK) и Data Plane Development Kit (DPDK). Оба проекта направлены на получение максимальной производительности и сокращение задержек.

Такое перемещение ПО включает следующие изменения:

- Перенос драйверов устройств в пользовательское пространство (вместо пространства ядра)

- Использование механизма опроса (вместо прерываний)

Это обеспечивает большую производительность, потому что устраняет

- Дорогие системные вызовы и управление прерываниями

- Копии данных

- Переключение контекстов

Ниже показан пример взаимодействия устройств с помощью драйверов в пользовательском пространстве:

Можно отметить, что часть решений компании Nutanix разработанных для AHV (vhost-user-scsi), используется компанией Intel для проекта SPDK.

Книга Web-Scale

web·scale - /web ' skãl/ - noun - горизонтально масштабируемая архитектура

новый архитектурный подход к реализации инфраструктуры и вычислениям

В этой главе будут представлены основные понятия “Web-scale” инфраструктуры и почему мы используем их. Важно прояснить - использование такой архитектуры не обязывает вас быть размером с Google или Amazon, такая архитектура полезна при любом масштабе инфраструктуры (начиная с трех узлов).

Исторические вызовы:

- Сложность, сложность, сложность

- Стремление к постепенному росту

- Необходимось быть более гибким

Вот основные фишки Web-scale

- Гиперконвергентность

- Программно-определяемые решения

- Распределенные автономные системы

- Постепенное, линейное масштабирование

И еще:

- Автоматизация на базе API, встроенная система аналитики

- Безопасность как основной элемент интегрированный в платформу

- Механизмы автоматического восстановления неисправностей

Эти фишки будут раскрыты более детально чуть ниже по тексту

Гиперконвергентность

Существует несколько мнений, что же такое Гиперконвергентность Чаще всего это зависит от компонентов, о которых идет речь (например виртуализация, сеть и т.д.). Основная концепция: максимальная интеграция нескольких компонентов в единое решение. Чтобы достичь максимальной интеграции компоненты должны быть доработаны или разработаны именно так, чтобы идеально подходить друг другу. В случае Nutanix мы интегрируем хранилище и вычислительные мощности в узлы, которые являются основой нашего решения. Для других это могут быть, например, хранилище и сеть и так далее.

Итого, гиперконвергентность это:

- Максимальная интеграция двух или более компонент в единое решение, которое может легко масштабироваться

Преимущества:

- Стандартная единица масштабирования

- Локализация операций ввода/вывода

- Исключение классических вычислительных узлов и СХД

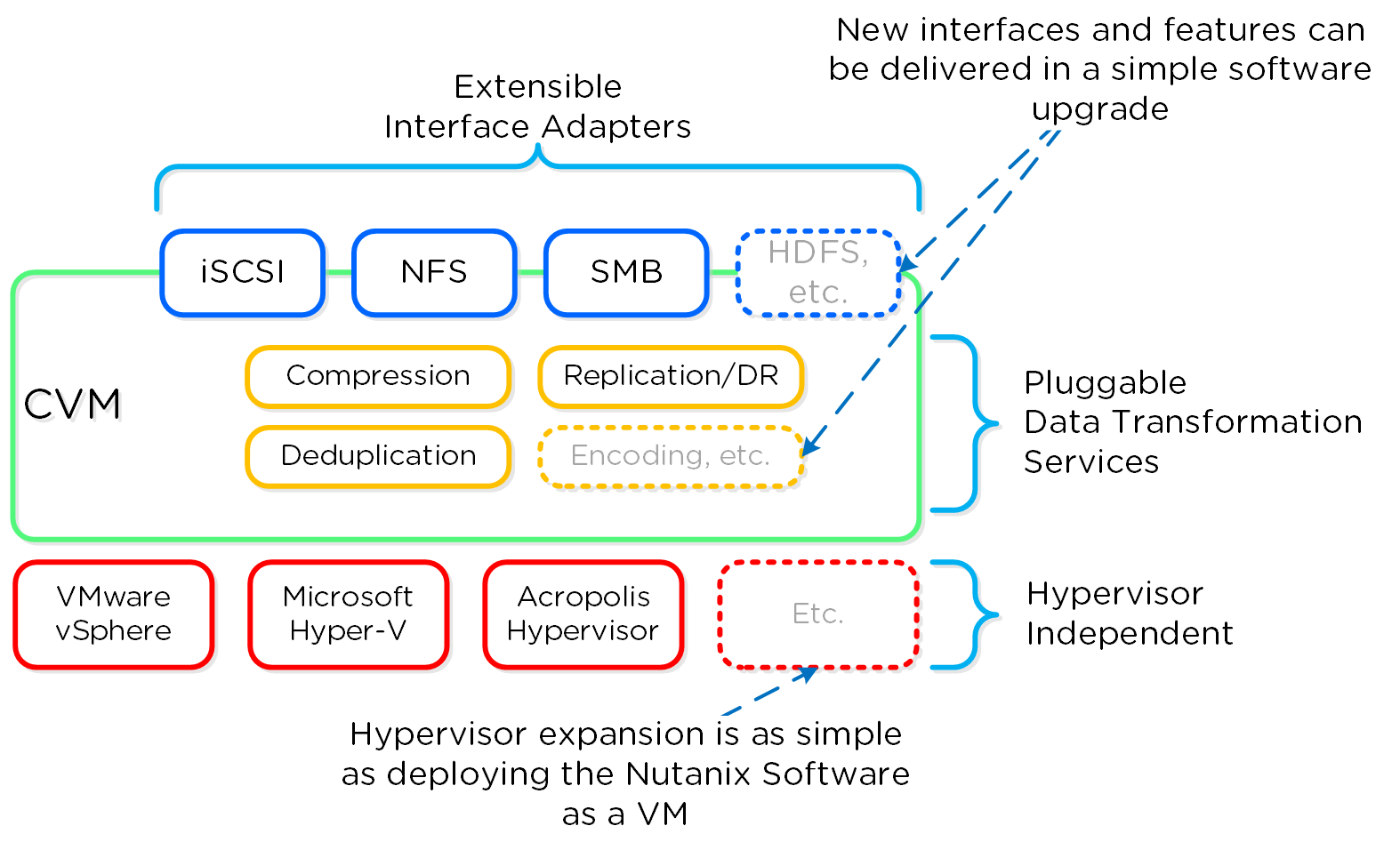

Программно-определяемые решения

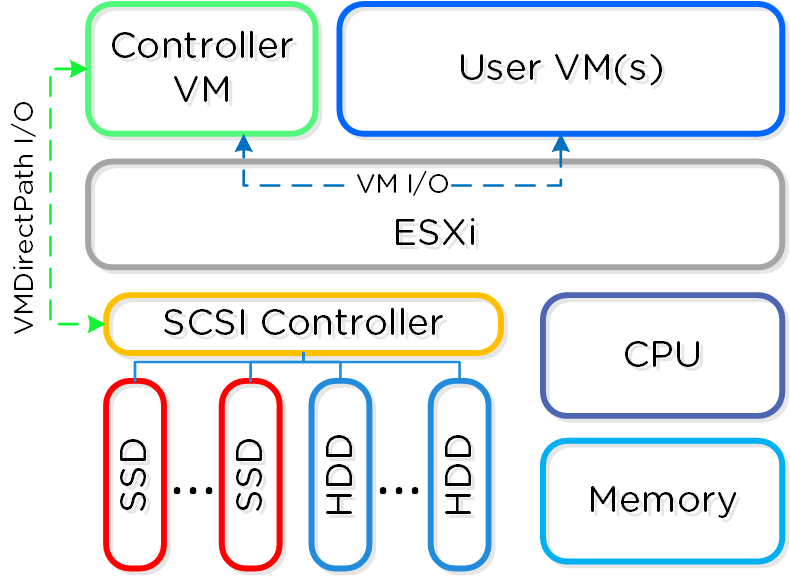

Программно-определяемые решения берут на себя задачи и основную логику, обычно присущую аппаратным компонентам и выполняются в рамках обычного серверного оборудования. В Nutanix мы взяли логику хранилища (RAID, дедупликацию, компрессию, и так далее) и перенесли ее в свое ПО, которое выполняется на каждой CVM - Nutanix Controller VMs

Примечание

Поддерживаемые архитектуры

Решение Nutanix поддерживает x86 и IBM POWER

Что все это означает:

- Мы перенесли ключевую логику с уровня аппаратного обеспечения на уровень ПО, которое может работать на любом серверном оборудовании

Преимущества:

- Быстрый релизный цикл

- Устранение зависимости от оборудования конкретного производителя

- Использование стандартного оборудования дешевле

- Длительный срок службы и защита инвестиций

Уточним последний пункт: старое оборудование может позволять новейшему и самому передовому ПО работать. Т.е. даже на оборудовании, срок службы которого ограничен, будут выходить и прекрасно работать обновления.

Распределенные автономные системы

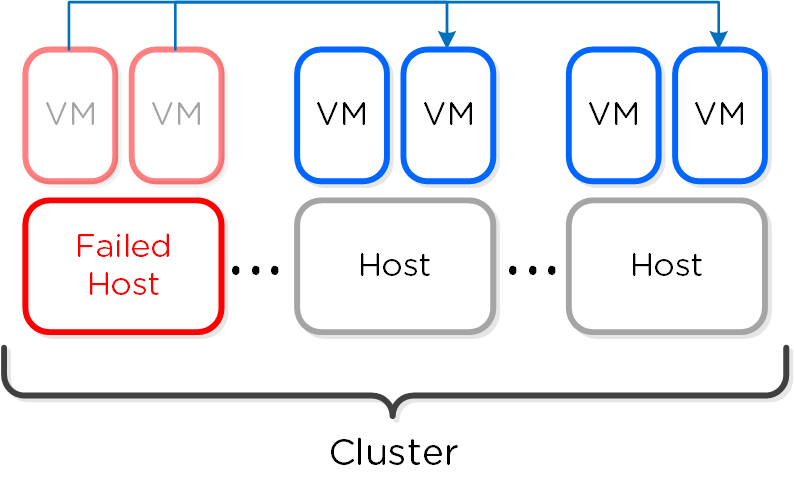

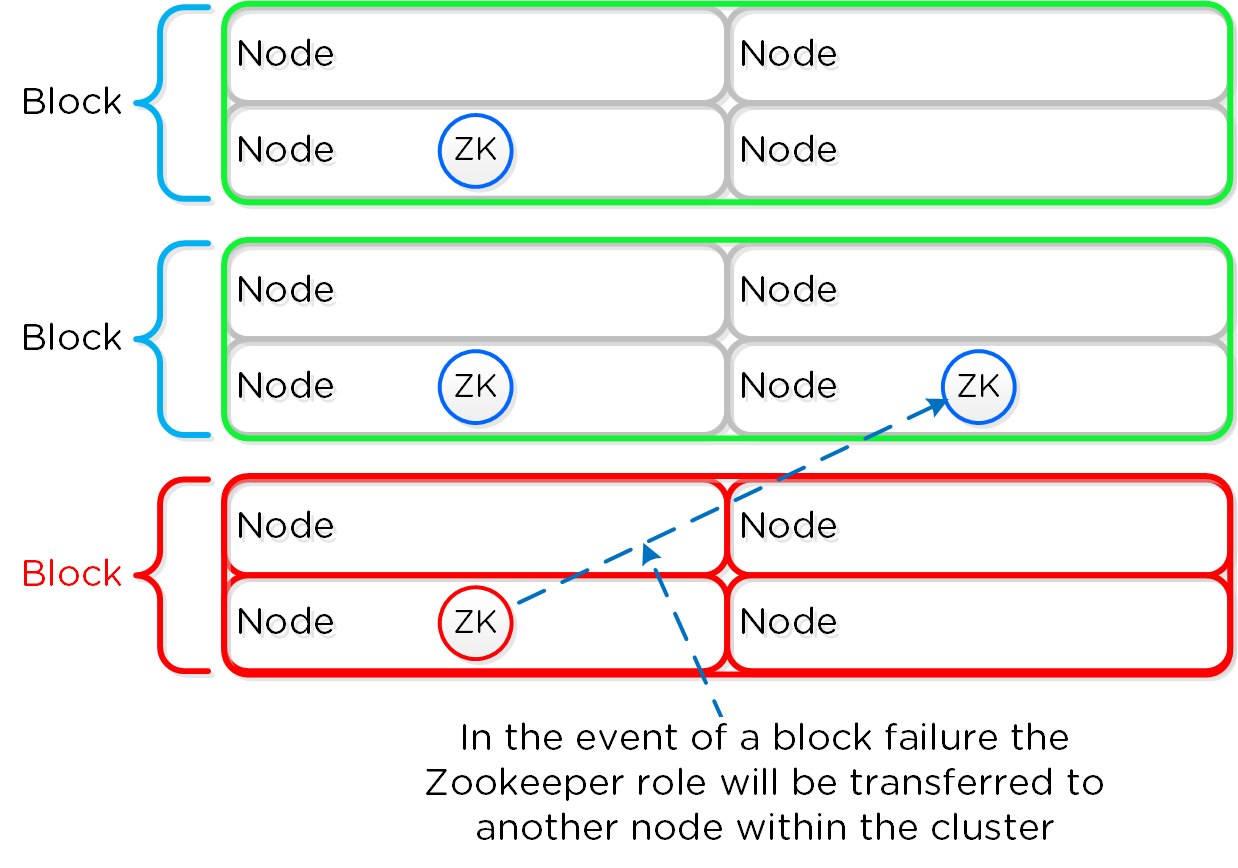

Распределенные автономные системы предполагают отказ от выделения каких-либо ролей и компонентов, вместо этого роль равномерно распределяется между всеми узлами и экземплярами ПО Вы можете представлять себе это, как простую распределенную систему. Классические производители предполагали, что оборудование будет достаточно надежным, и в большинстве случаев так оно и было. Однако, распределенная система по умолчанию предполагает, что оборудование рано или поздно придет в негодность, а ПО решит любую проблему без прерывания сервиса.

Распределённые системы были разработаны так, чтобы решать свои задачи локально на каждом узле, поддерживая при этом работоспособность остального кластера и сервисов функционирующих в его рамках Т.е. если ПО получит сообщение, что какой-то аппаратный или программный компонент сбоит то оно обработает ошибку и продолжит функционировать. Система оповещения сообщить пользователям о событии, и вместо остановки сервиса будет ожидать вмешательства администратора (например, ждать замены узла). При этом администратор, может осуществить переборку кластера без замены компонента. Если же речь идет о экземпляре ПО, которое являлось на данный момент "Мастером", то все еще проще - будет выбран новый мастер и все продолжит функционировать. Для распределения задач между экземплярами ПО используется концепция MapReduce.

Что все это означает:

- Распределение ролей и обязанностей между всеми узлами кластера

- Использование концепции MapReduce для равномерного распределения задач

- Запуск процессов выбора нового Мастера, если это необходимо

Преимущества:

- Исключение любых точек отказа (SPOF)

- Распределение нагрузки, для устранения узких мест

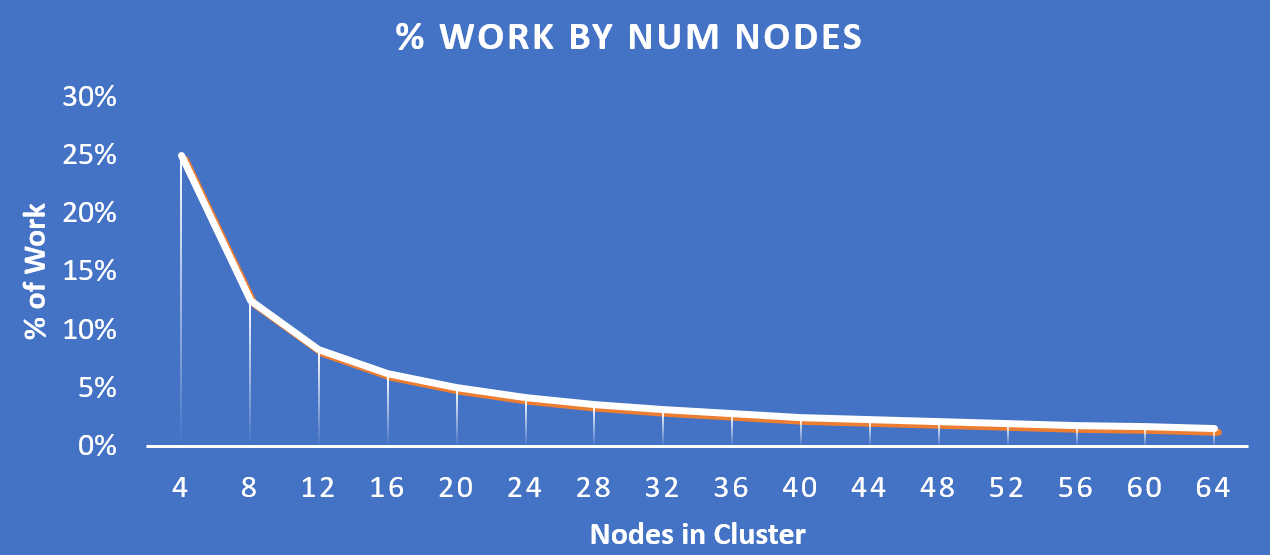

Постепенное, линейное масштабирование

Постепенное, линейное масштабирование предполагает возможность начать работу с минимально необходимым количеством ресурса, добавляя их по мере роста потребностей. Все конструкции, о которых говорилось раньше направлены на реализацию этой функциональности. Обычно существует три уровня компонент - вычислительная подсистема, хранилище и сеть. Все они масштабируются независимо друг от друга. Например, если вы добавляете новых серверов, вы не увеличиваете при этом производительность и емкость хранилища. А с платформой Nutanix вы одновременно масштабируете:

- Количество гипервизоров / вычислительных узлов

- Количество контроллеров хранилища

- Производительность вычислительных узлов / емкость хранилища

- Число узлов, участвующих в операциях в рамках кластера

Что все это означает:

- Возможность постепенно масштабирования хранилища и вычислительных мощностей, с линейным увеличением производительности и доступности.

Преимущества:

- Возможность начать с малого количества ресурсов и масштабироваться до требуемого

- Равномерное и последовательное увеличение производительности

Все это очень важно!

Итого:

- Неэффективное использование вычислительных ресурсов привело к переходу на виртуализацию

- Функции vMotion, HA и DRS привели к необходимости централизованного хранения

- Рост нагрузки на виртуальные машины привел к увеличению нагрузки и конкуренции на хранилище

- SSDs пришли, чтобы исправить ситуацию с производительностью, но сместили узкое место в сторону сети и контроллеров

- Доступ к кэшам и памяти по сети порождает большие накладные расходы, который сводят к минимуму плюсы

- Сложность конфигурации СХД остается прежней

- Кэширование на уровне серверов пришло, чтобы снять нагрузку на хранилище. Однако, это еще один компонент и точка отказа

- Локализация операций с данными позволяет избавится от узких мест и сгладить ситуацию с накладными расходами

- Сдвигается фокус от инфраструктуры к легкости управления, упрощается стек

- Рождается новый мир Web-Scale!

Part II. Книга веб-интерфейса Prism

prism - /'prizɘm/ - noun - панель управления

простой интерфейс для управления всей платформой Nutanix и центром обработки данных.

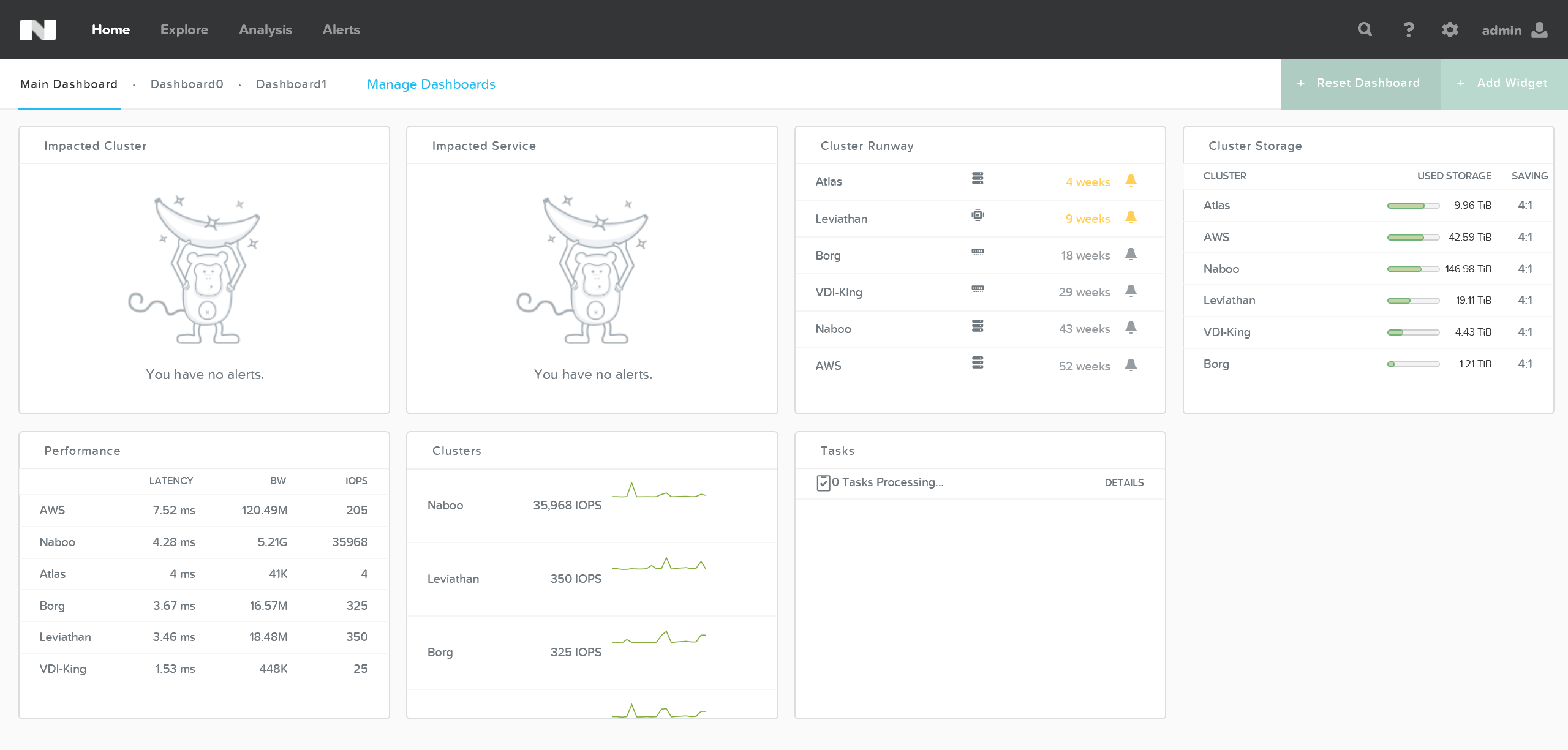

Методология проектирования

Важнейшей нашей целью является создание красивого, отзывчивого и интуитивного интерфейса. Данный интерфейс является одним из самых важных компонентов платформы Nutanix. Мы относимся к нему очень серьезно. В этом разделе будет рассказано о нашей методологии проектирования, о том, к чему мы движемся. Уже скоро этот раздел будет дополнен!

А пока - почитайте прекрасный пост от создателя этого интерфейса и руководителя направления промышленного дизайна Джереми Салли - http://salleedesign.com/stuff/sdwip/blog/nutanix-case-study/

Фигуры для редактора Visio доступны по ссылке: http://www.visiocafe.com/nutanix.htm

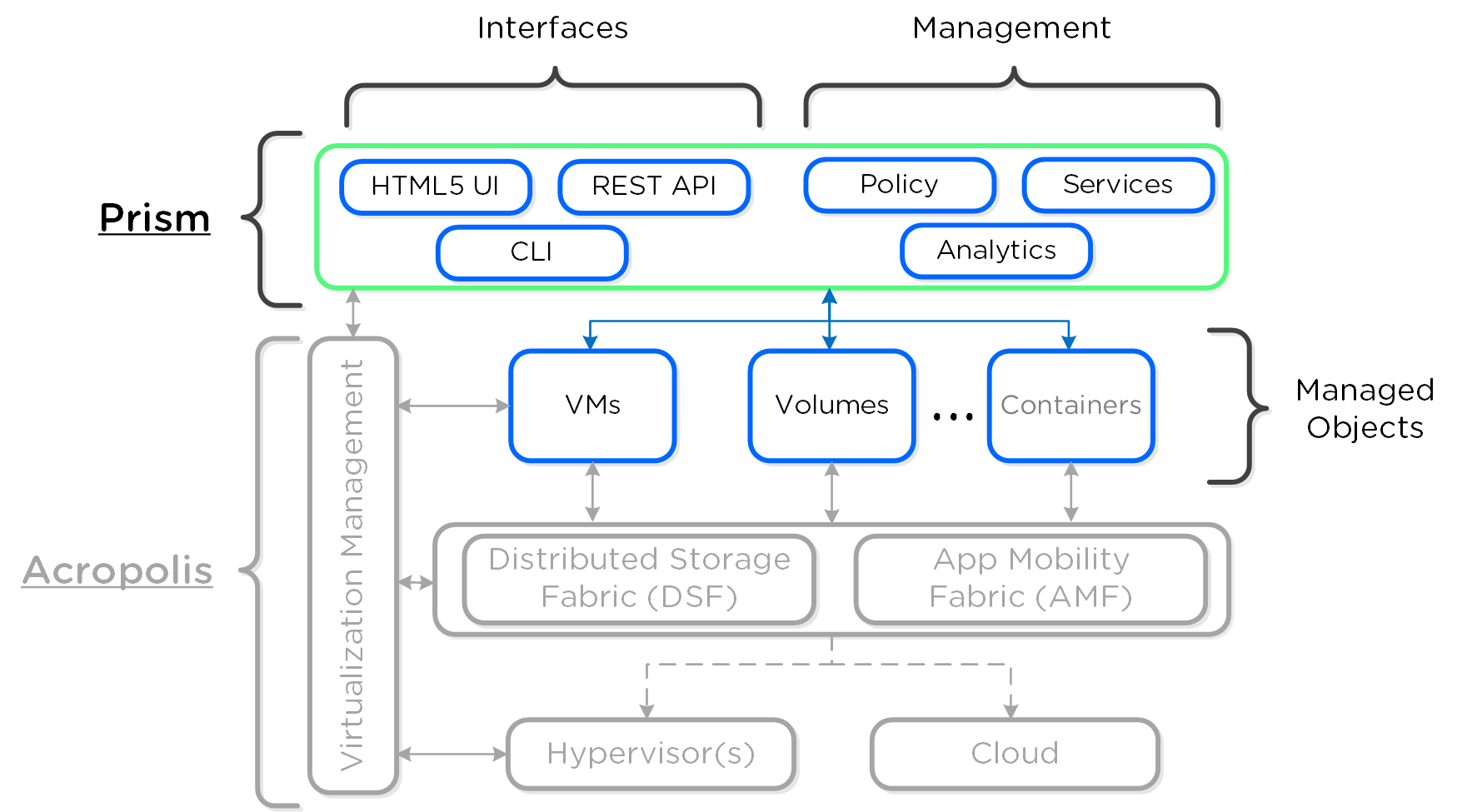

Архитектура

Prism - распределенная система управления, которая позволяет пользователям управлять объектами платформы Nutanix и следить за их состоянием.

Систему управления можно разделить на две основных части:

- Интерфейсы

- HTML5 UI, REST API, CLI, PowerShell CMDlets, и так далее.

- Управление

- Определение и соблюдение политик, разработка и статус услуг, аналитика и мониторинг

На рисунке изображена компонентная архитектура Prism как части платформы Nutanix:

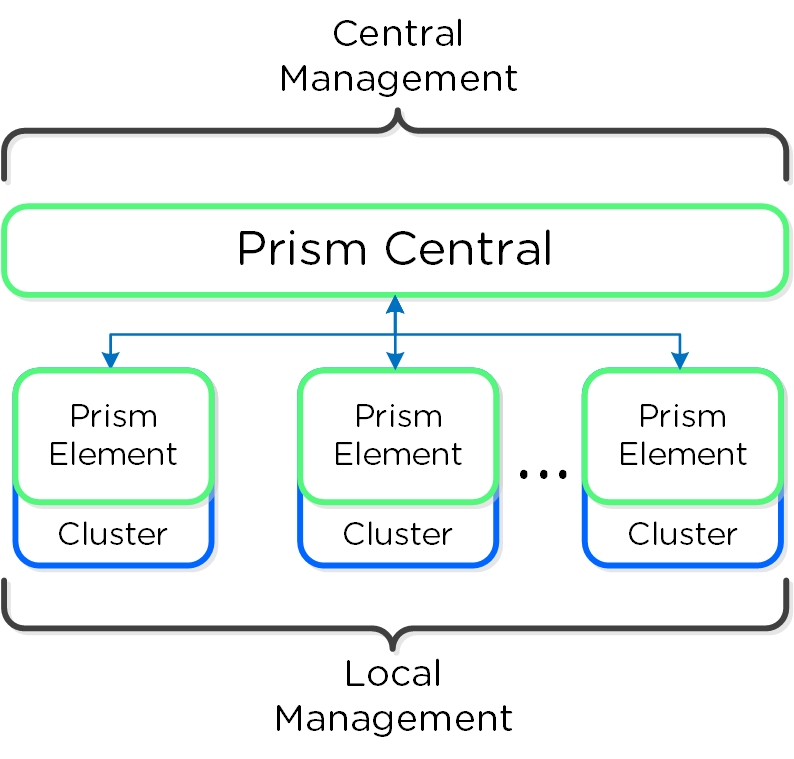

Prism делится на два продукта:

- Prism Central (PC)

- Система управления несколькими кластерами Acropolis посредством единого централизованного интерфейса. Это опциональное ПО поставляемое в виде ВМ

- Управление несколькими кластерами одновременно

- Prism Element (PE)

- Интерфейс для управления конкретным кластером. Данное ПО является частью любого кластера Nutanix.

- Управление одним, конкретным кластером

На рисунке изображена схема взаимодействия ПО Prism Central и Prism Element:

Примечание

Совет от создателей

Для больших, распределенных инсталляций рекомендуется использовать Prism Central для упрощения управления инфраструктурой через единую точку входа.

Сервисы Prism

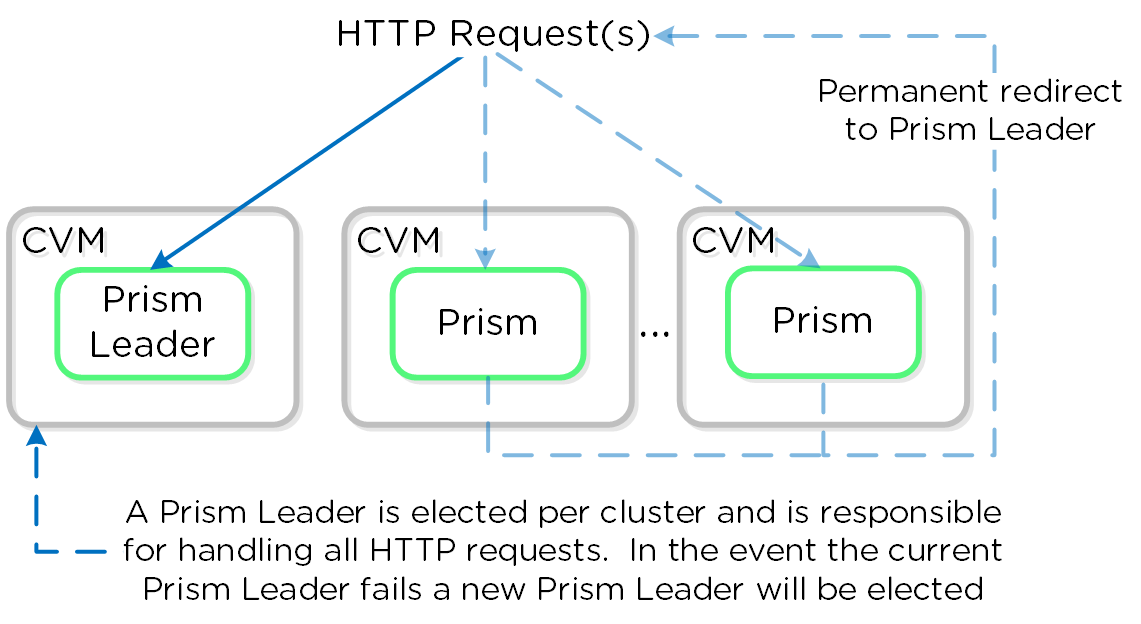

Сервисы Prism выполняются на всех CVM. Среди копий сервиса определяется Мастер, который отвечает за обработку HTTP запросов. В случае каких-либо проблем с текущим Мастер-сервисом данная роль будет передана другой копии сервиса в кластере. Это относится ко всем компонентам ПО Nutanix, имеющим такую архитектуру. Если пользовательский запрос приходит не на Мастер-сервис - он будет перенаправлен Мастеру, с использованием HTTP ответа с кодом 301.

Ниже показано, как сервисы Prism обрабатывают HTTP запросы:

Примечание

Порты Prism

Prism слушает порты 80 и 9440, если трафик HTTP приходит на порт 80 он будет автоматически перенаправлен на порт HTTPS - 9440.

Если используется выделенный внешний адрес для доступа к Prism (рекомендуется), он всегда будет на Мастер-сервисе. В случае выхода из строя текущего Мастер-сервиса, адрес переместится на нового Мастера, а встроенные механизмы работы с ARP (gARP) будут использованы для удаления старых записей о физическом адресе устройства. Проще говоря - кластер всегда будет доступен по одному и тому же адресу.

Примечание

Совет от создателей

Вы можете определить где сейчас находится Мастер-сервис путем выполнения команды 'curl localhost:2019/prism/leader' на любой из CVM кластера Nutanix.

Использование Prism

В следующих разделах мы рассмотрим некоторые пути использования интерфейса Prism, а так же сценарии устранения неполадок.

Обновление ПО Nutanix

Обновление ПО Nutanix очень простой процесс.

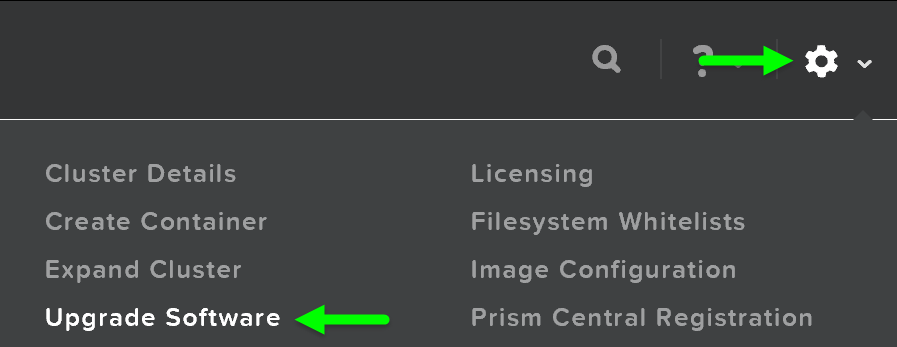

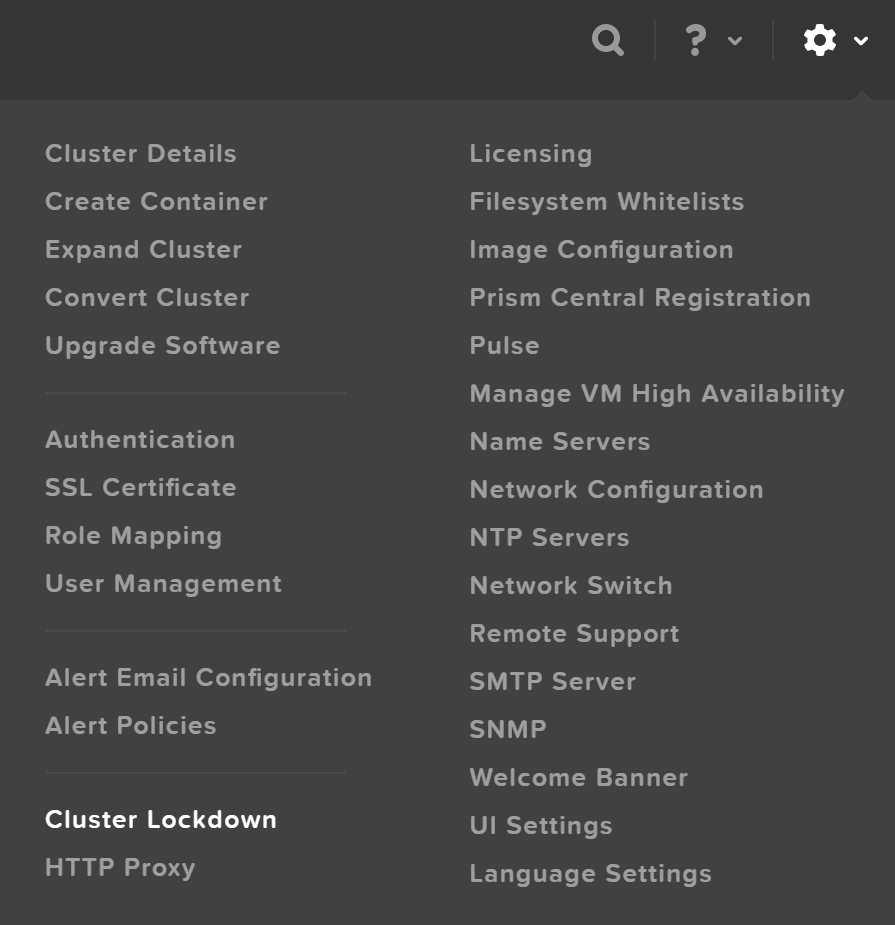

Нужно зайти в Prism и нажать на иконку с шестеренкой в правом верхнем углу экрана, или же нажав клавишу 'S'. Затем выбрать пункт 'Upgrade Software':

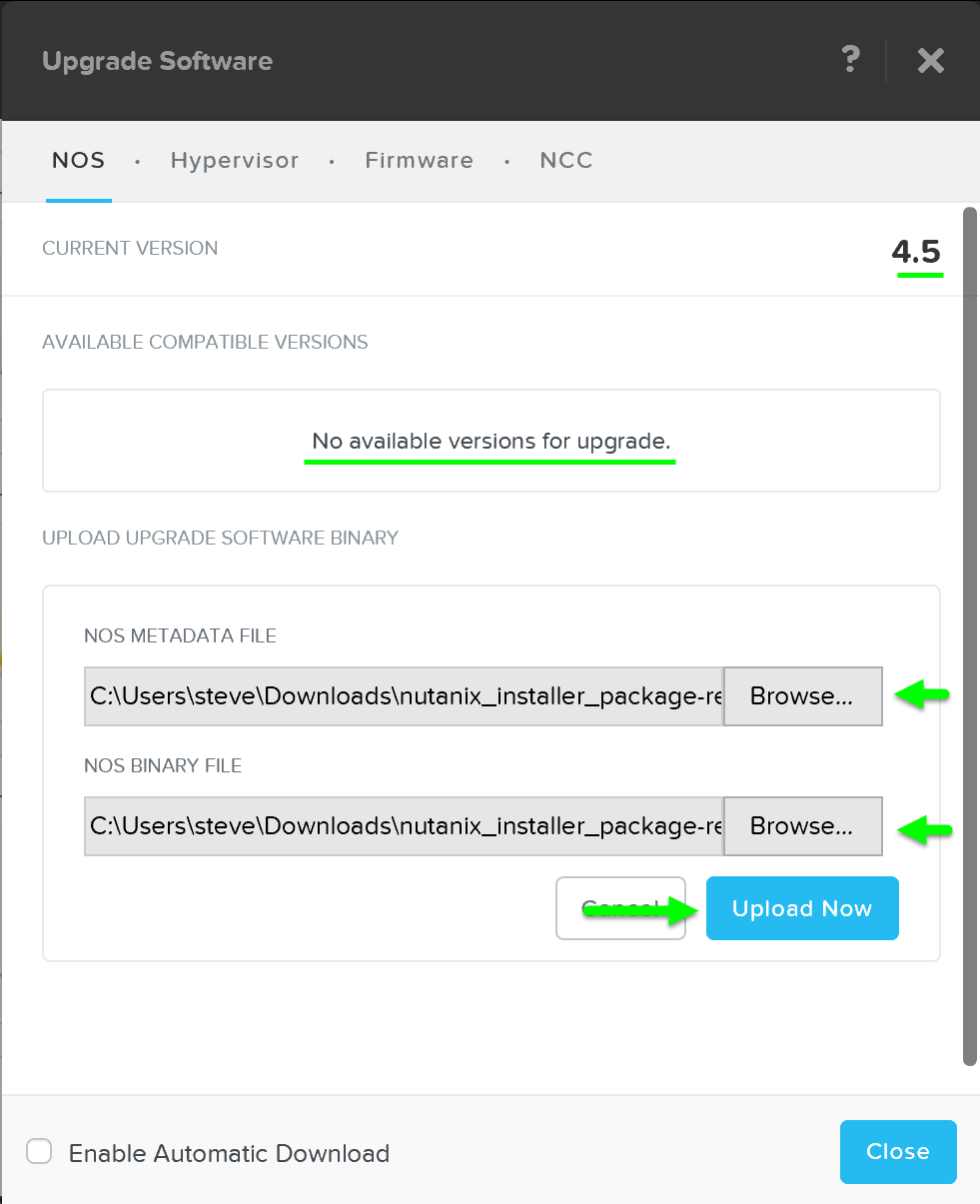

Эти действия запустят процесс обновления ПО, и Вы увидите окно 'Upgrade Software' где будет показана текущая версия ПО и новая версия, если она доступна. Также можно осуществить загрузку обновлений NOS вручную.

Затем можно получить обновление автоматически с ресурсов Nutanix или загрузить обновление вручную:

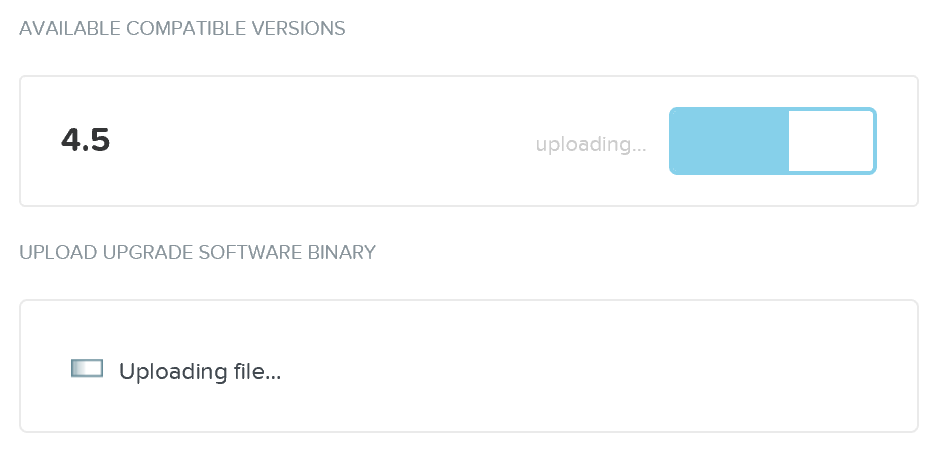

Обновление ПО будет загружено на служебные ВМ Nutanix (CVMs):

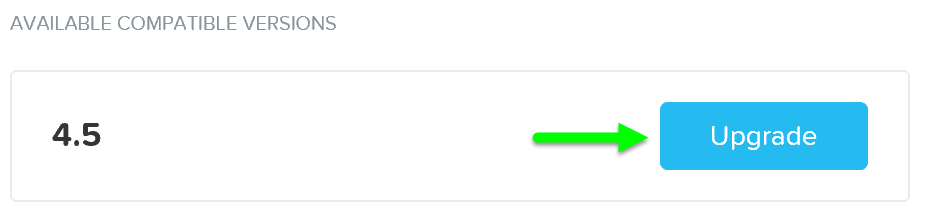

Когда ПО будет загружено - можно нажать на кнопку 'Upgrade' для начала процесса обновления:

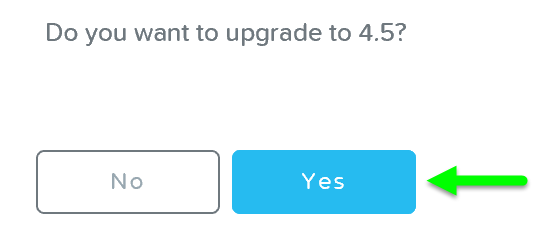

Система покажет окно подтверждения действия:

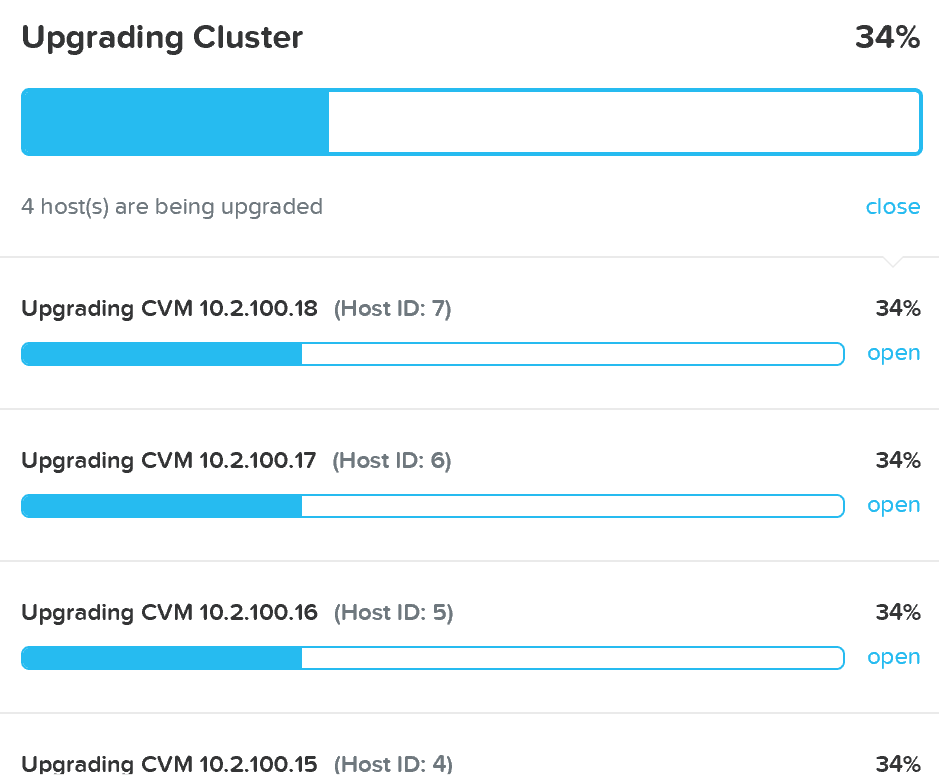

Процесс установки новой версии начнется с проверки готовности платформы к обновлению:

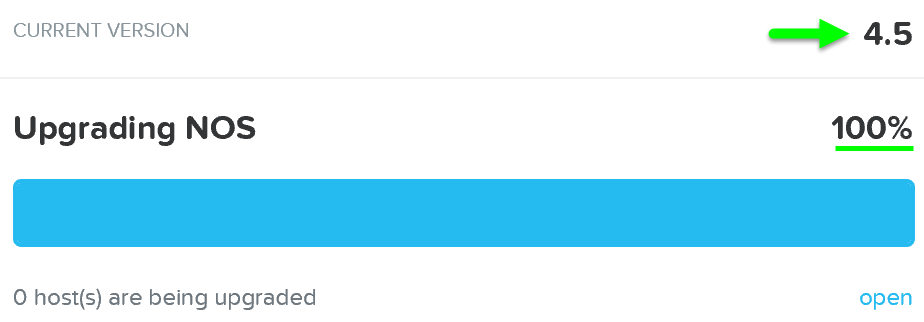

Как только обновление буде завершено - статус процесса изменится соответствующим образом, Платформа получит доступ ко всем новым функциям свежей версии ПО:

Примечание

Примечание

Текущая пользовательская сессия Prism может быть прервана на короткое время, в момент обновления текущего Мастер-сервиса. Все пользовательские ВМ продолжат работать без прерывания.

Обновление гипервизора

Обновление гипервизора полностью автоматическое и выполняется через Prism.

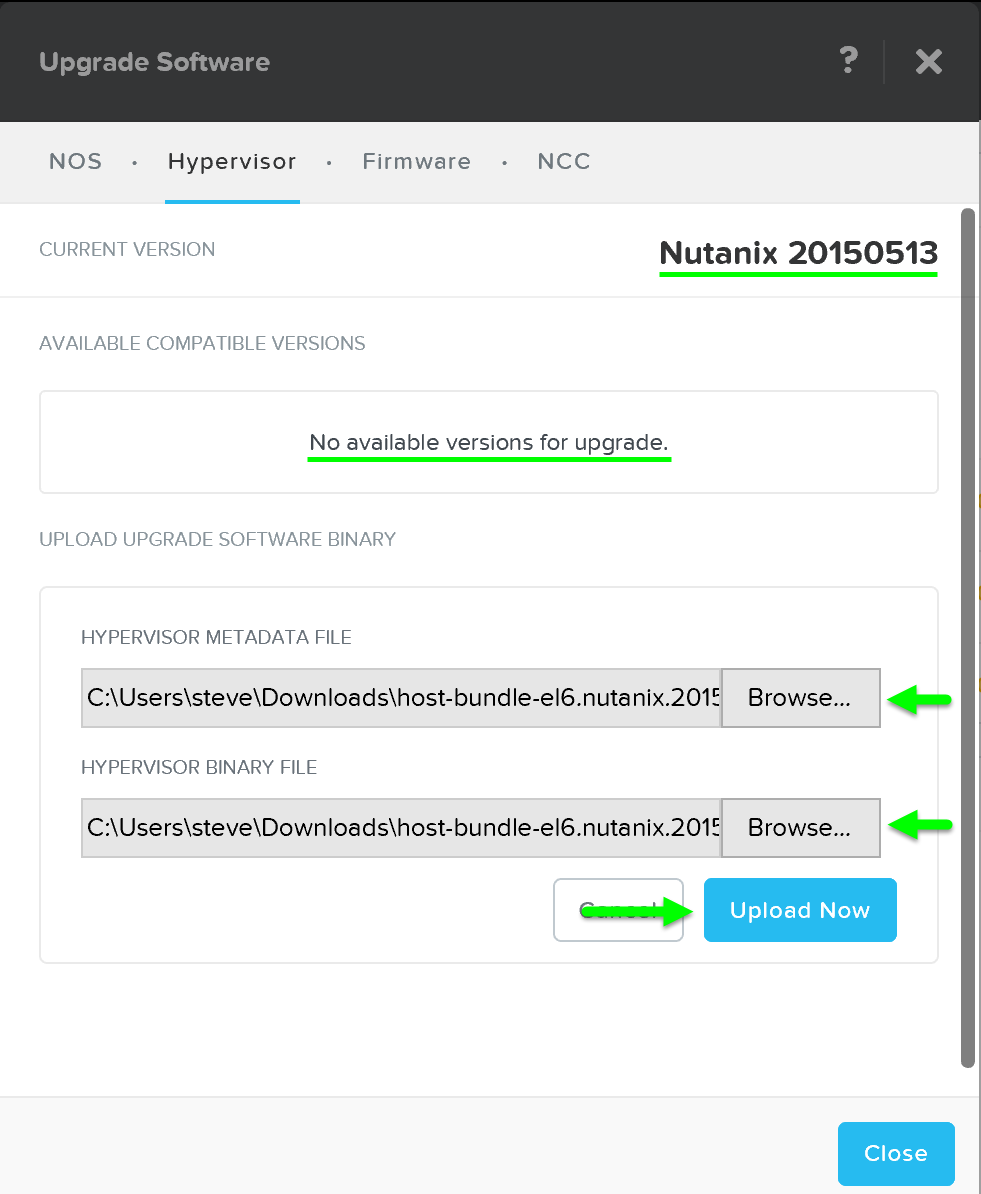

Для начала обновления Вы должны выполнить такие же действия - перейти в меню 'Upgrade Software' и выбрать пункт 'Hypervisor'.

Обновление может быть загружено автоматически с ресурсов Nutanix или вручную:

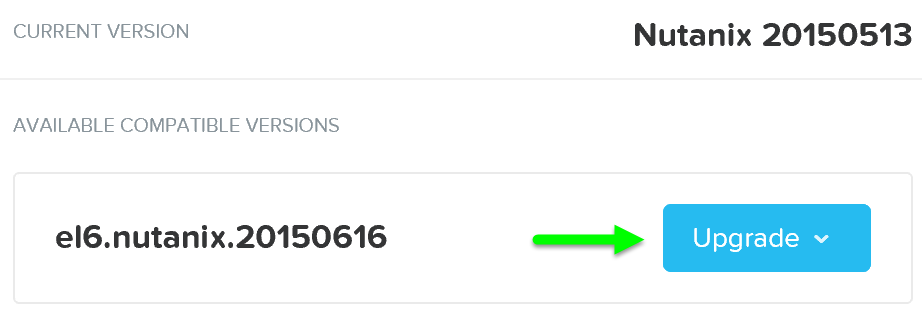

Начнется загрузка обновления ПО на Гипервизоры. Как только ПО будет загружено - нажмите 'Upgrade' для начала процесса обновления:

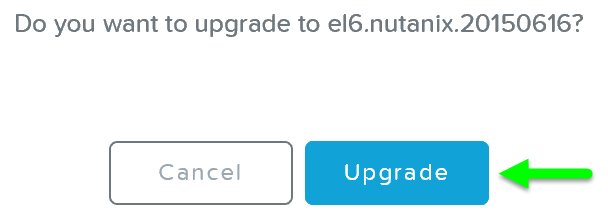

Затем будет показано следующее окно подтверждения:

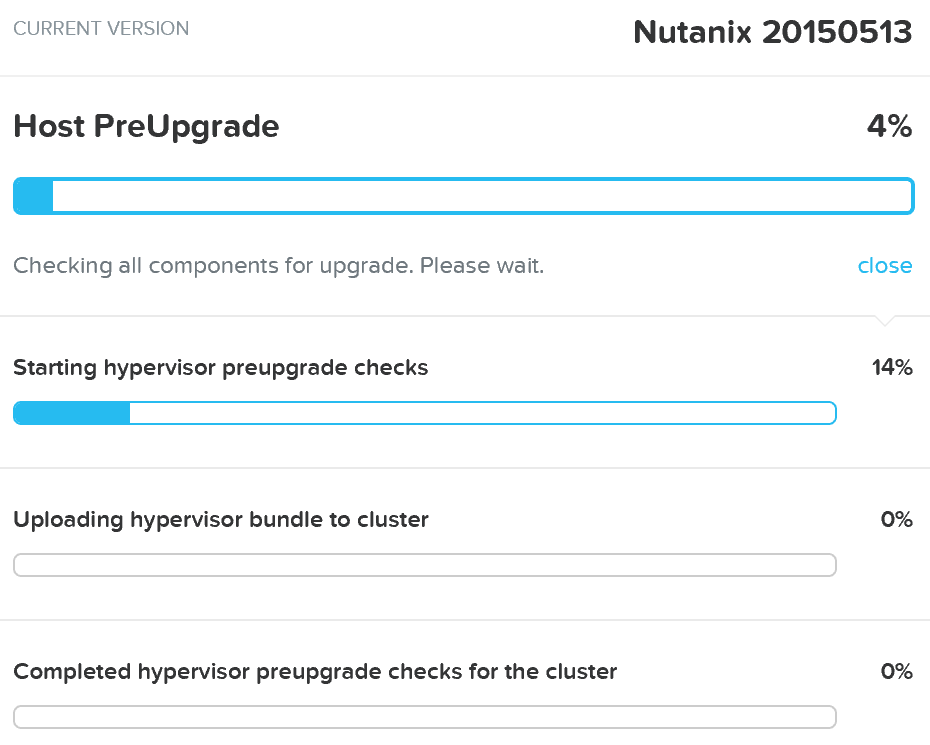

Платформа начнет проверять гипервизоры в составе кластера и размещать на узлах дистрибутив новой версии ПО:

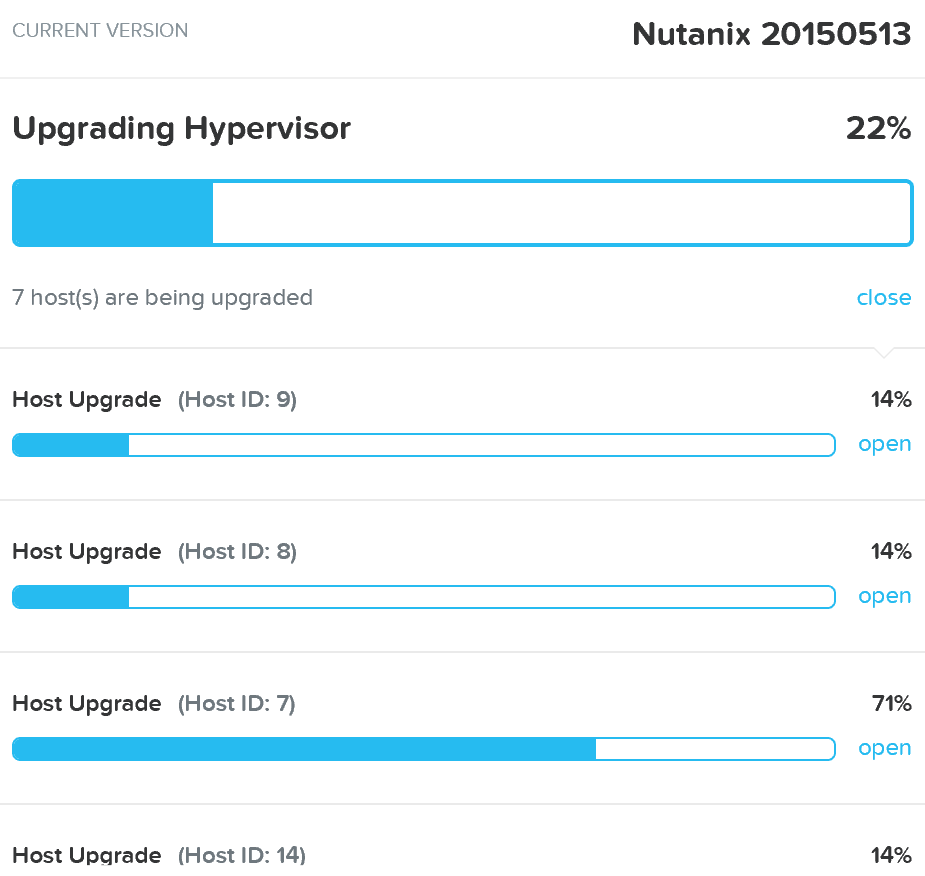

Когда проверки будут закончены и все служебные действия завершены начнется сам процесс обновления ПО:

Гипервизоры обновляются по очереди, ВМ работают без прерываний. ВМ будут перемещаться между узлами, с использованием функции живой миграции. После обновления каждый узел будет перезагружен. Этот процесс будет выполнен для каждого узла в кластере.

Примечание

Совет от создателей

Вы можете проверить статус обновления ПО через командную строку CVM выполнив 'host_upgrade --status'. Детальная информация о обновлении конкретного узла расположена здесь ~/data/logs/host_upgrade.out

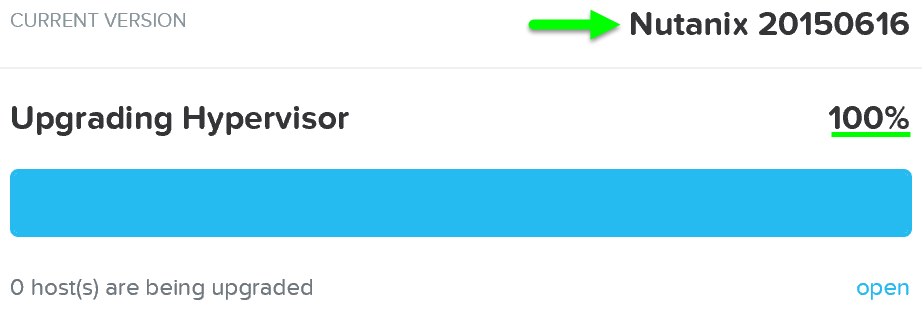

Как только обновление закончится - вы получите доступ ко всем новым возможностям новой версии гипервизора:

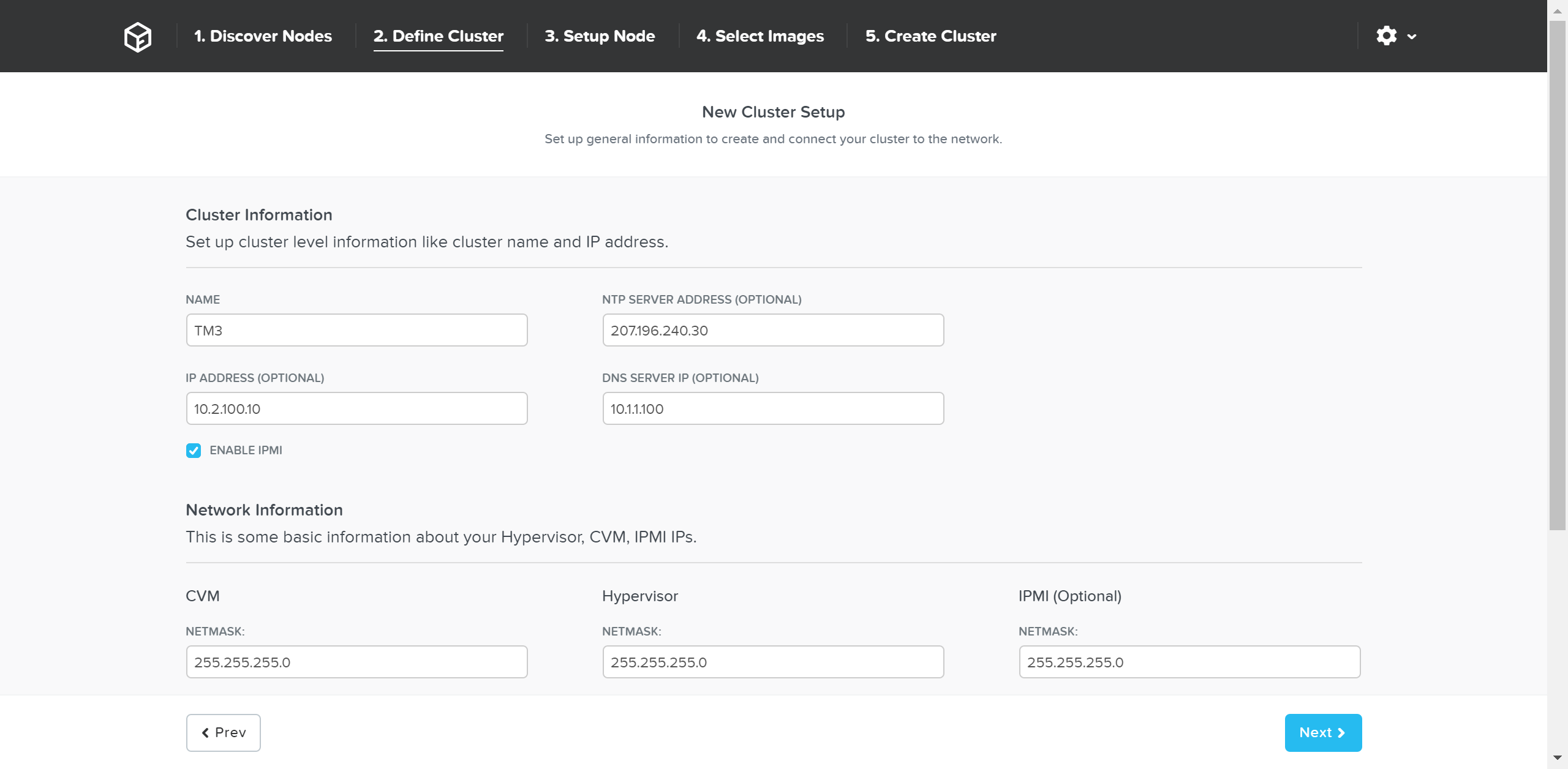

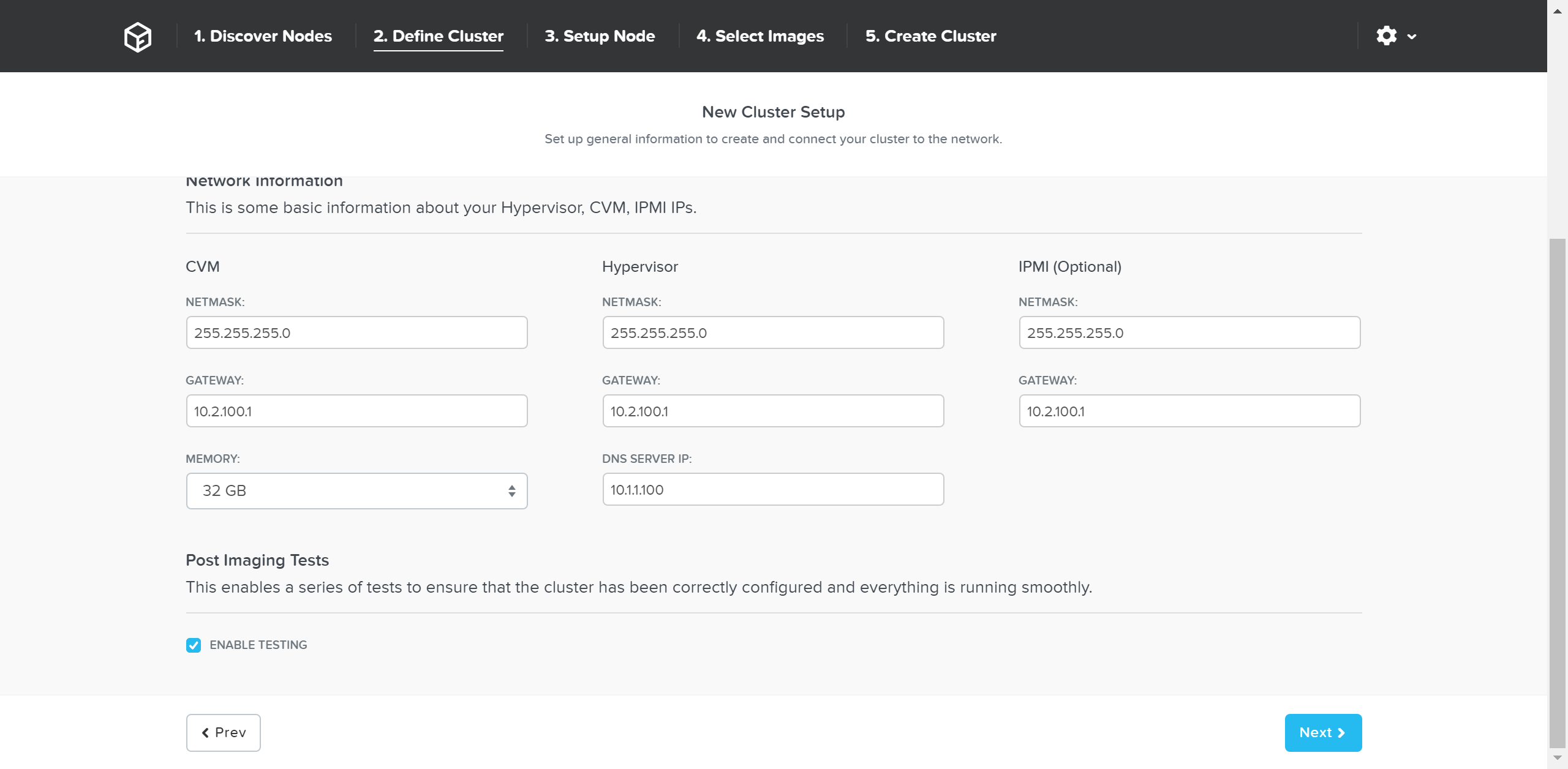

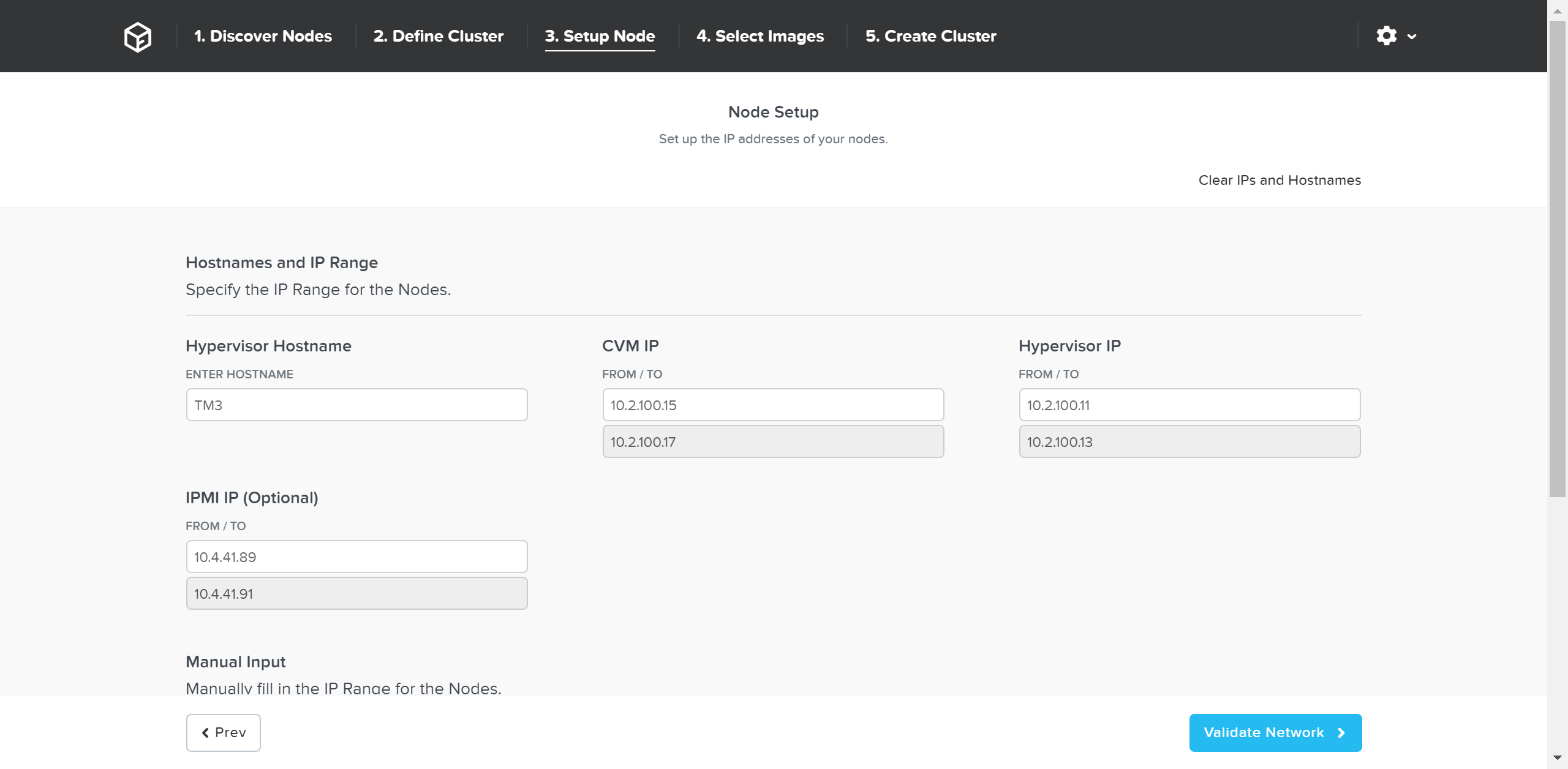

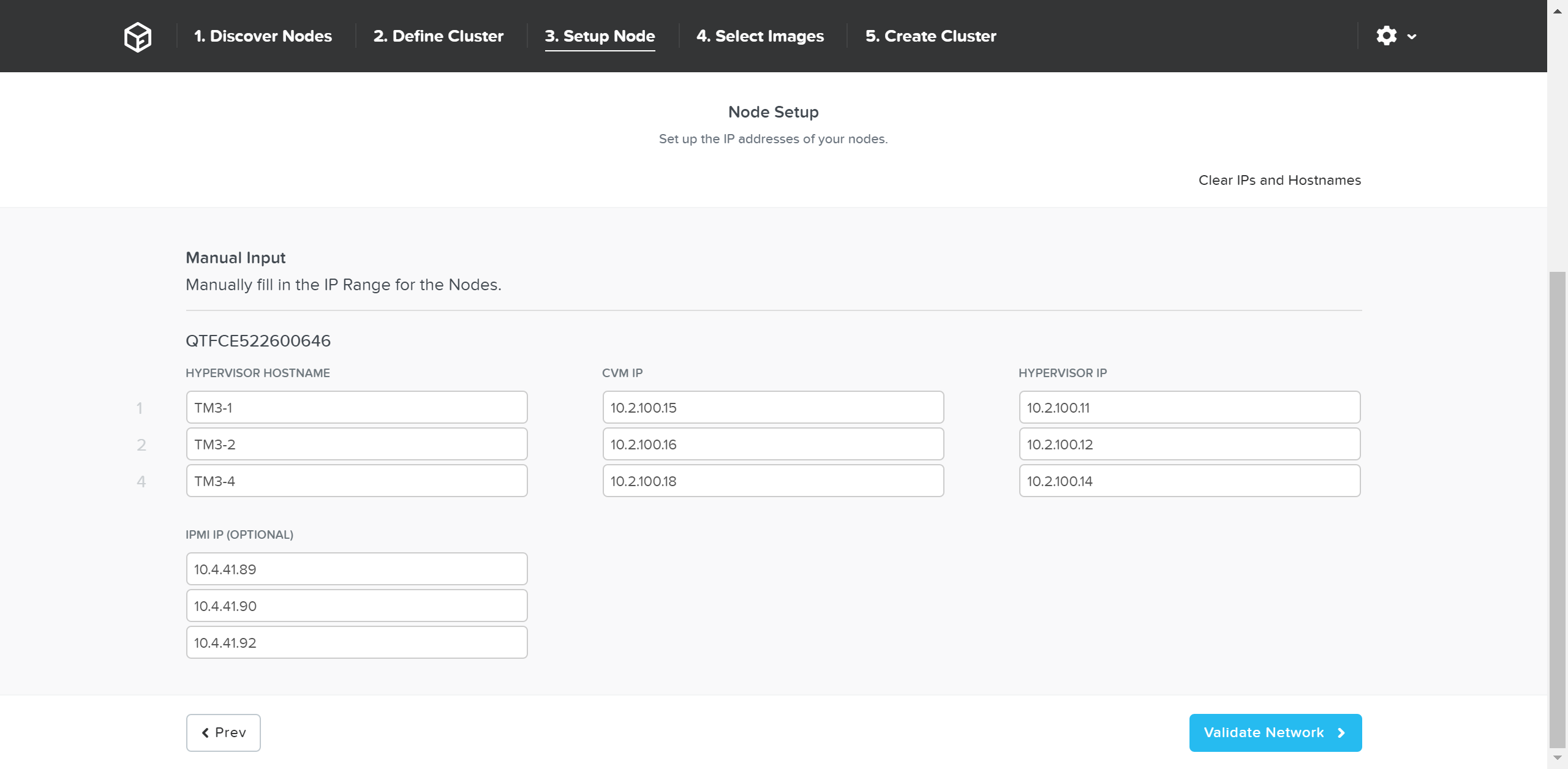

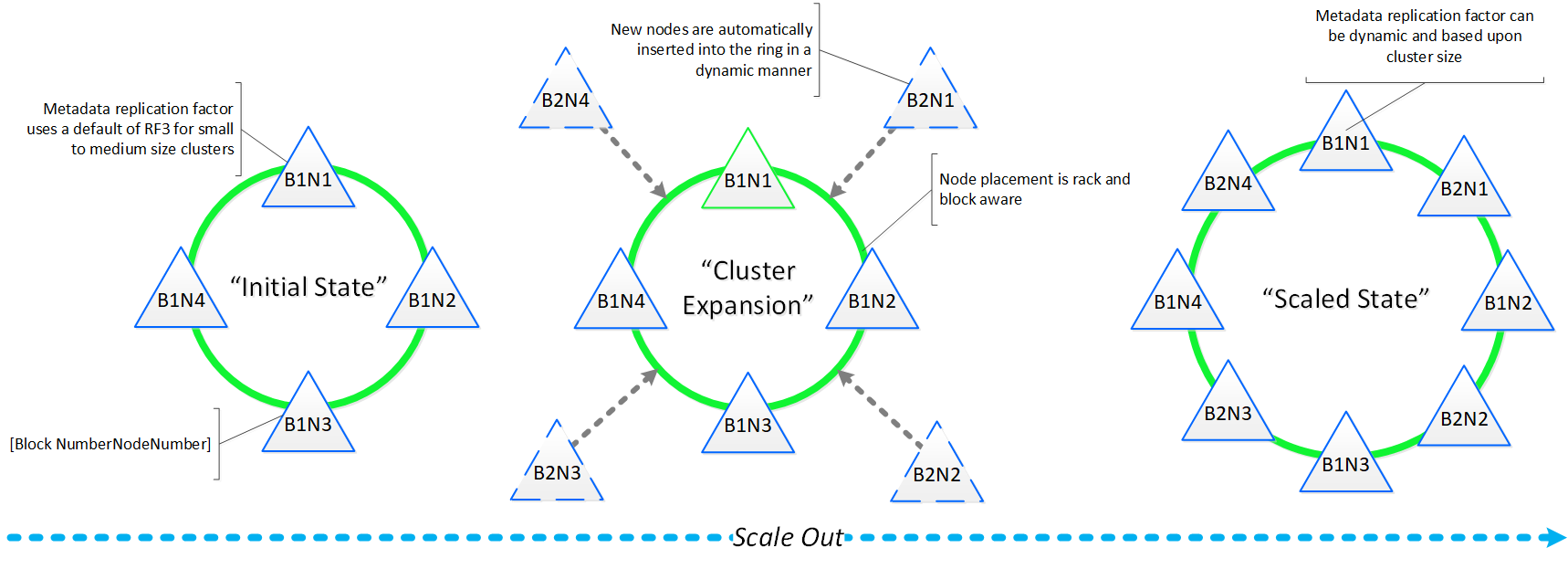

Масштабирование кластера

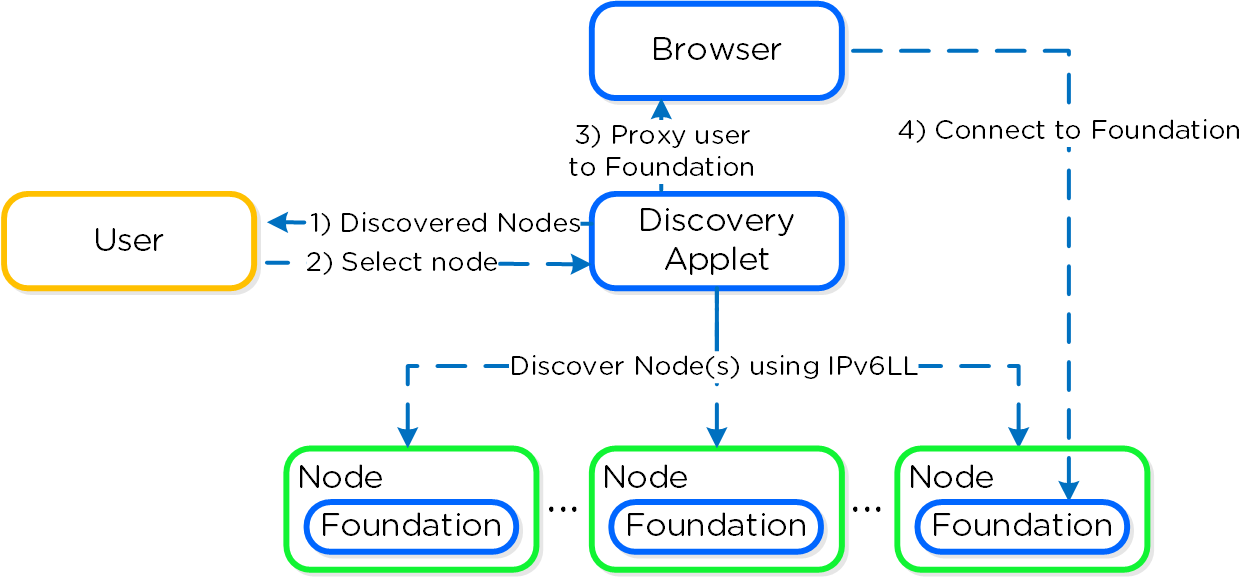

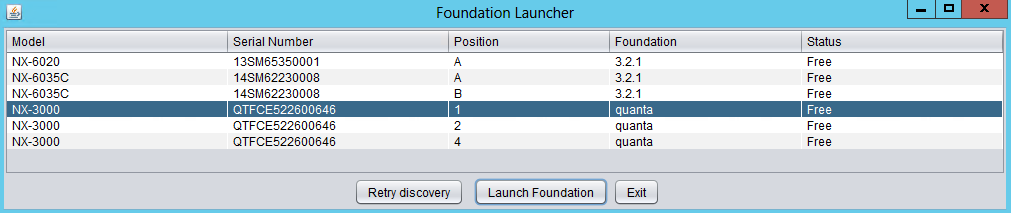

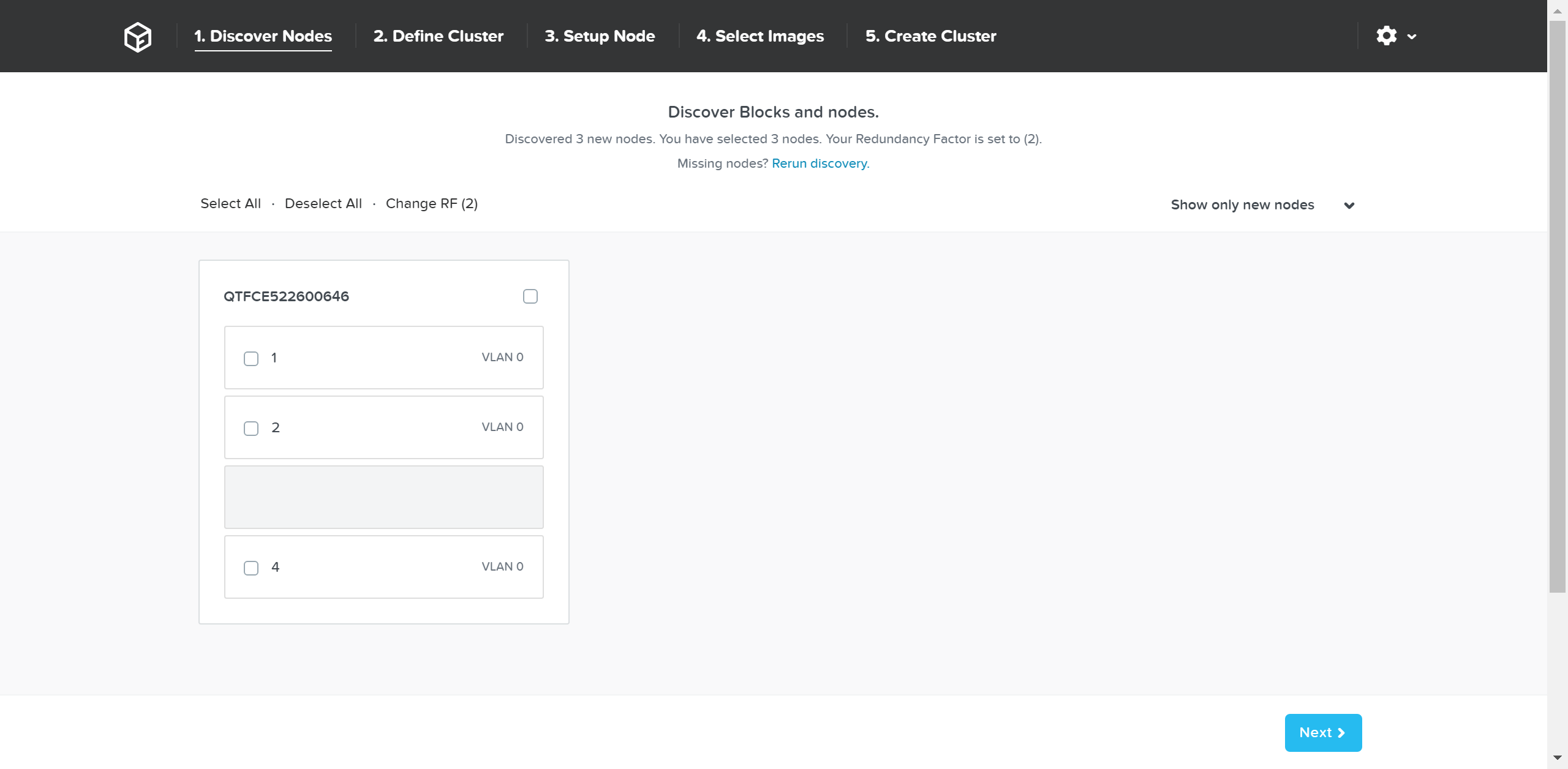

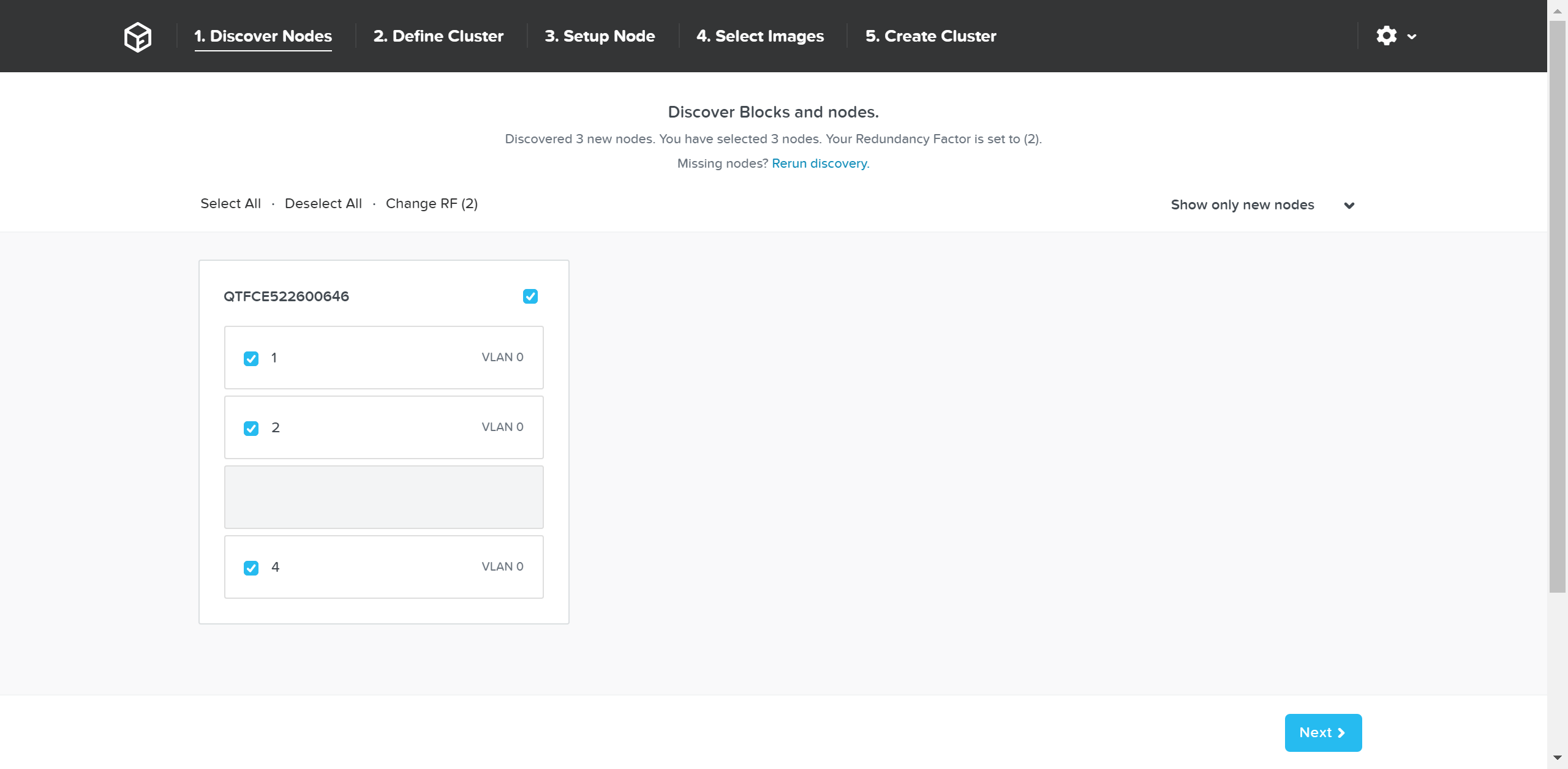

Возможность динамического масштабирования - ключевая функция кластеров Acropolis. Для масштабирования кластера Acropolis просто смонтируйте оборудование, подключите его к сети и нажмите на кнопку питания. Как только узел будет запущен - он будет найден посредством mDNS.

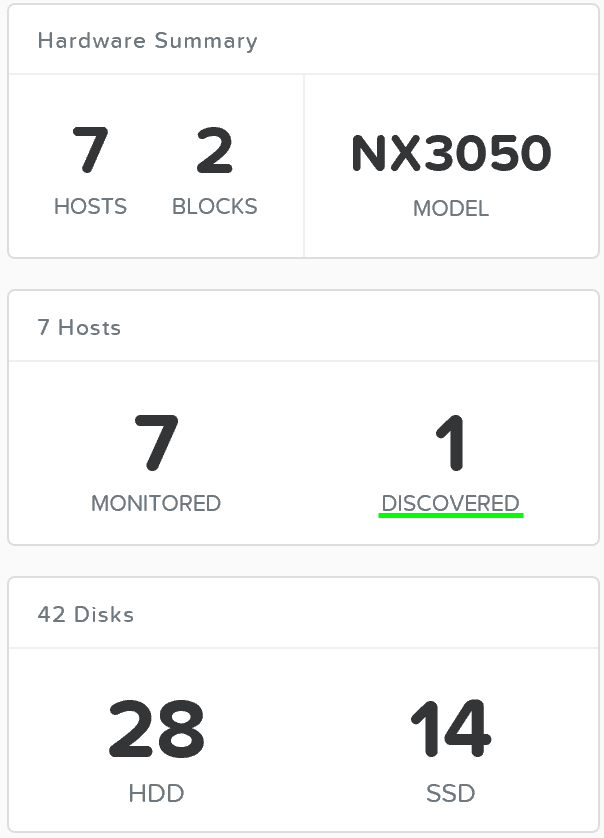

На рисунке изображен пример найденного узла, готового для добавления в кластер:

Множество узлов могут быть найдены и добавлены в кластер единовременно.

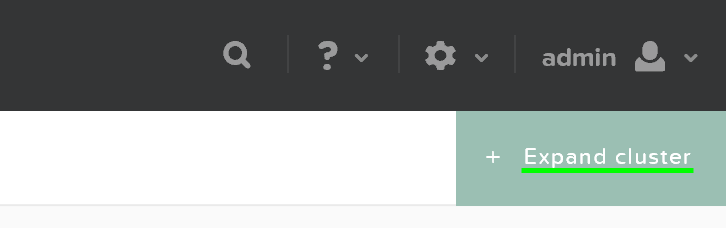

Как только узлы найдены вы можете начинать процесс масштабирования, нажав на кнопку 'Expand Cluster' доступную в правом верхнем углу на странице 'Hardware':

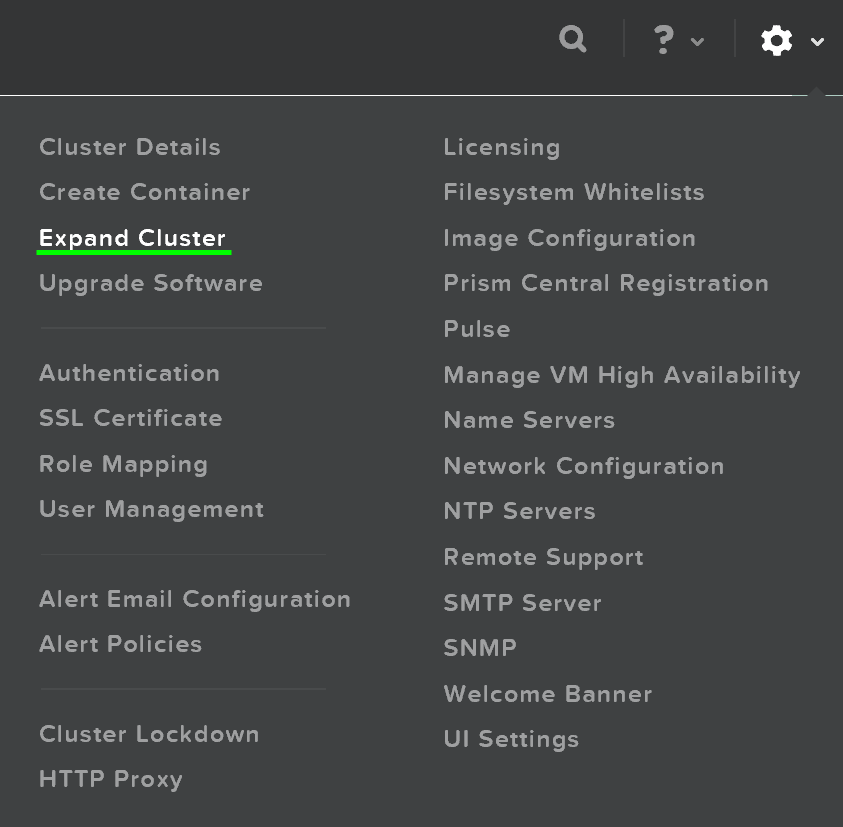

Также, можно запустить процесс масштабирования из меню настройки:

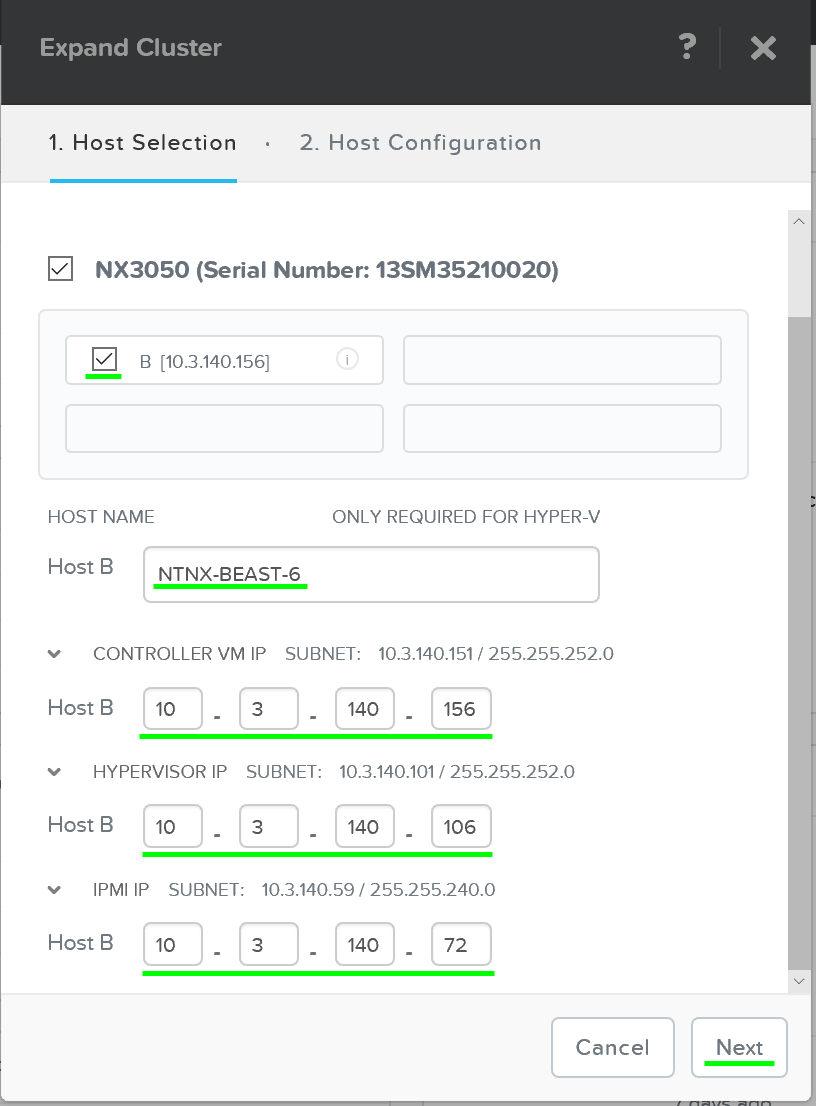

В меню масштабирования кластера можно отметить узлы для добавления и указать для них IP-адреса:

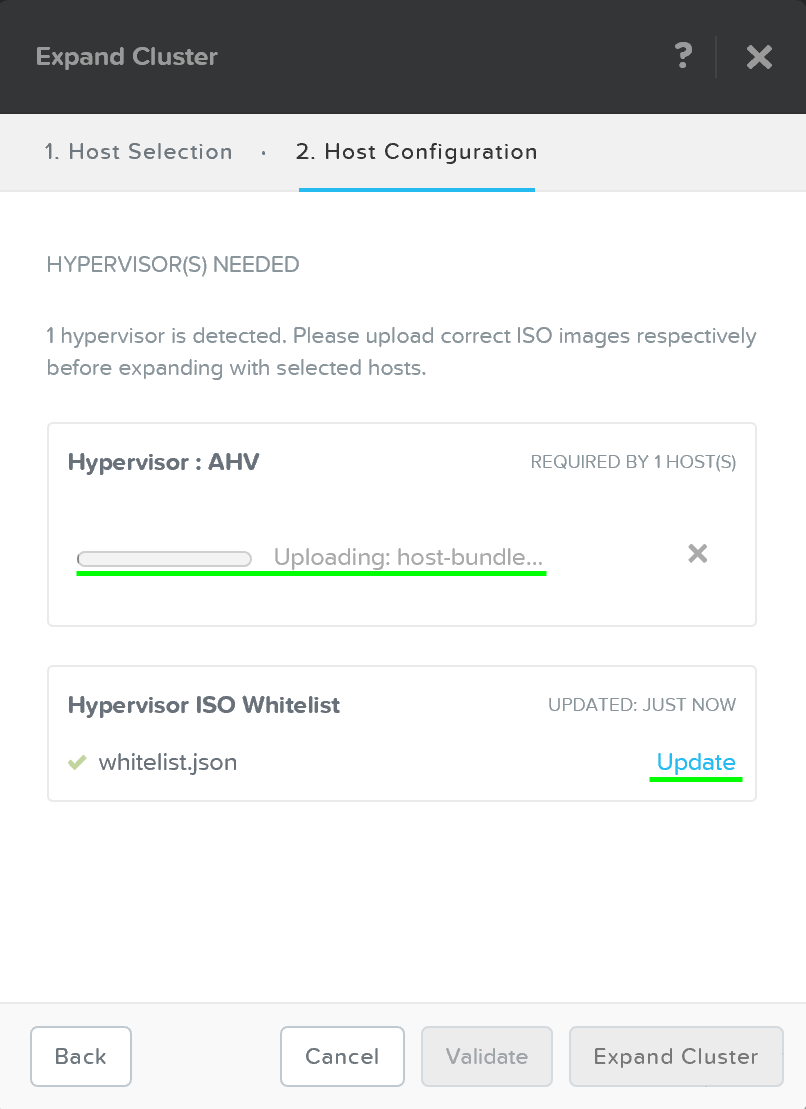

После того, как узел будет выбран, можно загрузить образ требуемого гипервизора на добавляемые узлы. Для узлов с гипервизором AHV, или при наличии образа в хранилище дополнительных действий не требуется.

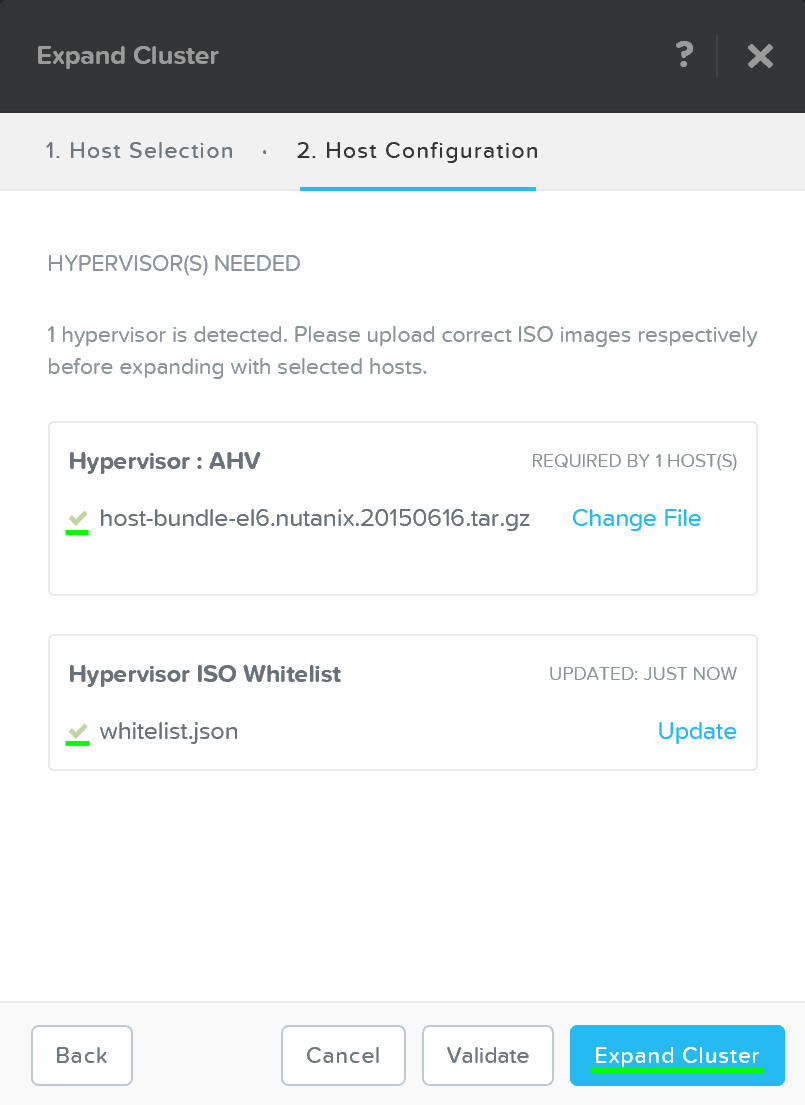

После завершения загрузки образа нажмите 'Expand Cluster' для начала процесса обновления узла и добавления его в кластер:

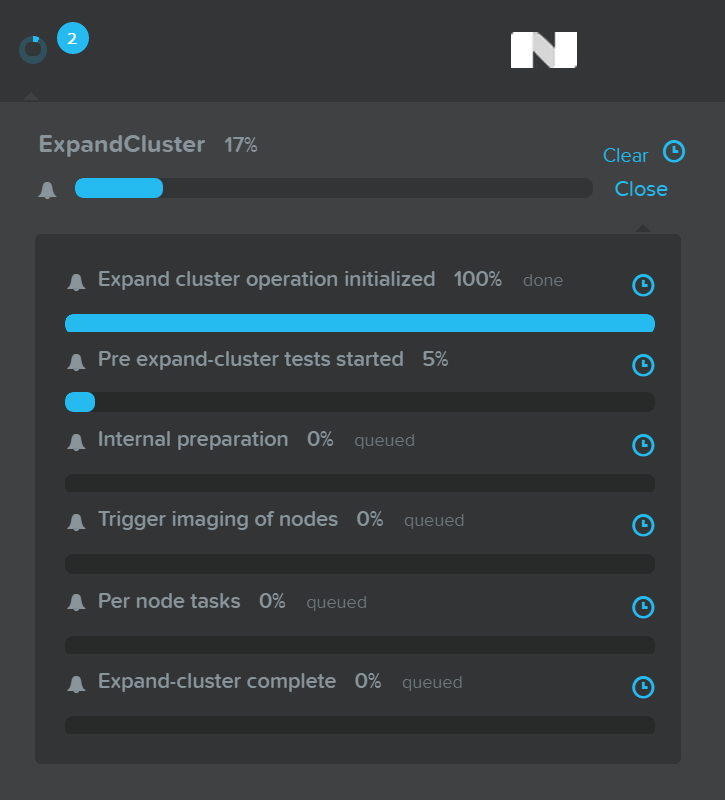

Задача будет сформирована и отправлена на исполнение, появится строка состояния для данной задачи:

Подробная информация о выполнении задачи доступна при нажатии на строке состояния:

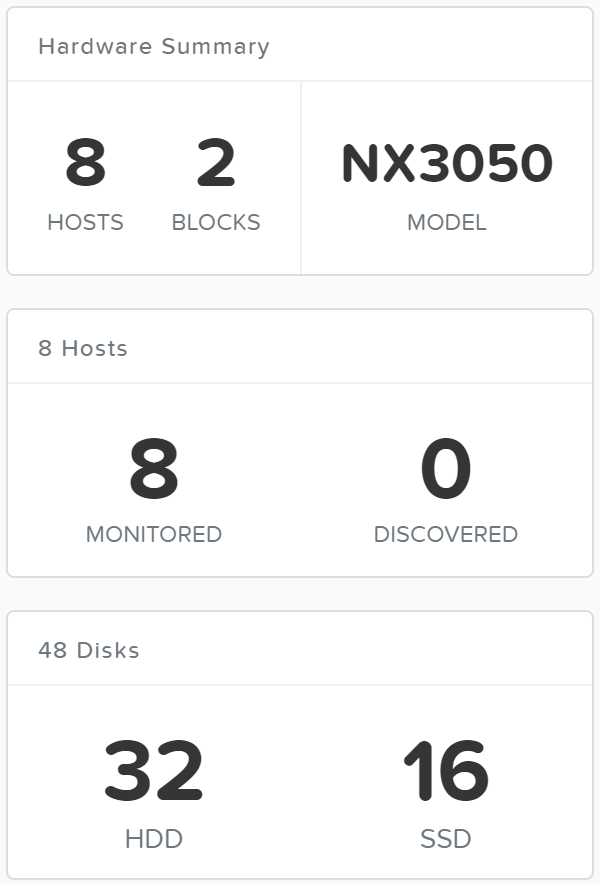

После завершения процесса масштабирования, информация о ресурсах кластера и количестве узлов будет обновлена:

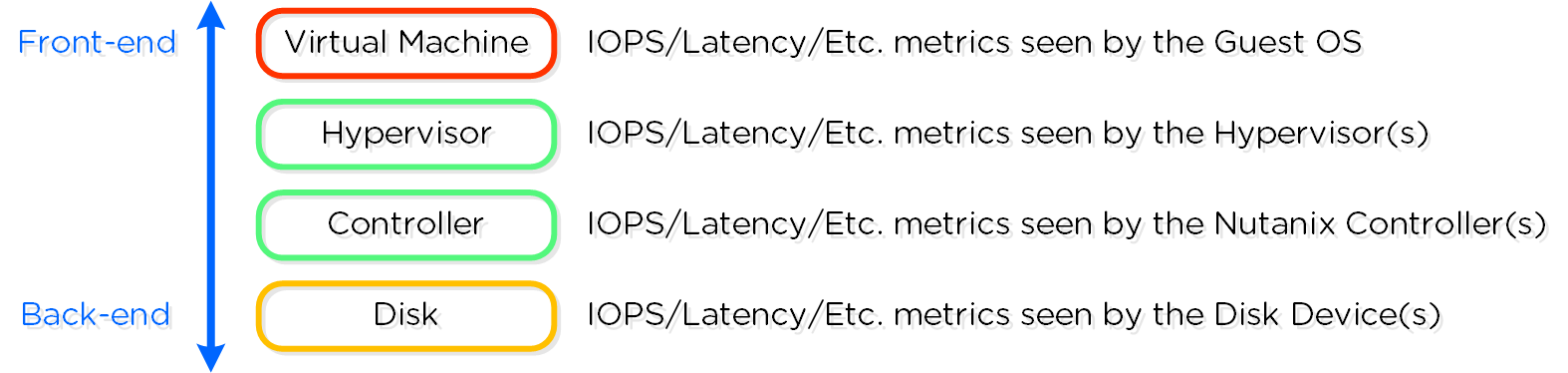

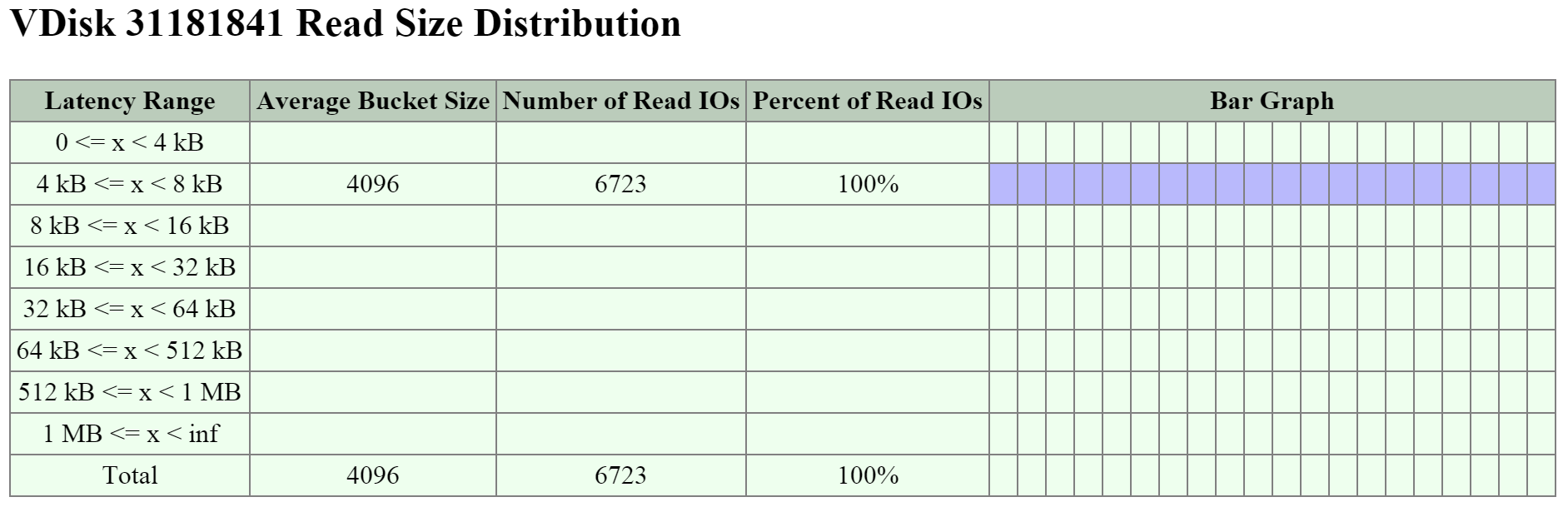

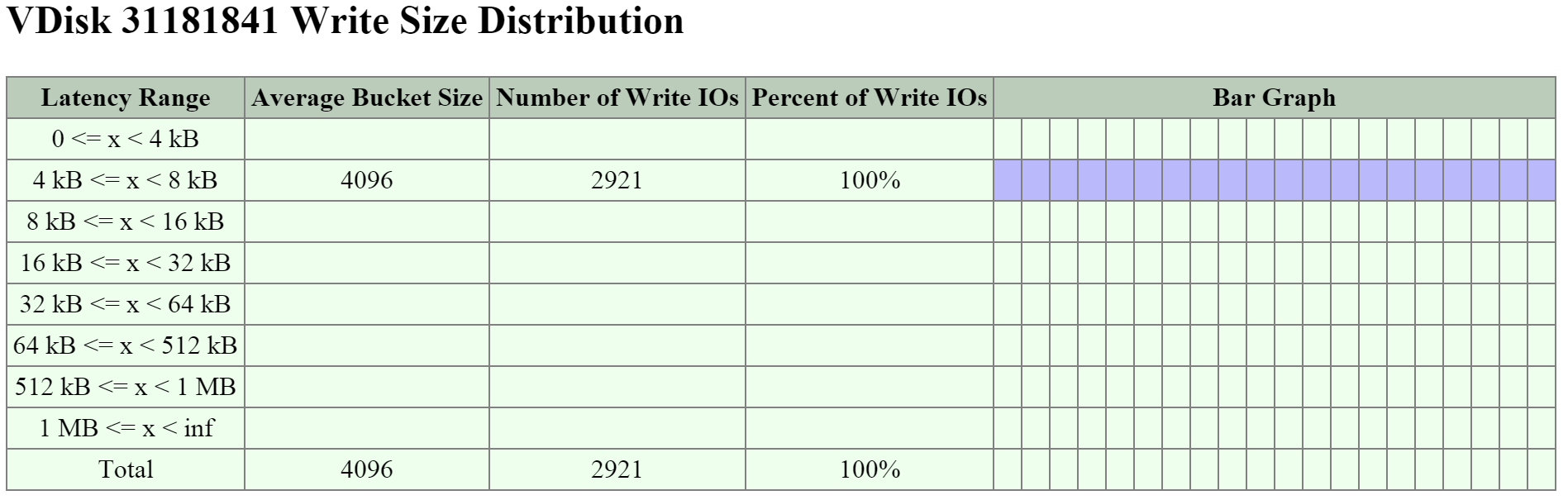

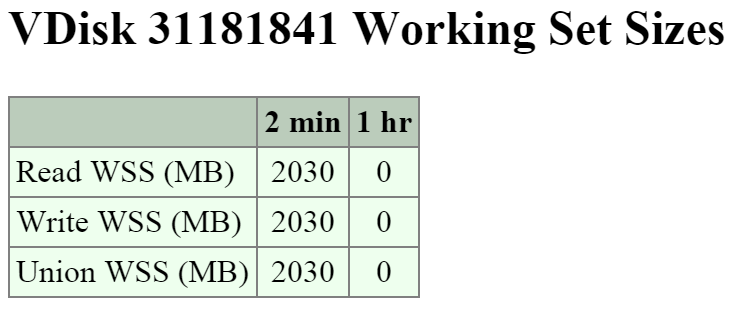

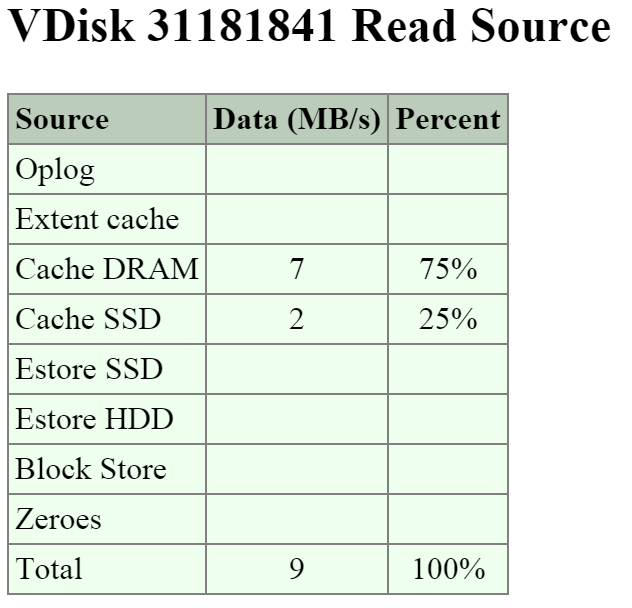

Метрики I/O

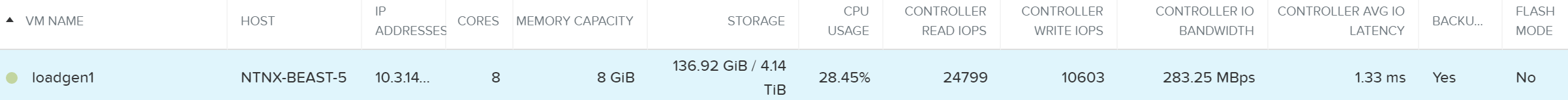

Поиск узких мест - одна из самых важных задач в процессе анализа работы платформы и устранения неисправностей. Для упрощения этой задачи в интерфейсе Nutanix есть специальный раздел 'I/O Metrics' на странице с ВМ.

Задержки зависят от множества переменных (глубины очереди, размера I/O, состояния системы, производительности сети и так далее). Эта страница предоставляет подробную информацию о размере I/O, задержках, источниках, и типах нагрузки.

Чтобы получить доступ к этим данным - перейдите на страницу 'VM' и выберите нужную ВМ из списка:

Вкладка с информацией по I/O находится чуть ниже:

На этой вкладке подробно расписаны все метрики I/O. Давайте разберем, что за данные тут доступны.

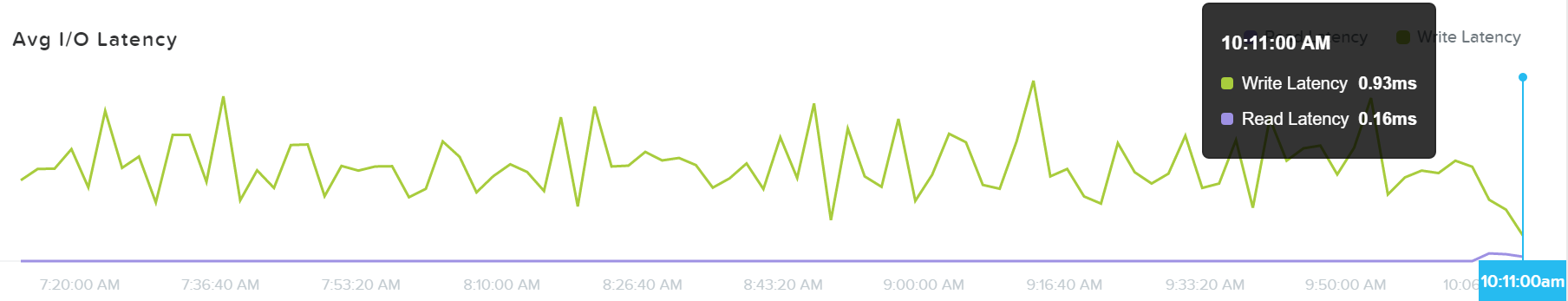

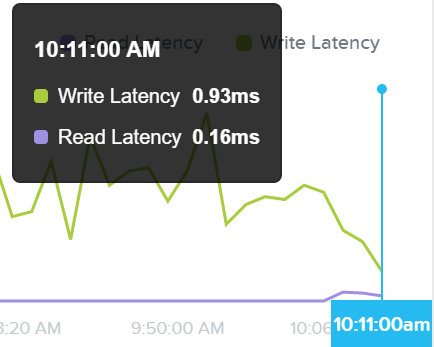

Первое представление 'Avg I/O Latency' демонстрирует среднюю задержку при операциях чтения/записи за последние три часа. По умолчанию вы видите самые свежие данные по данной метрике.

Тут можно выбрать интересующее время и получить информацию за конкретный период.

Это может быть полезно, если наблюдается внезапный всплеск. Можно найти этот всплеск на графике, и нажать на него для получения детальной информации.

Если с задержками все в порядке, то нет смысла копать дальше.

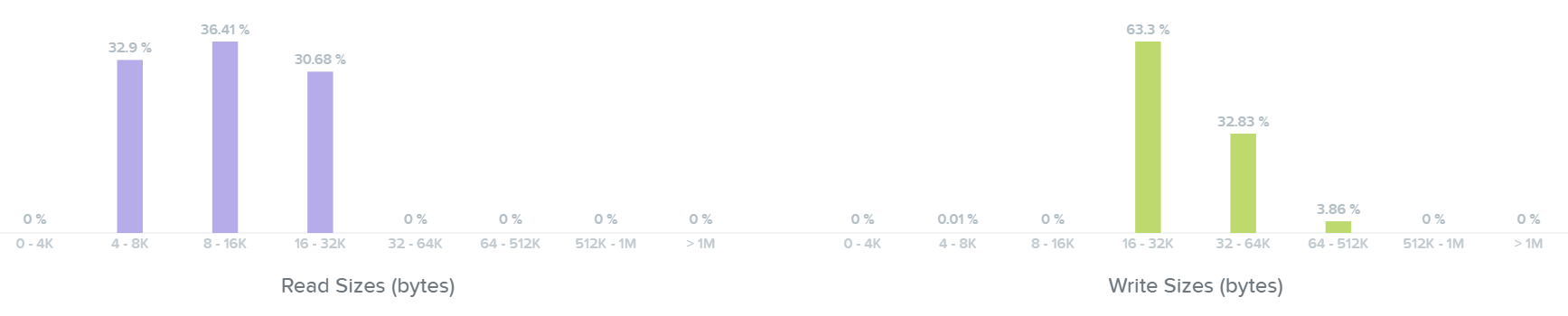

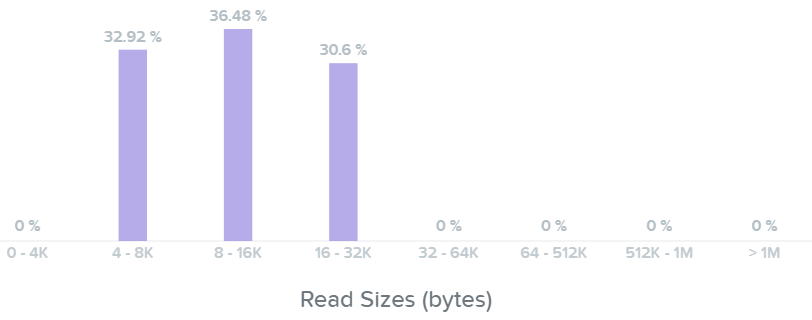

Следующая секция демонстрирует график размера блока I/O при операциях чтения и записи:

Тут мы видим, что наши операции чтения находятся в диапазоне между 4K и 32K:

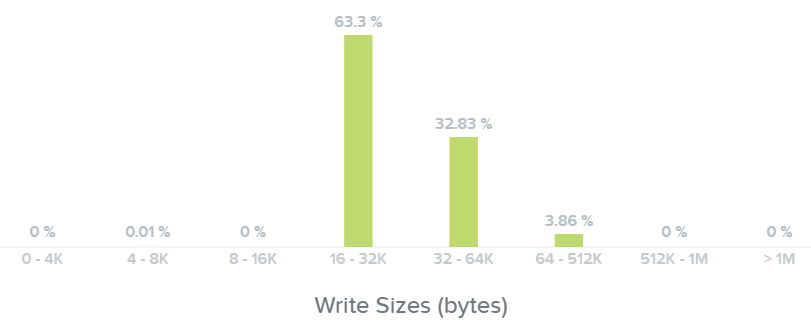

Далее - мы видим размер операций записи - они в диапазоне от 16K до 64K, а некоторые - 512K:

Примечание

Совет от создателей

Если видны пики по задержкам - в первую очередь стоит проверить размер операций I/O. Большие операции I/Os (64K up to 1MB) обычно генерируют более существенные задержки, чем небольшие операции (4K to 32K).

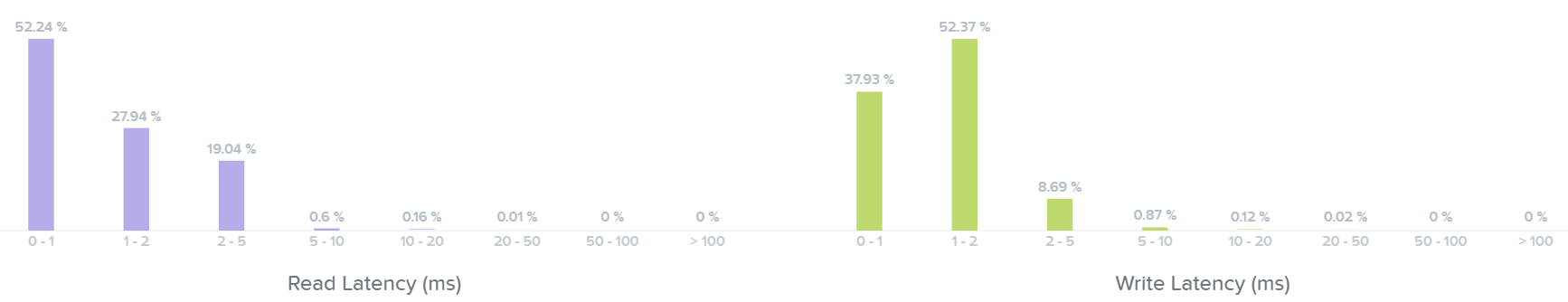

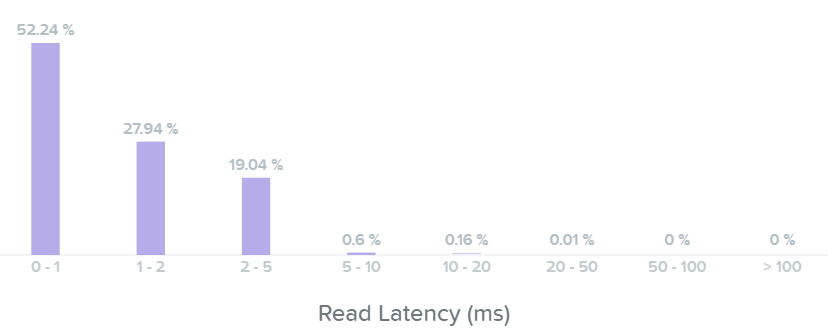

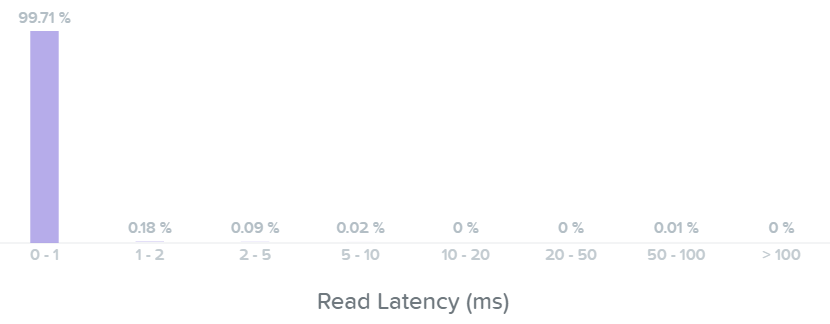

Следующая секция демонстрирует гистограмму для задержек при операциях чтения и записи:

На этом графике видно, что большая часть операций чтения имела задержку около 1ms, а некоторые из операций - 2-5ms.

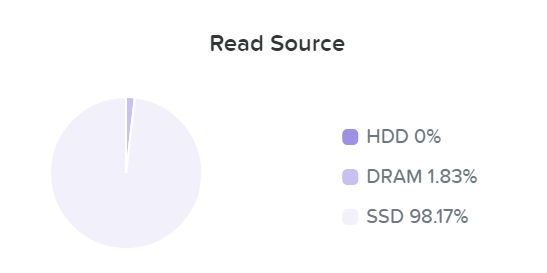

Если посмотреть в секцию 'Read Source', то будет видно, что большая часть операций чтения/записи выполняется с SSD:

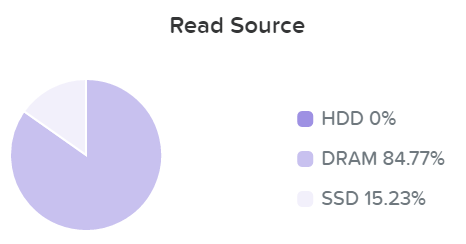

Как только данные считаны - они передаются в общий кэш (DRAM+SSD) в реальном времени (В секции 'Операции чтения/записи и кэширование' это раскрыто более подробно). Тут мы видим, что данные были загружены в кэш и теперь обслуживаются при помощи DRAM:

Тут видно, что по большей части операции чтения имеют задержки менее 1ms:

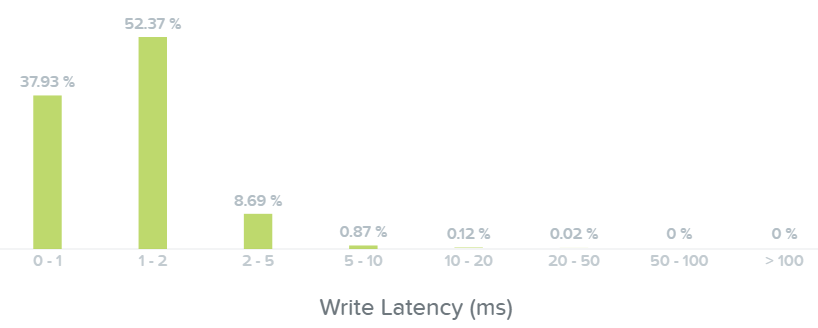

А здесь видно, что большая часть операций записи выполняется с задержками в районе <1-2ms:

Примечание

Совет от создателей

Если наблюдается всплеск задержек при чтении, и размер операции - небольшой, то стоит проверить - откуда выполняется чтение. Любая операция чтения с HDD будет иметь значительно большую задержку, чем из кэша DRAM; однако, как только требуемые данные попадут в DRAM вы увидите улучшение ситуации с задержками.

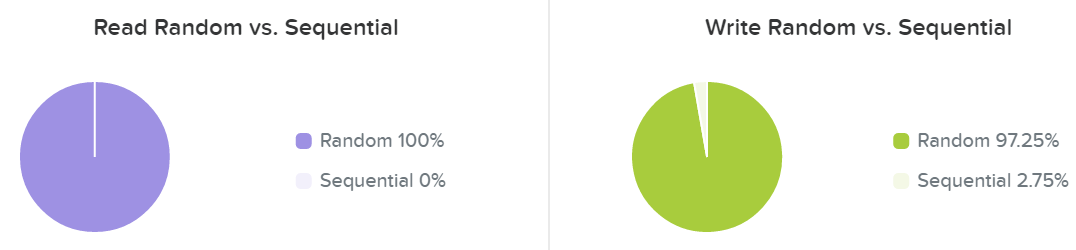

Последняя секция отображает типичные профили операций чтения и записи - случайные эти операции или последовательные:

Обычно профиль операций чтения/записи сильно зависят от типа приложения (например VDI генерирует случайные IO, а Hadoop - последовательные). Какие-то приложения будут смешивать оба типа. Например, базы данных будут генерировать случайные IO при запросах или добавлении данных и последовательные при операциях ETL.

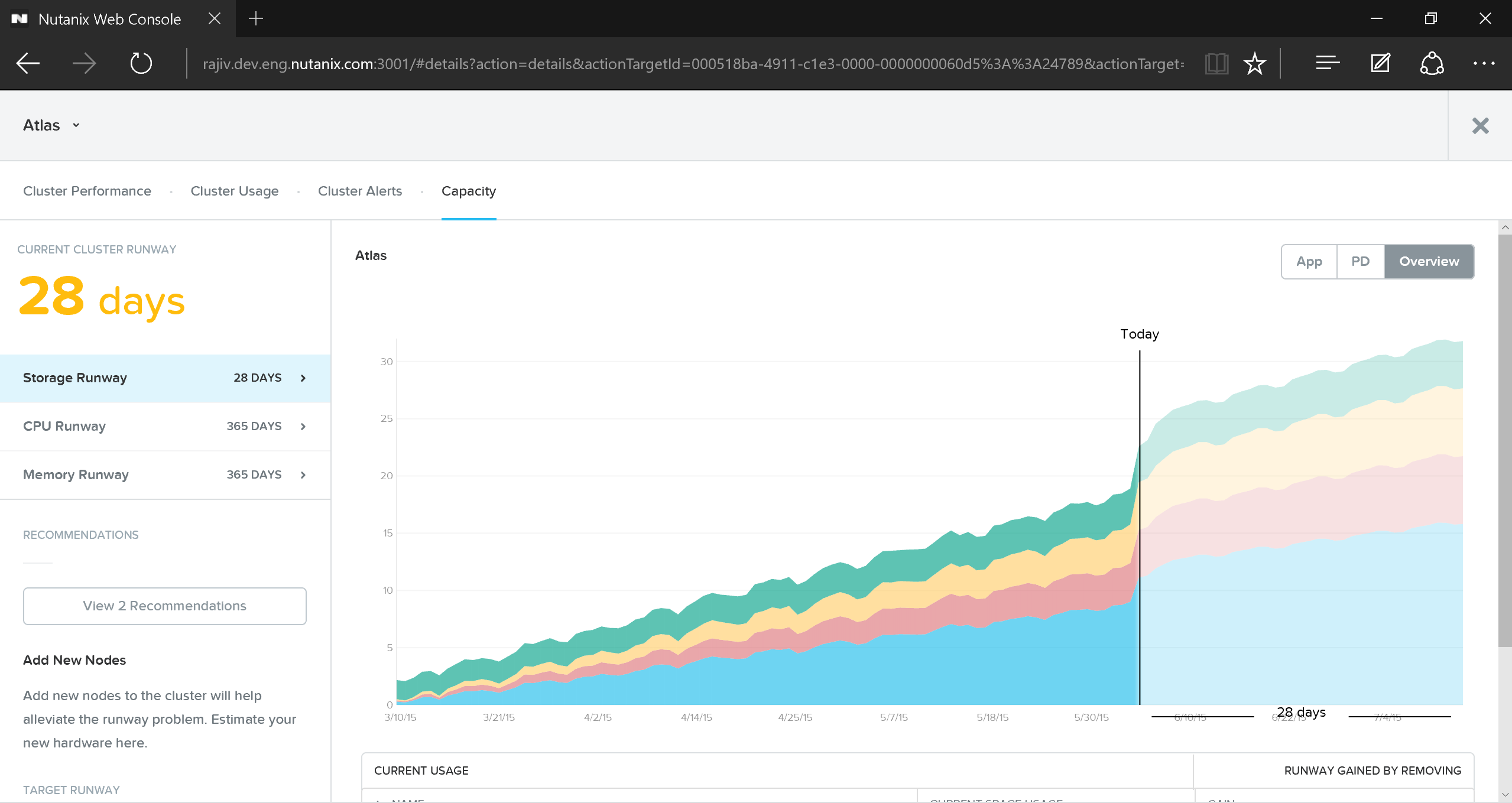

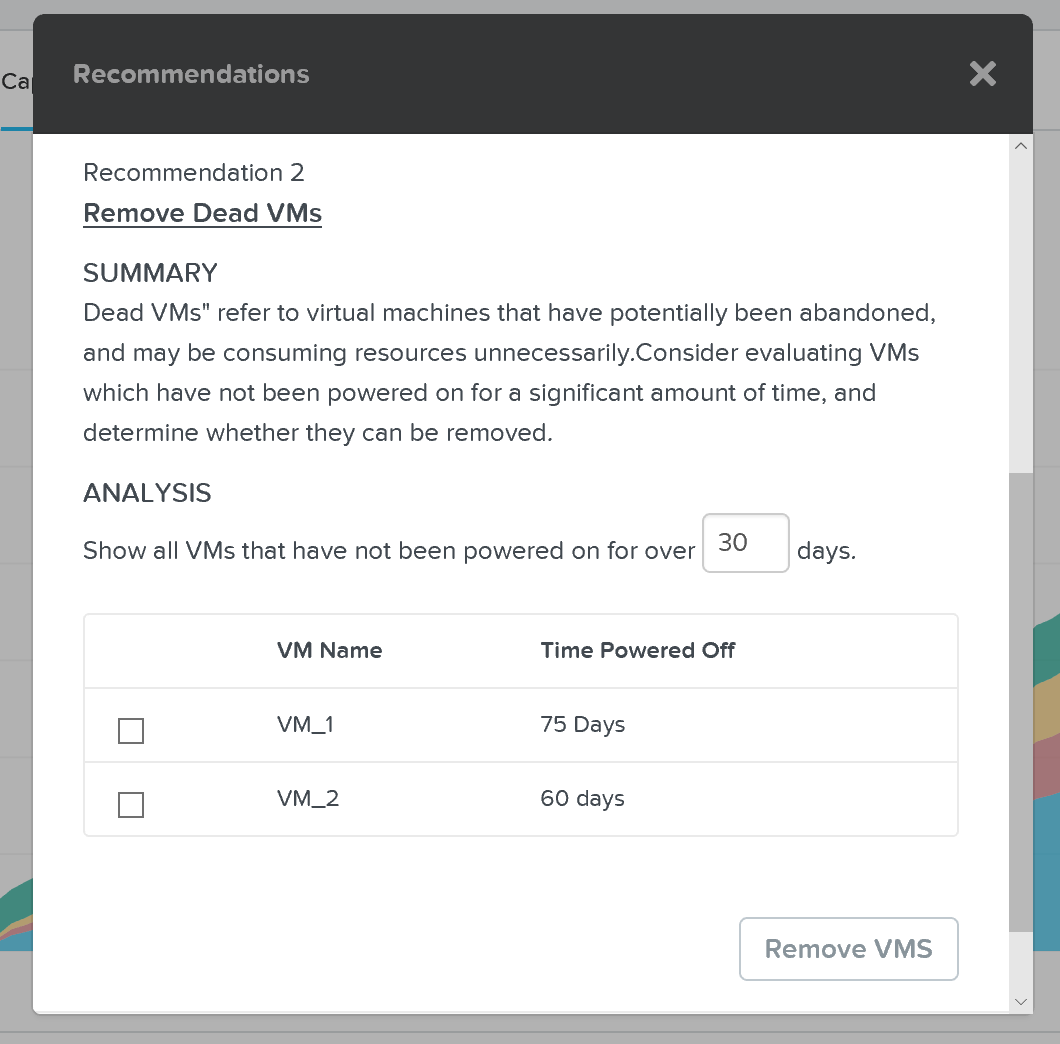

Планирование ресурсов

Для получения информации по планированию ресурсов нужно нажать на интересующий кластер в секции 'cluster runway' интерфейса Prism Central:

Тут содержится подробная информация о тренде использования ресурсов. Здесь можно получить информацию о главных потребителях ресурсов, путях высвобождения ресурсов и рекомендации по типу узлов, для дальнейшего масштабирования кластера.

HTML5 интерфейс Prism - основной инструмент для простого управления кластером. Но не менее важен API который предоставляет прекрасную возможность для автоматизации. Все функции доступные через интерфейс Prism так же могут быть вызваны через REST APIs, что обеспечивает возможность интеграции с различном сторонним ПО. Это позволяет клиентам и партнерам компании интегрировать ПО от сторонних разработчиков или даже создавать собственный пользовательский интерфейс.

В следующем разделе описаны все интерфейсы Платформы и приведены примеры их использования.

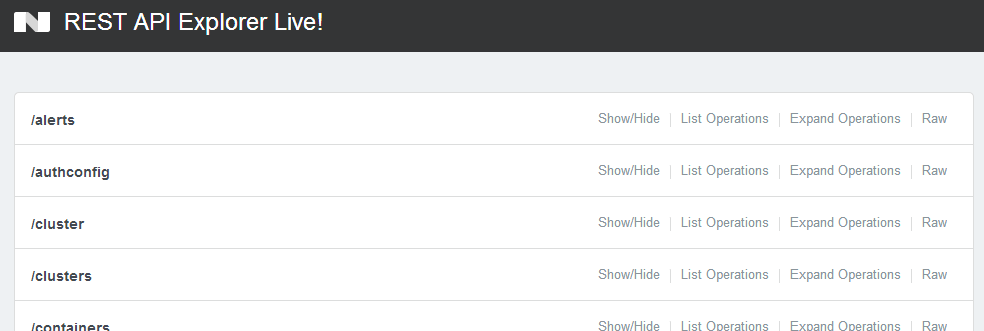

API и интерфейсы

Такие интерфейсы являются основой любой программно-определяемой среды. Nutanix предоставляет широкий набор таких интерфейсов для простого взаимодействия с платформой:

- REST API

- CLI - ACLI & NCLI

- Интерфейсы автоматизации

Примечание

deleveloper.nutanix.com

Обязательно посетите раздел нашего сайта для получения подробной информации по этой теме: developer.nutanix.com!

REST API позволяет получить доступ ко всем функциям Prism UI, так любое средство автоматизации и оркестрации может с легкостью управлять Платформой. Вы можете использовать любое удобное ПО - Saltstack, Puppet, vRealize Operations, System Center Orchestrator, Ansible для автоматизации и создания собственных сценариев работы с Nutaix Кроме того, любые сторонние разработчики могут создавать свои пользовательские интерфейсы для Платформы и отправлять запросы через REST.

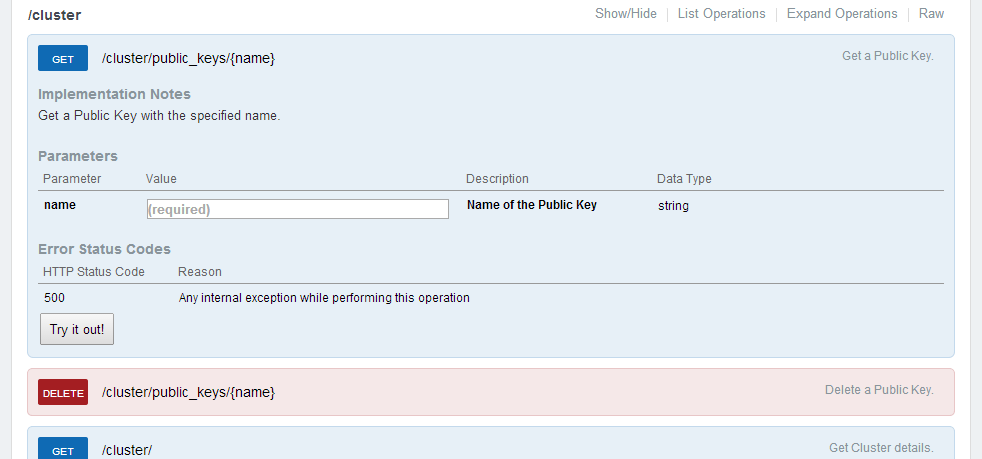

Ниже показан инструмент удобной работы с API - Nutanix REST API Explorer, который позволяет отправлять запросы и получать примеры ответов:

По каждой операции можно получить подробнейшую информацию и примеры вызовов REST:

Примечание

Схема аутентификации API

Начиная с версии 4.5.x используется стандартная аутентификация через HTTPS для проверки подлинности запросов по HTTP.

ACLI

The Acropolis CLI (ACLI) это командный интерфейс к платформе, являющийся неотъемлемой его частью. Этот компонент стал доступным, начиная с версии 4.1.2

Примечание: Все эти действия могут быть выполнены так же через веб-интерфейс и REST API. Я использую эти команды для автоматизации рутинных задач с помощью скриптов.

Вход в ACLI

Описание: Вход в оболочку ACLI (с любой CVM)

Acli

OR

Описание: Вход в оболочку ACLI через консоль Linux

ACLI <Command>

Вывод ACLI в формате json

Описание: Просмотр узлов в кластере

Acli –o json

Список узлов

Описание: Просмотр узлов в кластере

host.list

Создание сети

Описание: Создание сети на базе VLAN

net.create <TYPE>.<ID>[.<VSWITCH>] ip_config=<A.B.C.D>/<NN>

Пример: net.create vlan.133 ip_config=10.1.1.1/24

Список сетей

Описание: Список сетей

net.list

Создание пула DHCP

Описание: Создание пула DHCP

net.add_dhcp_pool <NET NAME> start=<START IP A.B.C.D> end=<END IP W.X.Y.Z>

Примечание: Адрес .254 всегда резервируется под встроенный сервер DHCP, если он не был указан пользователем при создании сети

Пример: net.add_dhcp_pool vlan.100 start=10.1.1.100 end=10.1.1.200

Детальное описание сети

Описание: Подробный список ВМ в сети, их имен / UUID, MAC адресов и IP

net.list_vms <NET NAME>

Пример: net.list_vms vlan.133

Настройка сервиса DHCP DNS для сети

Описание: Настройка DHCP DNS

net.update_dhcp_dns <NET NAME> servers=<COMMA SEPARATED DNS IPs> domains=<COMMA SEPARATED DOMAINS>

Пример: net.set_dhcp_dns vlan.100 servers=10.1.1.1,10.1.1.2 domains=splab.com

Создание виртуальной машины

Описание: Создание ВМ

vm.create <COMMA SEPARATED VM NAMES> memory=<NUM MEM MB> num_vcpus=<NUM VCPU> num_cores_per_vcpu=<NUM CORES> ha_priority=<PRIORITY INT>

Пример: vm.create testVM memory=2G num_vcpus=2

Массовое создание ВМ

Описание: Массовое создание ВМ

vm.create <CLONE PREFIX>[<STARTING INT>..<END INT>] memory=<NUM MEM MB> num_vcpus=<NUM VCPU> num_cores_per_vcpu=<NUM CORES> ha_priority=<PRIORITY INT>

Пример: vm.create testVM[000..999] memory=2G num_vcpus=2

Клонирование существующей ВМ

Описание: Create clone of existing VM

vm.clone <CLONE NAME(S)> clone_from_vm=<SOURCE VM NAME>

Пример: vm.clone testClone clone_from_vm=MYBASEVM

Создание нескольких клонов из существующей ВМ

Описание: Массовое создание клонов из существующей ВМ

vm.clone <CLONE PREFIX>[<STARTING INT>..<END INT>] clone_from_vm=<SOURCE VM NAME>

Пример: vm.clone testClone[001..999] clone_from_vm=MYBASEVM

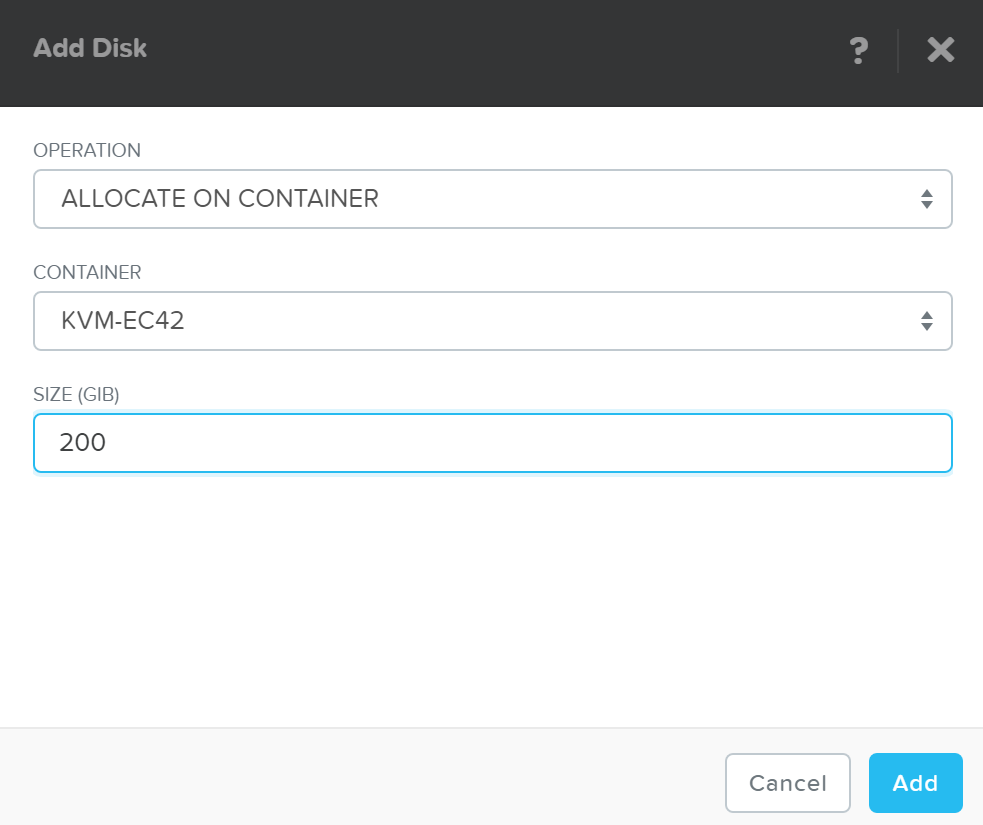

Создание диска и подключение его к ВМ

# Описание: Создание диска ВМ

vm.disk_create <VM NAME> create_size=<Size and qualifier, e.g. 500G> container=<CONTAINER NAME>

Пример: vm.disk_create testVM create_size=500G container=default

Подключение сетевого интерфейса к ВМ

Описание: Создание и подключение сетевого интерфейса к ВМ

vm.nic_create <VM NAME> network=<NETWORK NAME> model=<MODEL>

Пример: vm.nic_create testVM network=vlan.100

Настройка загрузочного диска ВМ

Описание: Настройка загрузочного диска ВМ

Настройка загрузочного диска, через указание специфического id

vm.update_boot_device <VM NAME> disk_addr=<DISK BUS>

Пример: vm.update_boot_device testVM disk_addr=scsi.0

Настройка CDROM в качестве загрузочного диска

Установка загрузки с CDrom

vm.update_boot_device <VM NAME> disk_addr=<CDROM BUS>

Пример: vm.update_boot_device testVM disk_addr=ide.0

Монтирование ISO

Описание: Монтирование ISO

Порядок действий:

1. Загрузить ISOs в контейнер

2. Создать белый список IP-адресов клиента

3. Загрузить ISOs в общую папку

Создание CDrom с ISO

vm.disk_create <VM NAME> clone_nfs_file=<PATH TO ISO> cdrom=true

Пример: vm.disk_create testVM clone_nfs_file=/default/ISOs/myfile.iso cdrom=true

Если CDrom уже создан - просто смонтируйте его

vm.disk_update <VM NAME> <CDROM BUS> clone_nfs_file<PATH TO ISO>

Пример: vm.disk_update atestVM1 ide.0 clone_nfs_file=/default/ISOs/myfile.iso

Отключение ISO от CDrom

Описание: Отключение образа ISO от CDrom

vm.disk_update <VM NAME> <CDROM BUS> empty=true

Включение ВМ

Описание:Включение ВМ

vm.on <VM NAME(S)>

Пример: vm.on testVM

Включение всех ВМ

Пример: vm.on *

Включение всех ВМ по префиксу

Пример: vm.on testVM*

Включение списка ВМ

Пример: vm.on testVM[0-9][0-9]

NCLI

Примечание: Все эти действия могут быть выполнены через веб-интерфейс и REST API. Я использую эти команды для написания автоматизации рутинных задач с помощью скриптов.

Добавление подсети в белый список NFS

Описание: Добавление подсети в белый список NFS

ncli cluster add-to-nfs-whitelist ip-subnet-masks=10.2.0.0/255.255.0.0

Получение информации о версии ПО Nutanix

Описание: Получение информации о версии ПО Nutanix

ncli cluster version

Отображение скрытых опций NCLI

Описание: Отображение скрытых опций и команд NCLI

ncli helpsys listall hidden=true [detailed=false|true]

Список пулов хранения

Описание: Список всех существующих пулов хранения

ncli sp ls

Список контейнеров

Описание: Список всех существующих контейнеров

ncli ctr ls

Создание контейнеров

Описание: Создание нового контейнера

ncli ctr create name=<NAME> sp-name=<SP NAME>

Список ВМ

Описание: Список всех существующих ВМ

ncli vm ls

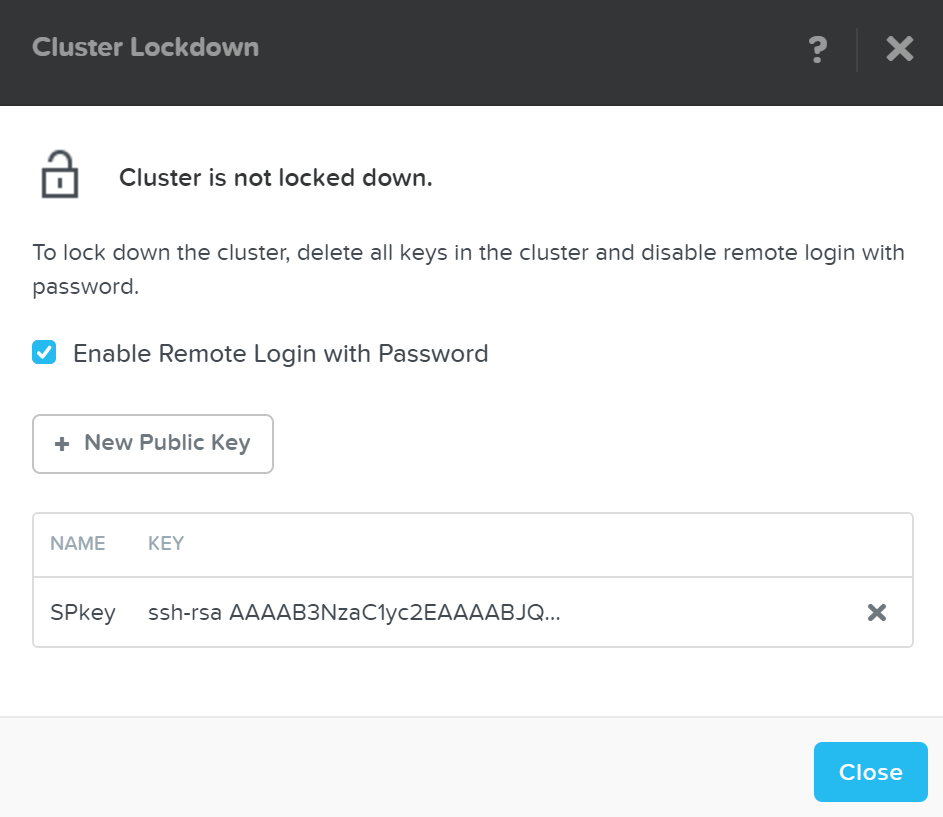

Список публичных ключей

Описание: Список всех существующих публичных ключей

ncli cluster list-public-keys

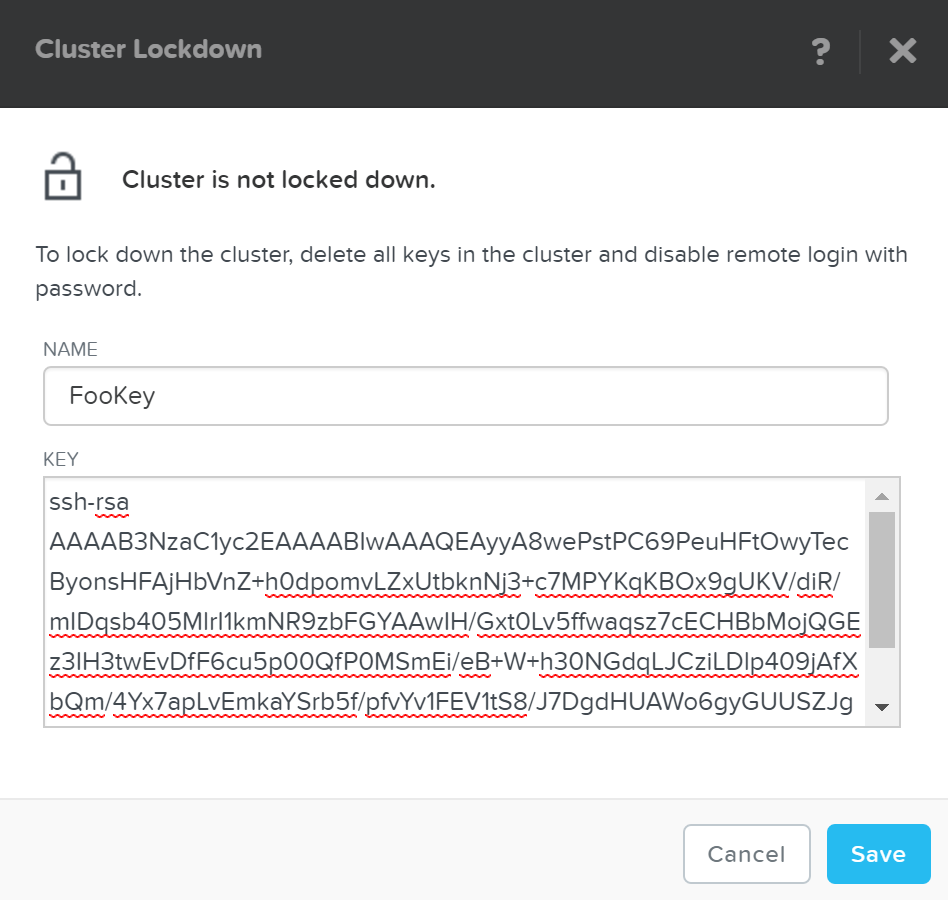

Добавление публичных ключей

Описание: Добавление публичных ключей для доступа к кластеру

Копирование публичных ключей на CVM

Добавление публичных ключей

ncli cluster add-public-key name=myPK file-path=~/mykey.pub

Удаление публичных ключей

Описание: Удаление публичных ключей

ncli cluster remove-public-keys name=myPK

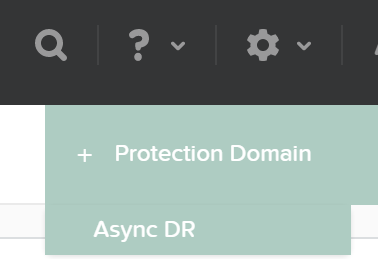

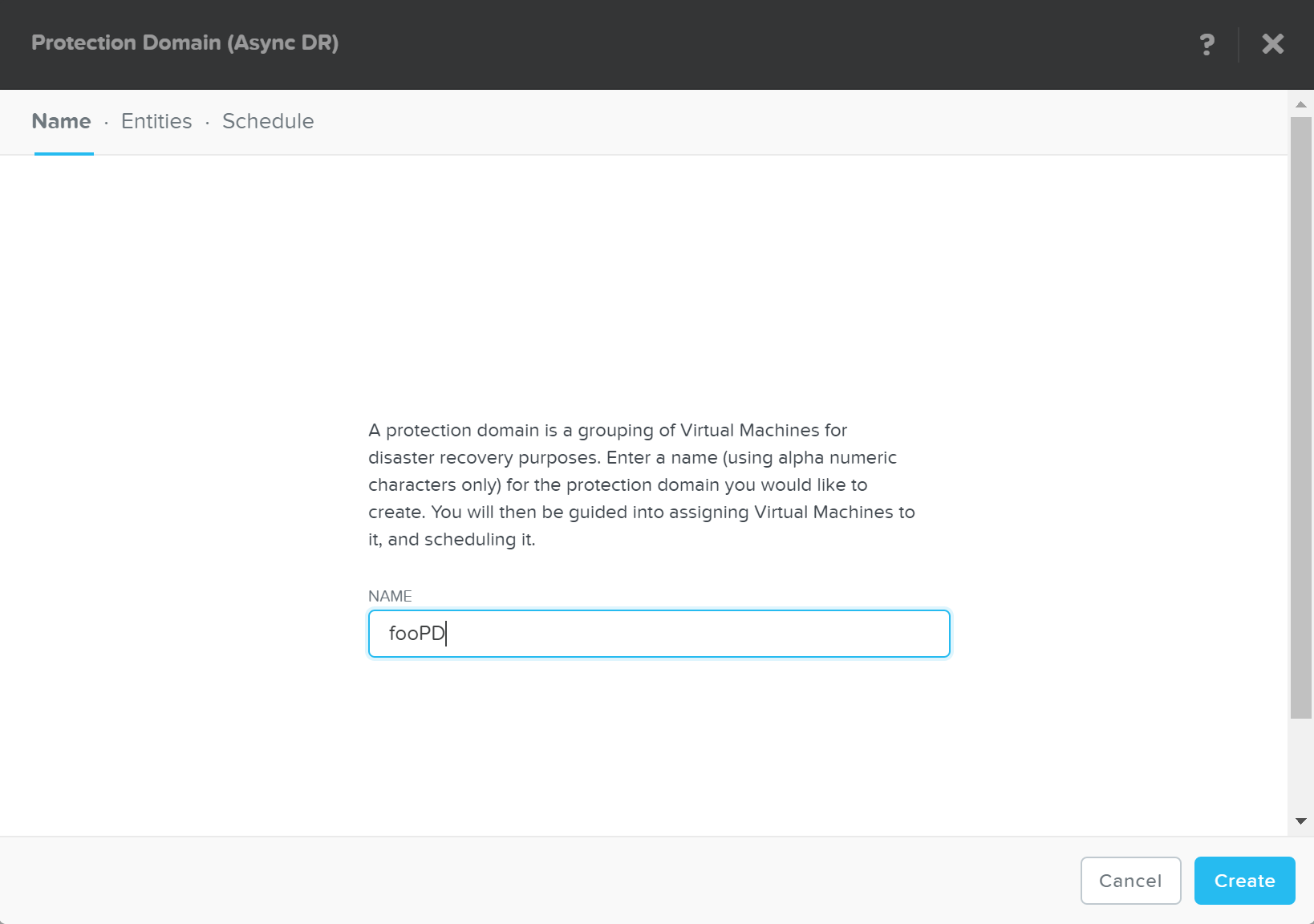

Создание домена защиты

Описание: Создание домена защиты

ncli pd create name=<NAME>

Создание кластера назначения

Описание: Создание кластера назначения для выполнения репликации

ncli remote-site create name=<NAME> address-list=<Remote Cluster IP>

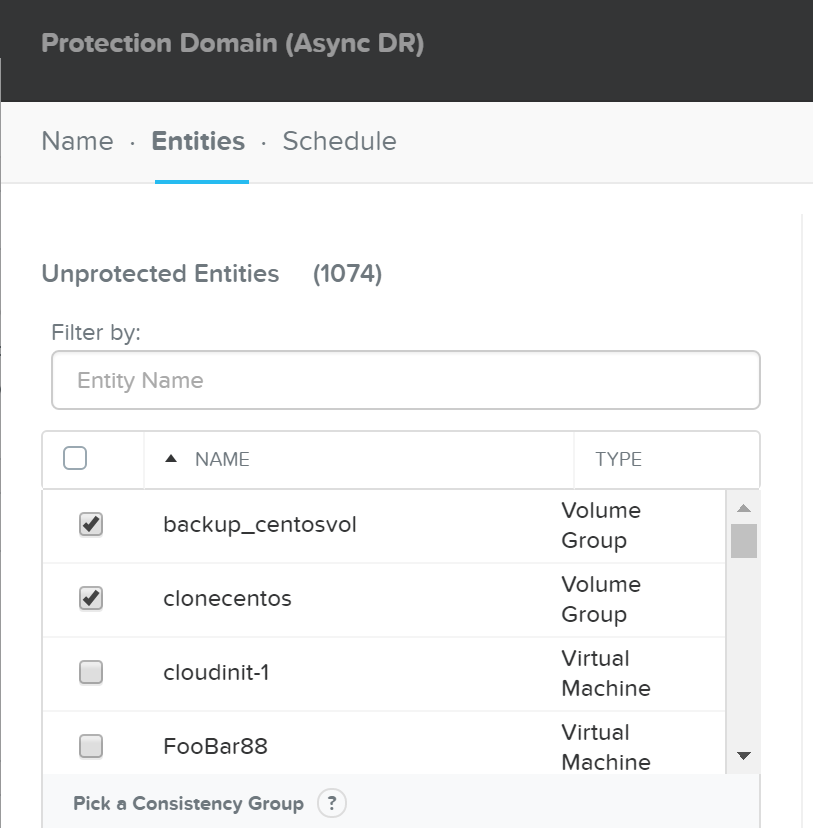

Создание домена защиты для всех ВМ в рамках контейнера

Описание: Защита всех ВМ в контейнере

ncli pd protect name=<PD NAME> ctr-id=<Container ID> cg-name=<NAME>

Создание домена защиты для конкретных ВМ

Описание: Защита конкретных ВМ

ncli pd protect name=<PD NAME> vm-names=<VM Name(s)> cg-name=<NAME>

Создание домена защиты для объектов хранилища (они же vDisk)

Описание: Защита конкретных объектов хранилища

ncli pd protect name=<PD NAME> files=<File Name(s)> cg-name=<NAME>

Создание снимка домена защиты

Описание: Разовое создание снимка домена защиты

ncli pd add-one-time-snapshot name=<PD NAME> retention-time=<seconds>

Создание расписания для создания снимков и репликации на кластер назначения

Описание: Создание расписания для создания снимков и репликации на кластер(ы) назначения

ncli pd set-schedule name=<PD NAME> interval=<seconds> retention-policy=<POLICY> remote-sites=<REMOTE SITE NAME>

Статус задач репликации

Описание: Статус задач репликации

ncli pd list-replication-status

Перенос домена защиты на другой кластер

Описание: Перенос домена защиты на другой кластер

ncli pd migrate name=<PD NAME> remote-site=<REMOTE SITE NAME>

Активация домена защиты

Описание: Активация домена защиты на кластере назначения

ncli pd activate name=<PD NAME>

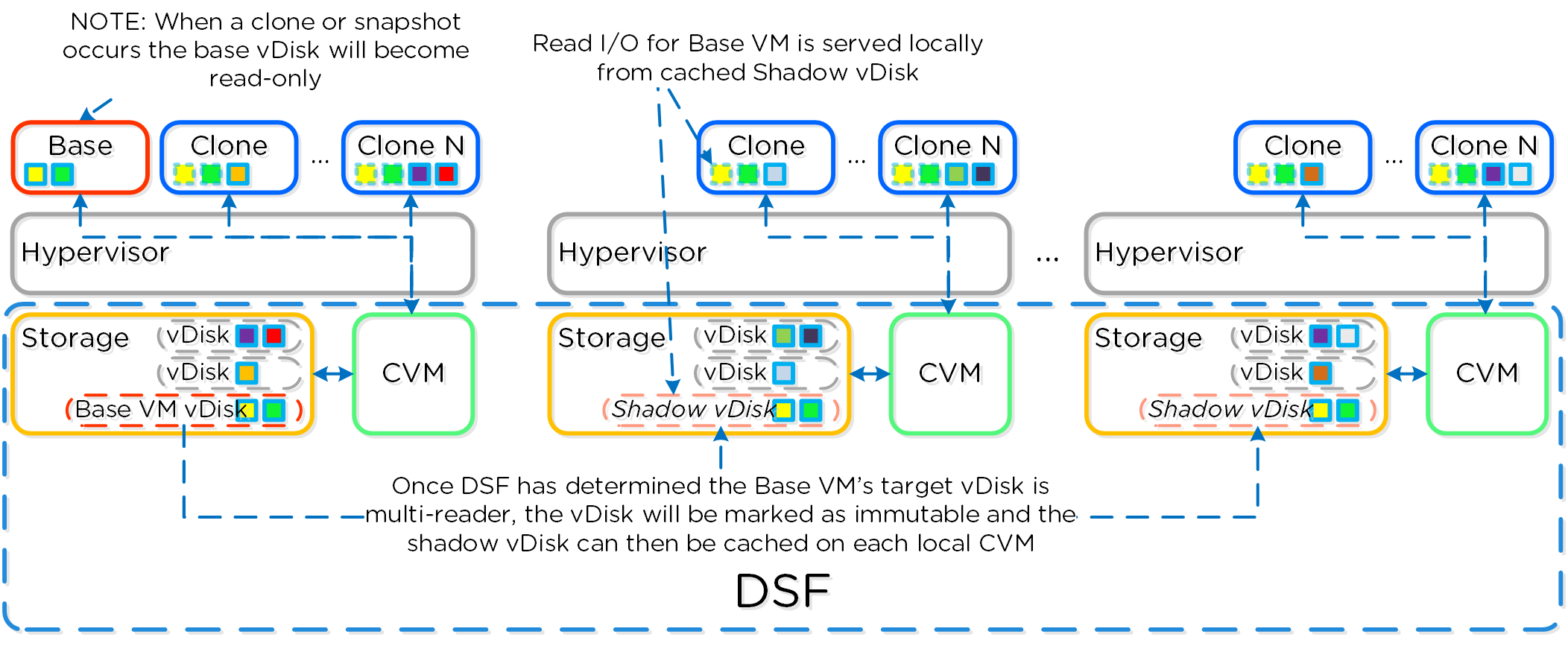

Включение теневых клонов для DSF

Описание: Включение функции создания теневых клонов DSF

ncli cluster edit-params enable-shadow-clones=true

Активация функции дедупликации для vDisk

Описание: Включение функции создания снимков и дедупдликации для конкретного vDisk

ncli vdisk edit name=<VDISK NAME> fingerprint-on-write=<true/false> on-disk-dedup=<true/false>

Проверка состояния отказоуствойчивости кластера

# Статус узлов

ncli cluster get-domain-fault-tolerance-status type=node

# Статус блоков

ncli cluster get-domain-fault-tolerance-status type=rackable_unit

Командлеты для PowerShell

Ниже мы рассмотрим командлеты для PowerShell от Nutanix и то как их использовать, а так же остановимся на некоторых основных моментах касаемо Windows PowerShell.

Основы

Windows PowerShell это мощная командная оболочка (отсюда и название ;P) а так же встроенный язык для автоматизации на основе фреймворка .NET Это очень простой в использовании язык, созданный быть интерактивным и интуитивным. Ключевые элементы конструкций PowerShell:

CMDlets (командлеты)

CMDlets это команды или классы .NET которые выполняют те или иные операции. Они следуют методологии получения и отправки запросов и использую структуру <Глагол>-<Существительное>. Например: Get-Process, Set-Partition, и так далее.

Конвейеры

Конвейеры важная конструкция в PowerShell (так же как и в Linux) и может очень упростить некоторые конструкции. С конвейером вы можете передавать результат одной секции конвейера в следующую, в качестве входных параметров. Конвейер может иметь такую длину, как вам необходимо. Простым примером конвейера может быть получение списка процессов, поиск конкретных по фильтру и сортировка результата:

Get-Service | where {$_.Status -eq "Running"} | Sort-Object Name

Кроме того, конвейер может быть использован для каждого значения в массиве, например:

# Для каждого значения в массиве

$myArray | %{

# Выполнить какие-то действия

}

Ключевые типы объектов

Ниже рассмотрим несколько ключевых объектов PowerShell. Тип объекта можно получить через метод .getType(), например: $someVariable.getType() вернет тип для объекта.

Переменные

$myVariable = "foo"

Примечание: Можно поместить в переменную конвейер:

$myVar2 = (Get-Process | where {$_.Status -eq "Running})

В этом примере переменная получит результат выполнения команды в качестве значения.

Массив

$myArray = @("Value","Value")

Примечание: Можно создать массив из массивов, хэш-таблиц или пользовательских типов

Хэш-таблица

$myHash = @{"Key" = "Value";"Key" = "Value"}

Полезные команды

Получение справки по конкретному командлету (так же как man в Linux)

Get-Help <имя командлета>

Пример: Get-Help Get-Process

Список свойств и методов команды или объекта

<Вырожение или объект> | Get-Member

Пример: $someObject | Get-Member

Основные командлеты Nutanix и их использование

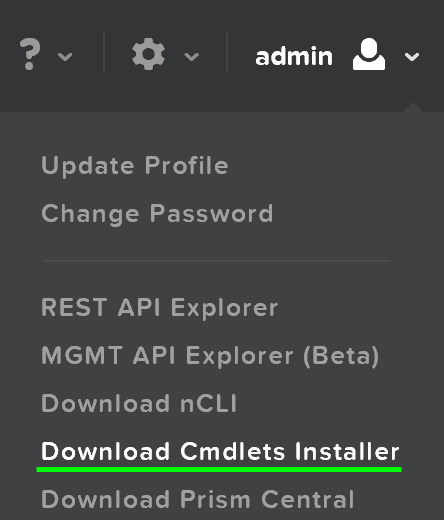

Загрузить установщик командлетов Nutanix можно из Prism UI (после версии 4.0.1):

Загрузка оснастки Nutanix

Проверьте загружена ли оснастка Nutanix, если нет - загрузите

if ( (Get-PSSnapin -Name NutanixCmdletsPSSnapin -ErrorAction SilentlyContinue) -eq $null )

{

Add-PsSnapin NutanixCmdletsPSSnapin

}

Список командлетов Nutanix

Get-Command | Where-Object{$_.PSSnapin.Name -eq "NutanixCmdletsPSSnapin"}

Подключение к кластеру Acropolis

Connect-NutanixCluster -Server $server -UserName "myuser" -Password (Read-Host "Password: " -AsSecureString) -AcceptInvalidSSLCerts

Получение списка ВМ по маске

Объявление переменной

$searchString = "myVM"

$vms = Get-NTNXVM | where {$_.vmName -match $searchString}

Выполнение

Get-NTNXVM | where {$_.vmName -match "myString"}

Выполнение и форматирование

Get-NTNXVM | where {$_.vmName -match "myString"} | ft

Получение объектов хранилища

Объявление переменной

$vdisks = Get-NTNXVDisk

Выполнение

Get-NTNXVDisk

Выполнение и форматирование

Get-NTNXVDisk | ft

Получение списка контейнеров Nutanix

Объявление переменной

$containers = Get-NTNXContainer

Выполнение

Get-NTNXContainer

Выполнение и форматирование

Get-NTNXContainer | ft

Получение списка доменов защиты

Объявление переменной

$pds = Get-NTNXProtectionDomain

Выполнение

Get-NTNXProtectionDomain

Выполнение и форматирование

Get-NTNXProtectionDomain | ft

Получение списка групп консистентности

Объявление переменной

$cgs = Get-NTNXProtectionDomainConsistencyGroup

Выполнение

Get-NTNXProtectionDomainConsistencyGroup

Выполнение и форматирование

Get-NTNXProtectionDomainConsistencyGroup | ft

Ресурсы и скрипты:

- Nutanix Github - https://github.com/nutanix/Automation

- Manually Fingerprint vDisks - http://bit.ly/1syOqch

- vDisk Report - http://bit.ly/1r34MIT

- Отчет о доменах защиты - http://bit.ly/1r34MIT

- Восстановление доменов защиты по очереди - http://bit.ly/1pyolrb

Примечание: некоторые скрипты не поддерживаются и могут быть использованы только в качестве примера.

Больше скриптов доступно на официальном гите Nutanix https://github.com/nutanix

Интеграция

OpenStack

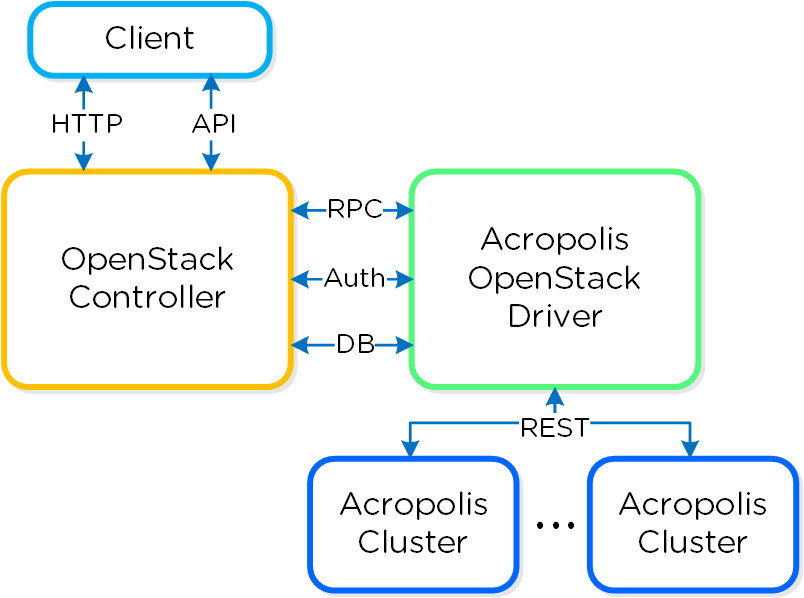

OpenStack это открытая платформа для реализации и управления облаками. Он состоит из пользовательского интерфейса, API и инфраструктурных сервисов (сервис вычисления, хранения, и так далее).

Решение Nutanix OpenStack состоит из нескольких основных компонент:

- OpenStack Controller (OSC)

- Существующая или вновь созданная ВМ, на которой размещаются сервисы OpenStack - UI, API и служебные сервисы. Тут обрабатываются все вызовы к API OpenStack. Если в качестве платформы используется Acropolis тут же может размещаться и драйвер Acropolis OpenStack

- Acropolis OpenStack Driver

- Отвечает за обработку вызовов OpenStack RPCs от контроллера OpenStack и трансляции их в стандартный API Acropolis. Может быть развернут в рамках OCS, OVM или на отдельной ВМ.

- Служебная ВМ - Acropolis OpenStack Services (OVM)

- ВМ на которой размещаются драйверы Acropolis. Отвечает за получение вызовов OpenStack RPCs от контроллера OpenStack и трансляцией их в стандартный API Acropolis.

OSC может располагаться на существующей ВМ или сервере, или может быть развернут как часть решения Nutanix OpenStack. OVM - является вспомогательной ВМ, и разворачивается как часть решения Nutanix OpenStack.

Клиенты взаимодействуют с OSC используя стандартные методы и способы (Web UI / HTTP, SDK, CLI or API), OSC взаимодействует с OVM которая преобразует запросы OpenStack API в стандартные вызовы REST API Acropolis, через Acropolis OpenStack Driver.

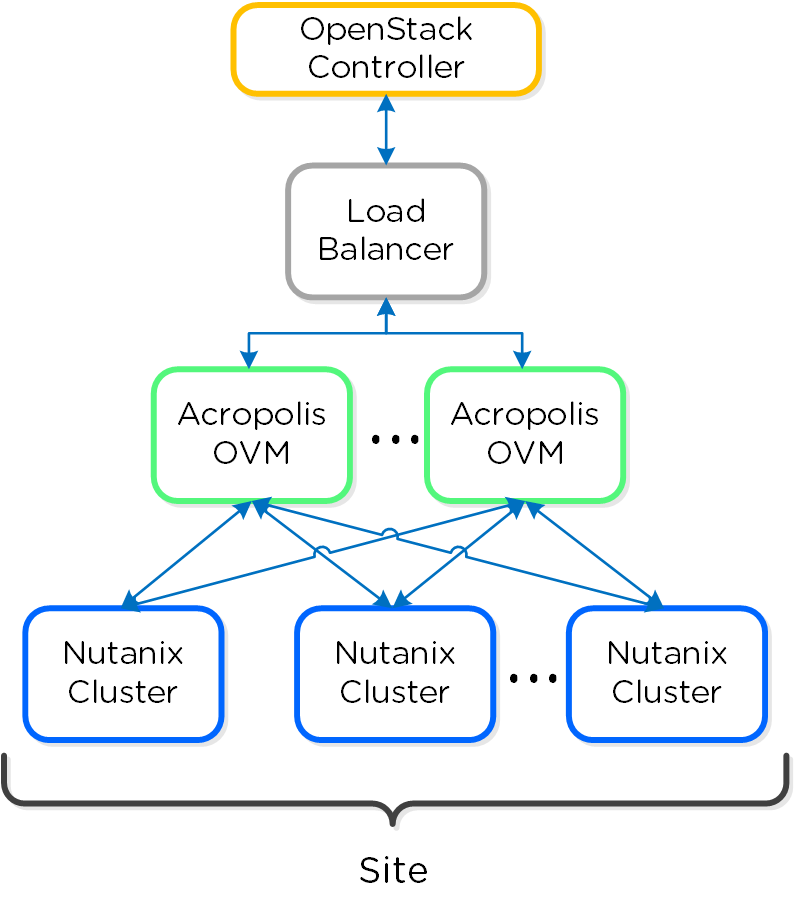

Верхнеуровневая схема взаимодействия компонент:

Такое решение позволяет использовать все преимущества OpenStack - пользовательский портал, API и так далее, без сложностей присущих классическим инсталляциям OpenStack. Все низкоуровневые сервисы (вычисление, хранение, сети) реализуются стандартными средствами Nutanix. А значит, нет необходимости разворачивать компоненты вроде Nova Compute, и так далее. Платформа будет принимать все стандартные запросы, и перенаправлять их к компонентам Nutanix, транслируя в вызовы Acropolis API. Кроме того, такое решение можно развернуть менее чем за 30 минут.

Поддерживаемые контроллеры OpenStack

На текущий момент (начиная с 4.5.1) поддерживаются версии OpenStack начиная с Kilo и более поздние.

Верхнеуровневый маппинг ролей:

| Объект | Роль | Контроллер OpenStack | Acropolis OVM | Кластер Acropolis | Prism |

|---|---|---|---|---|---|

| Пользовательский интерфейс | Пользовательский интерфейс и API | X | |||

| Административный интерфейс | Мониторинг и управление инфраструктурой | X | X | ||

| Оркестрация | Управление объектами (CRUD) и жизненным циклом | X | |||

| Квоты | Управоение ресурсами и лимитами на их использование | X | |||

| Пользователи, Группы и Роли | Управление на базе ролей пользователей (RBAC) | X | |||

| Единая точка входа | Сквозная авторизация | X | |||

| Интеграция с платформой | Интеграция OpenStack и Nutanix | X | |||

| Инфраструктурные сервисы | Целевая инфраструктура (вычисление, хранение, сеть) | X |

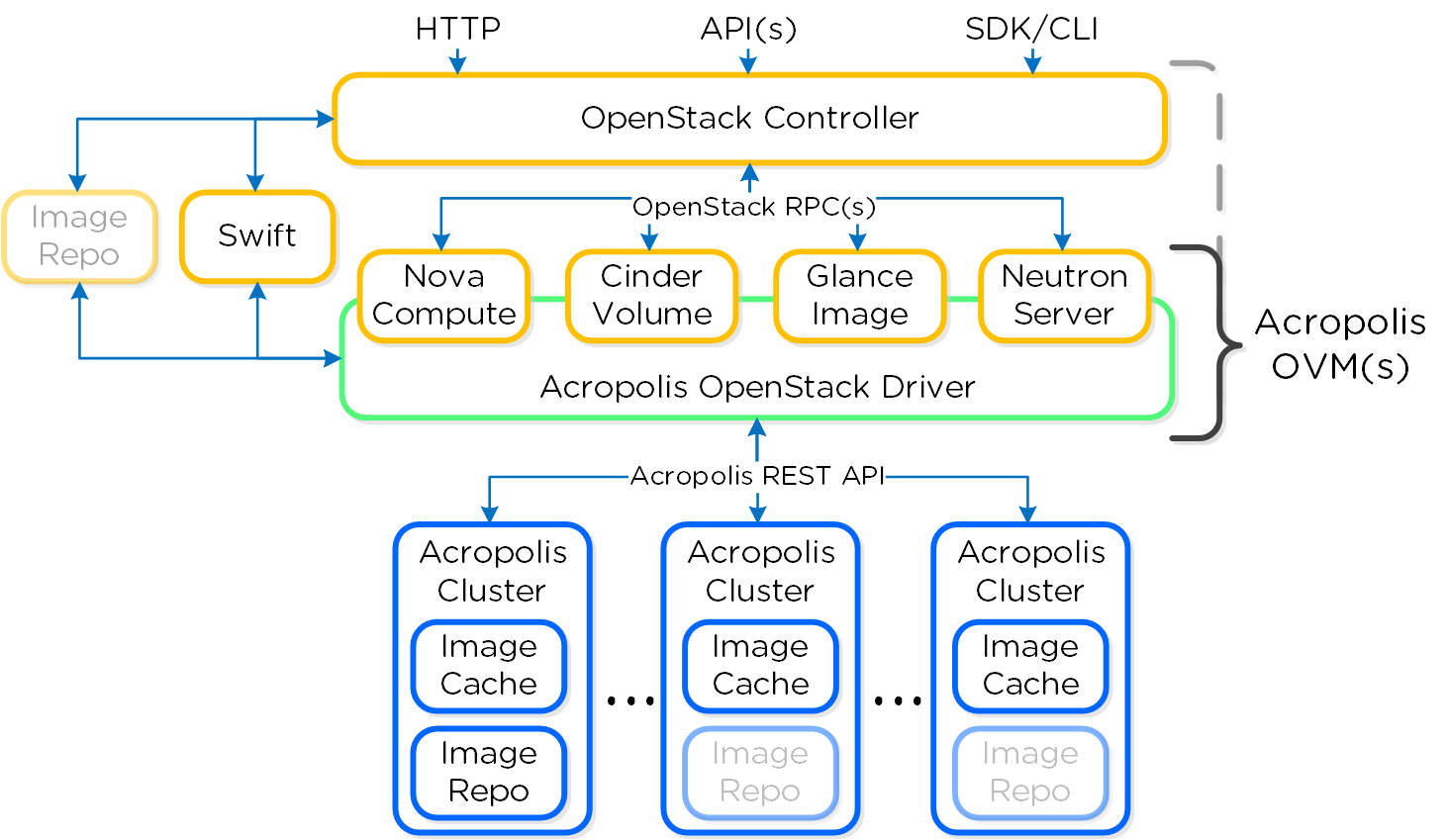

Компоненты OpenStack

OpenStack состоит из набора компонент, каждый компонент отвечает за какую-то инфраструктурную функцию. Некоторые из этих функций будут развернуты на базе контроллера OpenStack Controller, некоторые на базе Acropolis OVM.

Таблица показывает соотношение компонентов OpenStack и их инфраструктурных ролей:

| Компонент | Роль | Контролер OpenStack | Acropolis OVM |

|---|---|---|---|

| Keystone | Сервис идентификации | X | |

| Horizon | Веб-интерфейс | X | |

| Nova | Вычисление | X | |

| Swift | Объектное хранилище | X | X |

| Cinder | Блочное хранилище | X | |

| Glance | Хранилище образов | X | X |

| Neutron | Сеть | X | |

| Heat | Оркестрация | X | |

| Другие | Другие компоненты | X |

На рисунке отображено взаимодействие между компонентами OpenStack:

В следующем разделе мы остановимся на ключевых компонентах OpenStack и расскажем как они интегрированы с Nutanix.

Nova

Nova - подсистема управления вычислительными узлами и задачами. В решении Nutanix OpenStack каждая OVM выступает в роли вычислительного узла, так каждый Acropolis Cluster и узел внутри него могут быть использованы для создания ВМ OpenStack. Acropolis OVM управляет сервисом Nova.

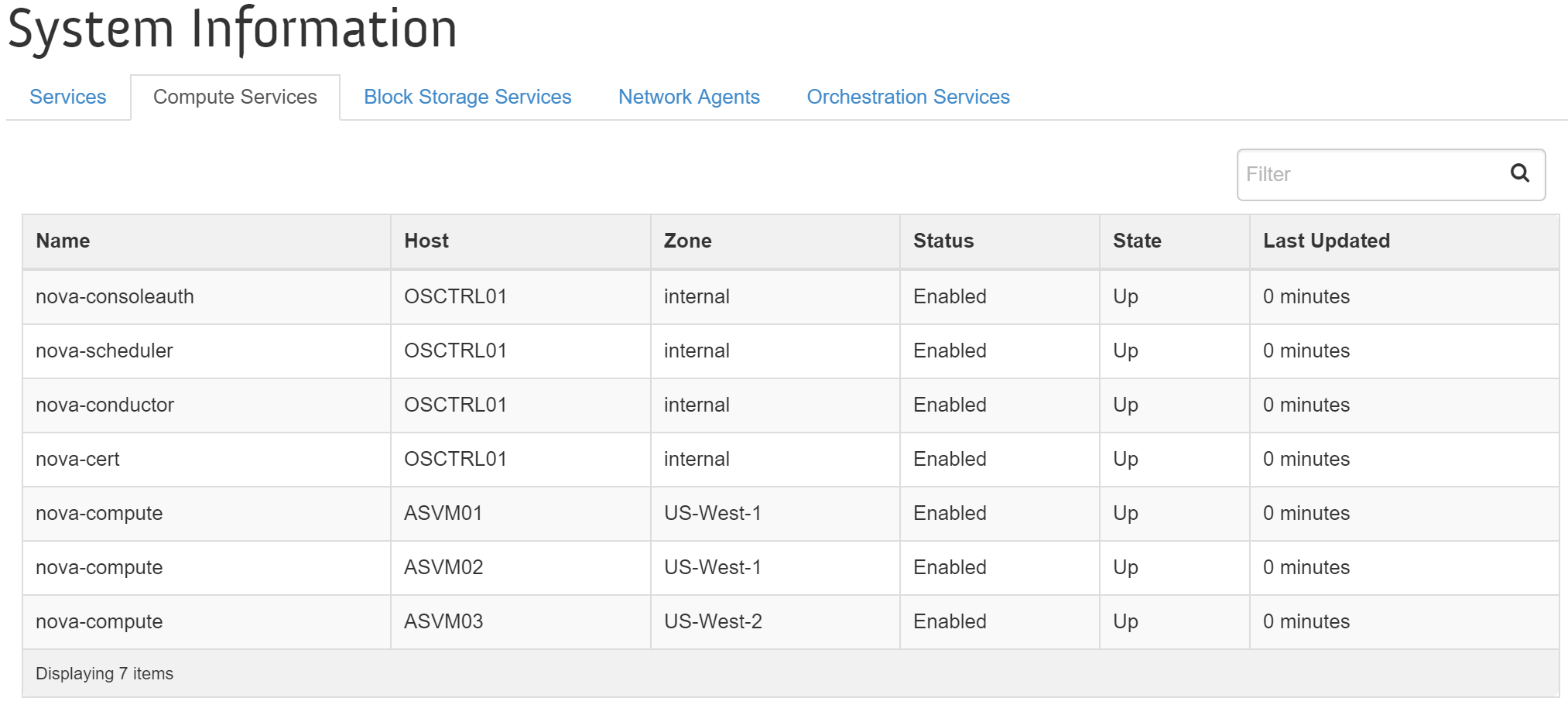

Все сервисы Nova доступны в веб-интерфейсе OpenStack на странице 'Admin'->'System'->'System Information'->'Compute Services'.

На рисунке показаны сервисы Nova, узлы и их статус:

Планировщик ресурсов Nova определяет на каком вычислительном узле (он же OVM) разместить ВМ на базе выбранных зон доступности. Такой запрос будет отправлен к выбранной OVM, а затем перенаправлен конкретному планировщику Acropolis (отвечающему за конкретный кластер). Планировщик Acropolis определит оптимальный узел для размещения ВМ внутри кластера. Конкретные узлы кластера Acropolis не отображаются в OpenStack.

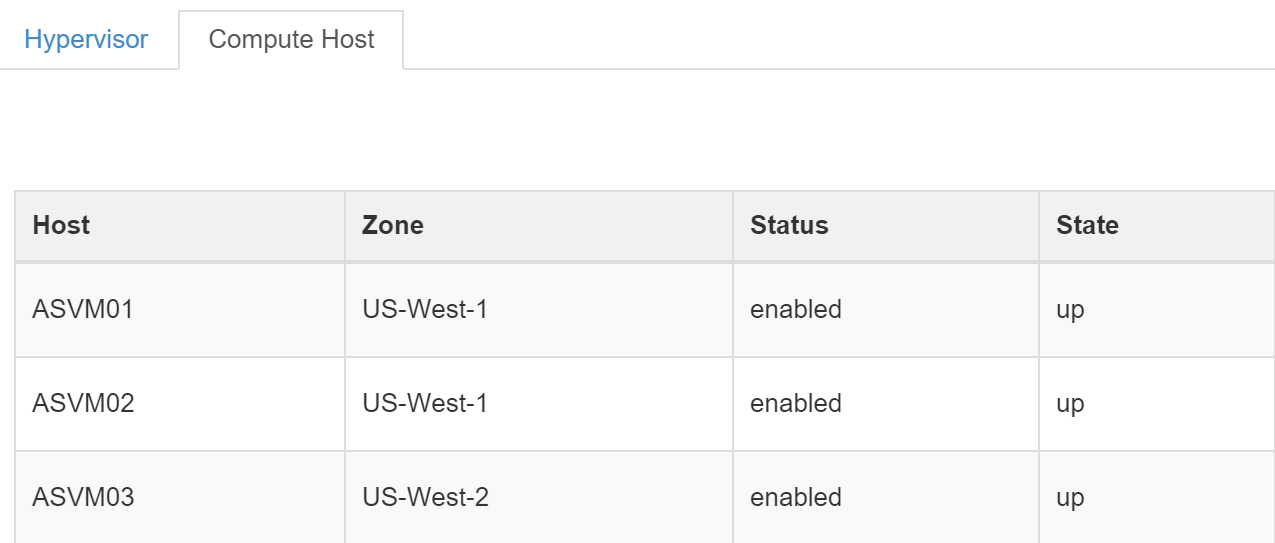

Вы можете увидеть доступные "вычислительные узлы" на портале OpenStack во вкладке 'Admin'->'System'->'Hypervisors'.

На рисунке ниже отображен перечень Acropolis OVM как список вычислительных узлов OpenStack:

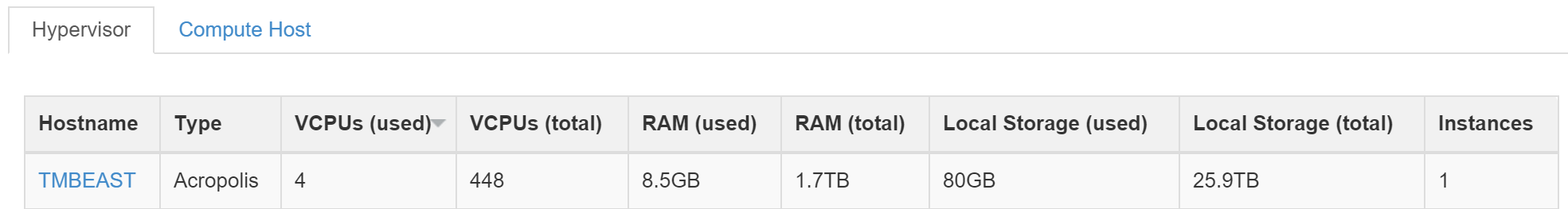

На рисунке ниже показан кластер Acropolis, OpenStack распознает его как гипервизор:

Как видно на рисунке выше - целый кластер Nutanix представлен как единственный гипервизор.

Swift

Swift - объектное хранилище, используемое для хранения файлов. Сейчас оно используется исключительно для создания и восстановления снимков и образов.

Cinder

Cinder - компонент управления хранилищем для взаимодействия с iSCSI. Cinder использует API по управлению томами в Acropolis. Эти тома будут подключены к ВМ напрямую, в качестве блочных устройств.

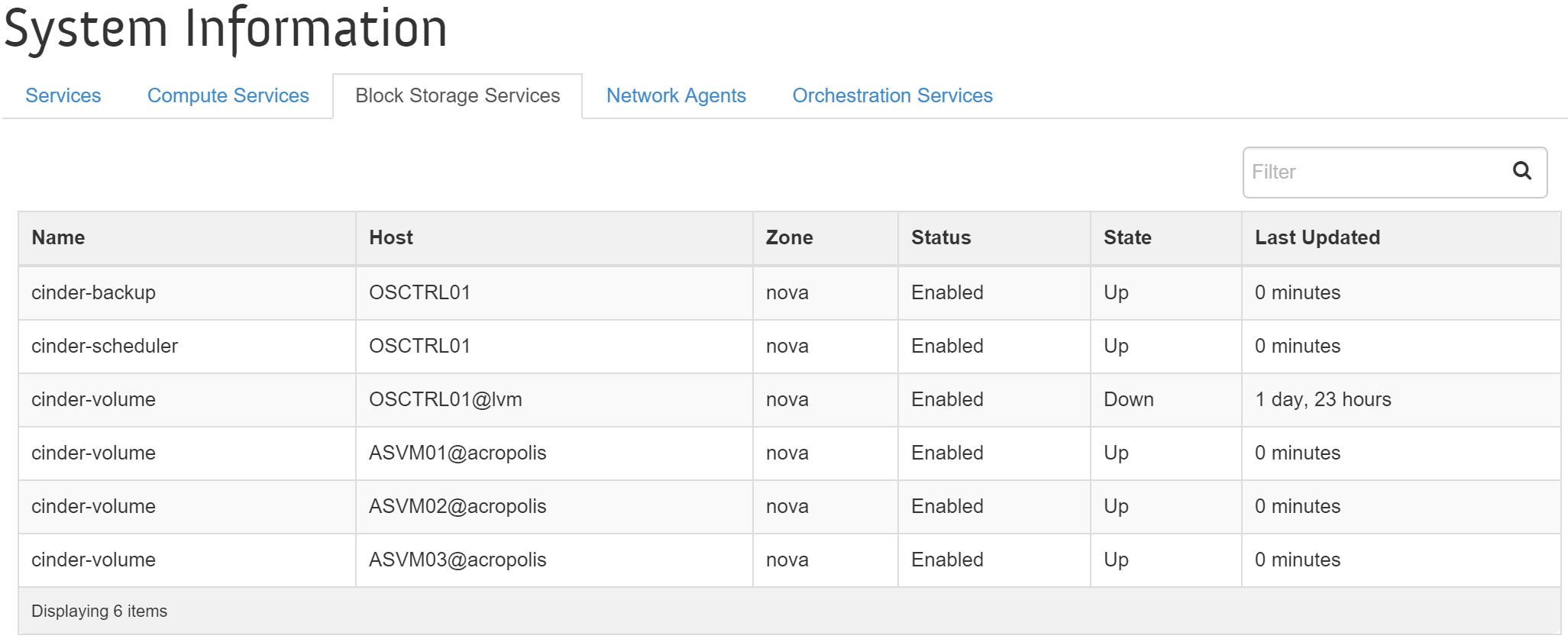

Вы можете увидеть перечень сервисов Cinder в интерфейсе OpenStack, в меню 'Admin'->'System'->'System Information'->'Block Storage Services'.

На рисунке показаны сервисы Cinder, узел и статус:

Glance - репозиторий образов

Glance это хранилище образов в инфраструктуре OpenStack. Через данный модуль происходит выдача информации о доступных для использования образов ВМ, снимков и ISO.

Репозиторий образов - хранилище образов под управлением Glance. Репозиторий может располагаться как в рамках платформы Nutanix, так и вне ее. Если образы хранятся на платформе Nutanix, они автоматически будут опубликован в OpenStack посредством Glance на OVM. Если хранилище образов настроено как внешний источник, Glance будет располагаться на контроллере OpenStack, а кэш образов будет использоваться кластером Acropolis.

Модуль Glance разворачивается для каждого кластера Acropolis и всегда содержит кэш образов. Когда Glance активирован на нескольких кластерах Nutanix - репозиторий образов будет охватывать все эти кластеры, и образы, создаваемые через портал OpenStack будут распространены по всем кластерам с Glance. Кластеры без сервиса Glance будут держать кэши образов при помощи кэша образов.

Примечание

Совет от создателей

В рамках больших инсталляций сервис Glance должен функционировать как минимум на двух кластерах Acropolis на площадку. Такая инсталляция обеспечит HA для репозитория образов даже для случая, и образы всегда будут доступны, даже если их нет в кэше.

Когда в качестве репозитория образов используется внешний ресурс, задачу доставки образов на кластер Acropolis берет на себя сервис Nova. Все необходимые образы будут перенесены в кэш образов, для быстрого доступа к ним, в случае необходимости.

Neutron

Сервис Neutron - сетевой компонент OpenStack который отвечает за настройку сети ВМ. OVM позволяет выполнять все CRUD операции, выполняемые из интерфейса OpenStack и осуществлять все необходимые задачи в Acropolis.

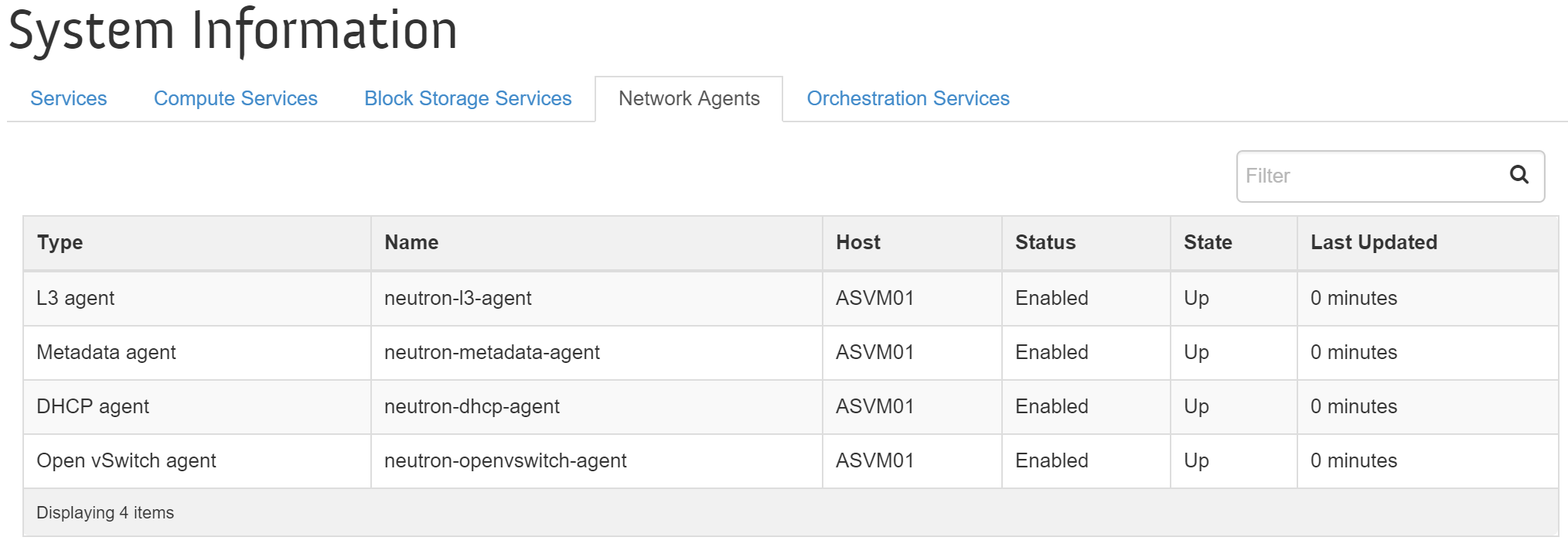

Вы можете посмотреть список сервисов Neutron через пользовательский интерфейс OpenStack, в меню 'Admin'->'System'->'System Information'->'Network Agents'.

На изображении показаны сервисы Neutron, узлы и статусы:

+ На текущий момент поддерживаются только два типа сети Local и VLAN.

+ На текущий момент поддерживаются только два типа сети Local и VLAN.

Сервис Neutron будет присваивать IP-адрес ВМ при каждой перезагрузке. В этом случае Acropolis резервирует требуемый адрес за ВМ которой он выдается. Когда ВМ выполняет DHCP запрос - Acropolis ответит на него в рамках VXLAN, как обычно в AHV.

Примечание

Поддерживаемые типы сетей

На текущий момент поддерживаются только два типа сети Local и VLAN.

Сервис Keystone и веб-интерфейс Horizon размещаются в OpenStack Controller в рамках Acropolis OVM. OVM содержит драйвер OpenStack отвечающий за трансляцию вызовов OpenStack API в стандартный Acropolis API.

Проектирование и инсталляция

Для масштабных инсталляций облачных инфраструктур важно использовать максимально распределенную инфраструктуру, которая будет отвечать запросам пользователя. И обеспечивать гибкость и локализацию вычислений и данных.

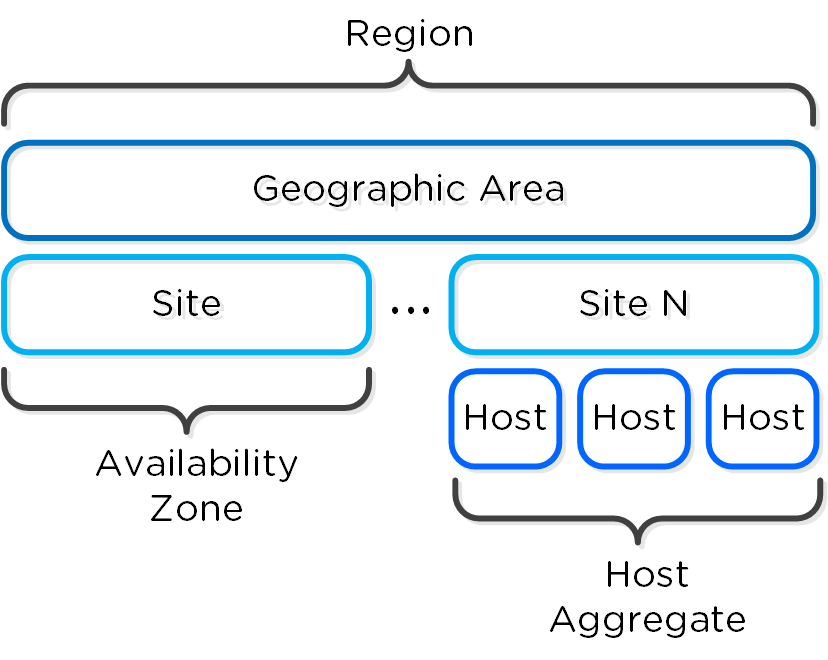

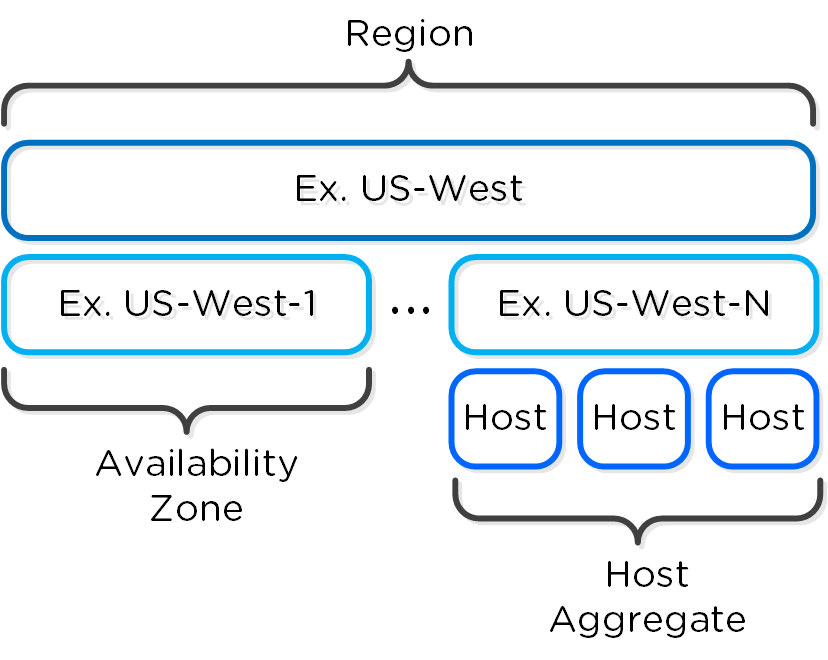

OpenStack имеет следующие высокоуровневые объекты:

-

Регионы (Region)

- Географический объект или область, включающие в себя по несколько зон доступности. Например, регионы - US-Northwest или US-West

-

Зоны доступности (Availability Zone)

- Специфический ЦОД или инсталляция, где размещаются облачные сервисы. Может включать площадки, например - US-Northwest-1 или US-West-1

-

Группы узлов (Host Aggregate)

- Группа вычислительных узлов - узел, стойка или же может соответствовать по размеру зоне доступности.

-

Вычислительные узлы (Compute Host)

- Acropolis OVM, где запущены сервисы Nova.

-

Гипервизоры (Hypervisor Host)

- Кластер Acropolis (выглядит как один узел с гипервизором).

Ниже показаны связи между этими компонентами:

Пример размещения приложений:

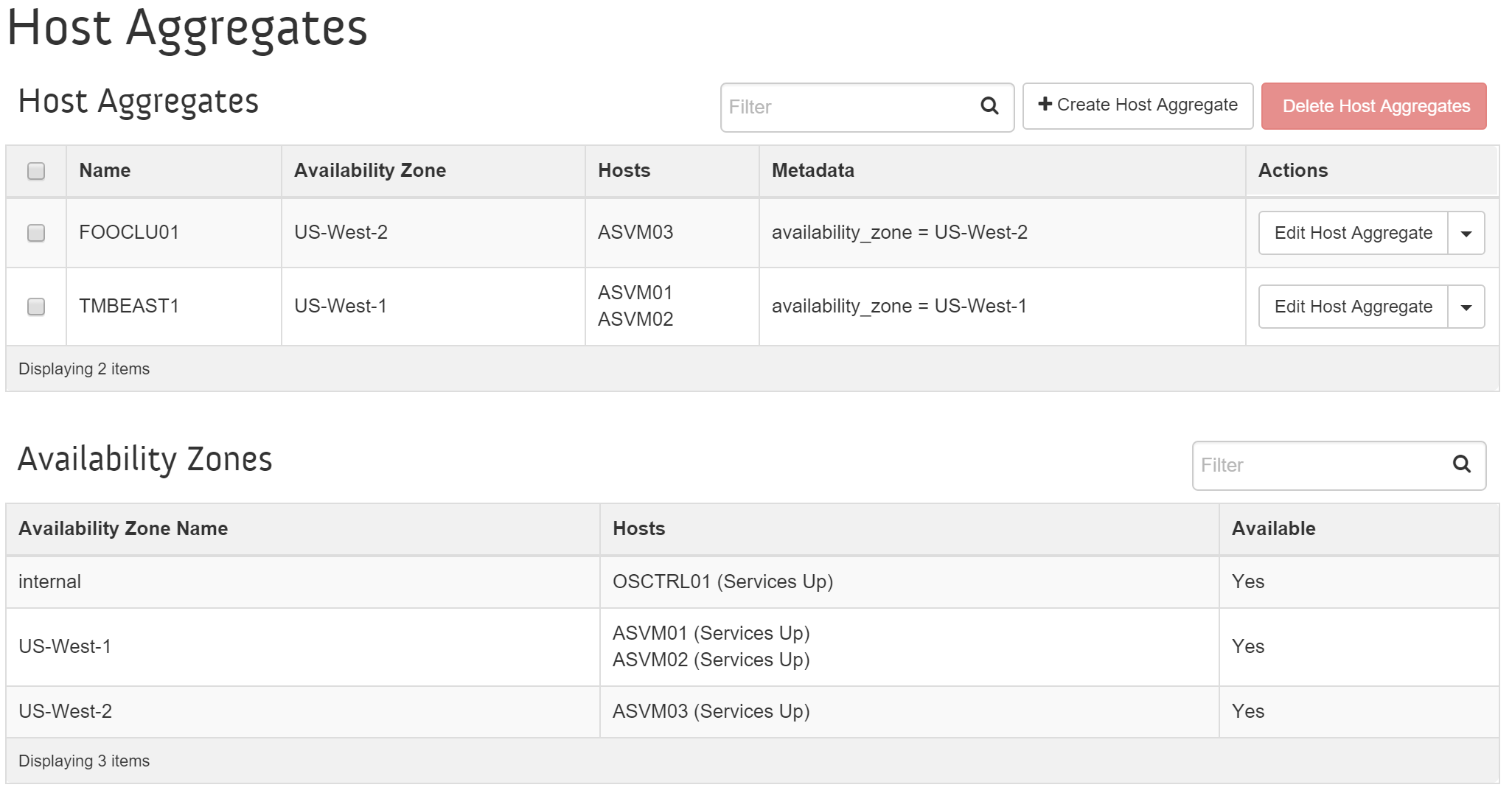

Перечень вычислительных узлов, групп и зон доступности можно посмотреть в меню интерфейса OpenStack: 'Admin'->'System'->'Host Aggregates'.

На рисунке изображены группы узлов, зоны доступности и вычислительные узлы непосредственно:

Проектирование и масштабирование

Для масштабных инсталляций рекомендуется использовать несколько Acropolis OVMs подключенных к OpenStack Controller и балансировку нагрузки между ними. Такой подход обеспечивает HA и распределяет нагрузку между несколькими OVM. OVM не содержат данных, по этому их количество может легко увеличиваться.

Ниже представлен пример схемы с использованием нескольких OVM в рамках одного ЦОД:

В качестве балансировщика можно использовать такие решения, как Keepalived и HAproxy.

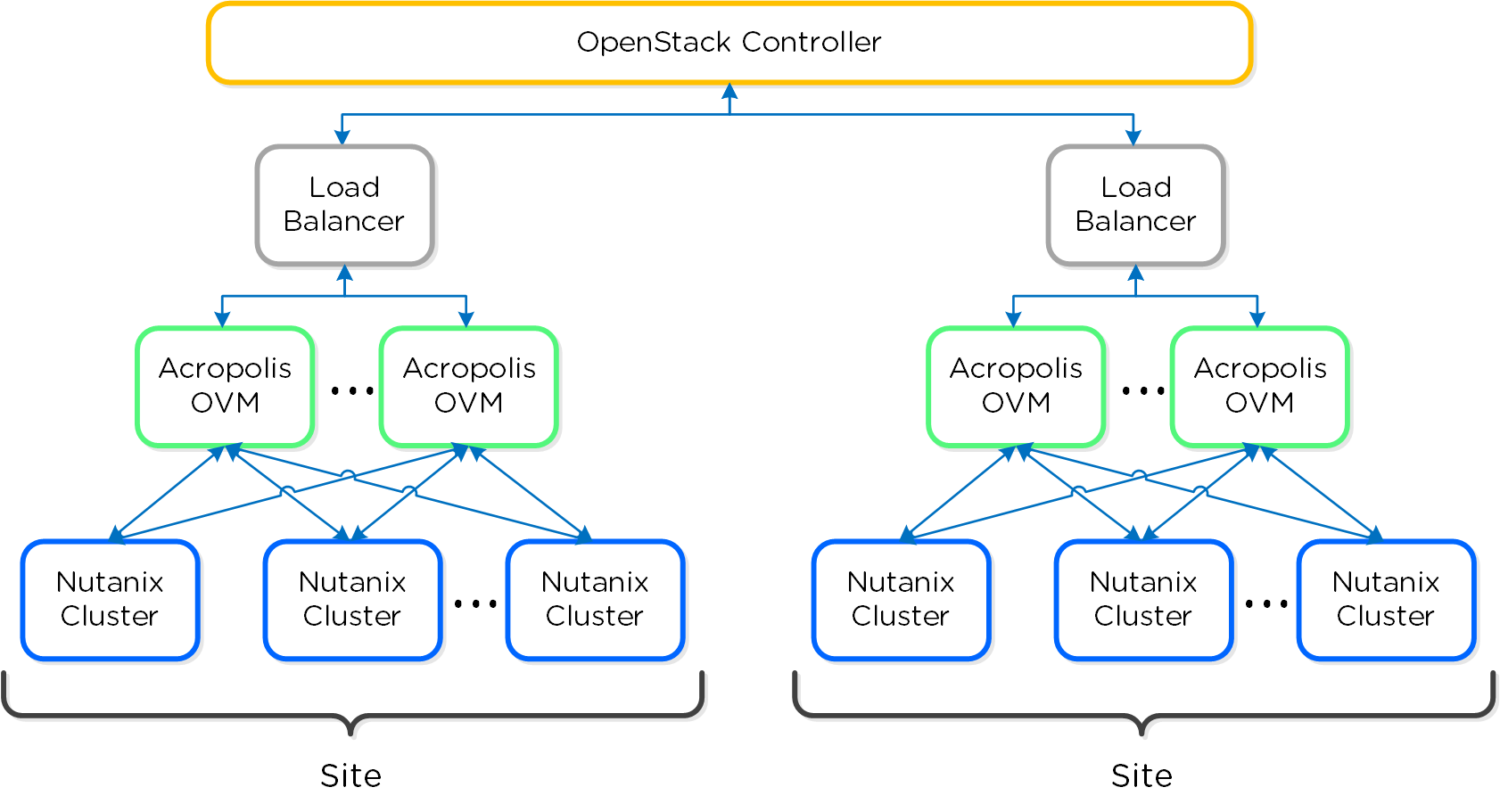

Для инсталляций в рамках нескольких ЦОД контроллер OpenStack будет взаимодействовать с несколькими OVM на разных площадках.

На рисунке пример схемы для нескольких ЦОД:

Инсталляция

OVM может быть развернут как ПО в виде RPM, в рамках CentOS / Redhat или же как ВМ целиком. Acropolis OVM может инсталлироваться на любую платформу - Nutanix или не-Nutanix, но должен иметь доступ к контроллеру OpenStack и кластеру Nutanix.

ВМ для Acropolis OVM может быть развернута на кластере Nutanix AHV следуя шагам, описанным ниже. Если OVM уже существует, этот пункт можно пропустить. Можно использовать готовый образ OVM или же использовать другую ВМ с CentOS / Redhat.

Для начала требуется импортировать все диски Acropolis OVM на кластер Acropolis. Это можно сделать, скопировав образы дисков с помощью SCP или же загрузить их по URL. Мы рассмотрим вариант с импортом образов с использованием API. Примечание: Как и говорилось ранее - можно развернуть эти ВМ где угодно, не обязательно на кластере Acropolis.

Для импорта образов требуется выполнить следующие команды:

image.create <IMAGE_NAME> source_url=<SOURCE_URL> container=<CONTAINER_NAME>

Теперь нужно создать ВМ для ПО OVM выполнив следующие команды ACLI на любой из CVM, в рамках кластера:

vm.create <VM_NAME> num_vcpus=2 memory=16G

vm.disk_create <VM_NAME> clone_from_image=<IMAGE_NAME>

vm.nic_create <VM_NAME> network=<NETWORK_NAME>

vm.on <VM_NAME>

После создания OVM - включите ее, подключиться по SSH и ввести данные учетной записи.

Примечание

Справка OVMCTL

Справочаня информация доступна при выполнении команды на OVM:

ovmctl --help

OVM поддерживает следующие типы инсталляции:

-

OVM-все-в-одном

- OVM включает все драйверы Acropolis и контроллер OpenStack

-

OVM-как-сервис

- OVM включает в себя все драйверы Acropolis и взаимодействует с внешним контроллером OpenStack

Оба типа инсталляции расписаны в разделе ниже. Вы можете использовать любой тип инсталляции, а так же переключаться между ними.

OVM-все-в-одном

Следующие шаги описывают инсталляцию OVM-все-в-одном. Для настройки требуется подключиться по SSH к OVM(s) и выполнить перечисленные команды.

# Регистрация сервиса драйвера OpenStack

ovmctl --add ovm --name <OVM_NAME> --ip <OVM_IP> --netmask <NET_MASK> --gateway <DEFAULT_GW> --domain <DOMAIN> --nameserver <DNS>

# Регистрация контроллера OpenStack

ovmctl --add controller --name <OVM_NAME> --ip <OVM_IP>

# Регистрация кластера Acropolis

ovmctl --add cluster --name <CLUSTER_NAME> --ip <CLUSTER_IP> --username <PRISM_USER> --password <PRISM_PASSWORD>

Следующие значения являются стандартными:

Количество VCPUs на ядро = 4

Стандартное имя контейнера = default

Кэш образов = disabled, URL адрес кэша образов = None

Проверяем правильность конфигурации:

ovmctl --show

Если команда вернет информацию - значит все хорошо.

OVM-как-сервис

Следующие шаги описывают инсталляцию OVM в виде сервиса. Для настройки требуется подключиться по SSH к OVM(s) и выполнить перечисленные команды.

# Регистрация сервиса драйвера OpenStack

ovmctl --add ovm --name <OVM_NAME> --ip <OVM_IP>

# Регистрация контроллера OpenStack

ovmctl --add controller --name <OS_CONTROLLER_NAME> --ip <OS_CONTROLLER_IP> --username <OS_CONTROLLER_USERNAME> --password <OS_CONTROLLER_PASSWORD>

Следующие значения являются стандартными:

Аутентификация: auth_strategy = keystone, auth_region = RegionOne

auth_tenant = services, auth_password = admin

База данных: db_{nova,cinder,glance,neutron} = mysql, db_{nova,cinder,glance,neutron}_password = admin

RPC: rpc_backend = rabbit, rpc_username = guest, rpc_password = guest

# Регистрация кластеров Acropolis

ovmctl --add cluster --name <CLUSTER_NAME> --ip <CLUSTER_IP> --username <PRISM_USER> --password <PRISM_PASSWORD>

Следующие значения являются стандартными:

Количество VCPUs на ядро = 4

Стандартное имя контейнера = default

Кэш образов = disabled, URL адрес кэша образов = None

Если при инсталляции контроллера OpenStack используются нестандартные пароли необходимо обновить их:

# Обновление паролей контроллера

ovmctl --update controller --name <OS_CONTROLLER_NAME> --auth_nova_password <> --auth_glance_password <> --auth_neutron_password <> --auth_cinder_password <> --db_nova_password <> --db_glance_password <> --db_neutron_password <> --db_cinder_password <>

Проверяем правильность конфигурации:

ovmctl --show

Теперь, когда OVM настроена, требуется настроить контроллер OpenStack на использование Glance и Neutron.

Подключитесь к контроллеру OpenStack и введите следующие команды:

# enter keystonerc_admin

source ./keystonerc_admin

Для начала требуется удалить существующие записи:

# Определите старый id сервиса Glance (порт 9292)

keystone endpoint-list

# Удалите старую запись

keystone endpoint-delete <GLANCE_ENDPOINT_ID>

Теперь нужно создать новую запись Glance которая будет указывать на OVM:

# Определите id сервиса Glance

keystone service-list | grep glance

# Вывод будет похож на:

| 9e539e8dee264dd9a086677427434982 | glance | image |

# Добавьте запись

keystone endpoint-create \

--service-id <GLANCE_SERVICE_ID> \

--publicurl http://<OVM_IP>:9292 \

--internalurl http://<OVM_IP>:9292 \

--region <REGION_NAME> \

--adminurl http://<OVM_IP>:9292

Теперь нужно удалить запись Neutron, указывающую на контроллер:

# Определите id старого сервиса Neutron (порт 9696)

keystone endpoint-list

# Удалите старую запись Neutron

keystone endpoint-delete <NEUTRON_ENDPOINT_ID>

Далее - создать новую запись для Neutron, которая будет указывать на OVM:

# Определите id сервиса Neutron

keystone service-list | grep neutron

# Вывод будет похож на:

| f4c4266142c742a78b330f8bafe5e49e | neutron | network |

# Добавьте новую запись Neutron

keystone endpoint-create \

--service-id <NEUTRON_SERVICE_ID> \

--publicurl http://<OVM_IP>:9696 \

--internalurl http://<OVM_IP>:9696 \

--region <REGION_NAME> \

--adminurl http://<OVM_IP>:9696

После обновления записей нужно обновить конфигурацию сервисов Nova и Cinder, указать адрес OVM в качестве адреса Glance сервиса.

Сначала нужно внести изменения в файл Nova.conf - /etc/nova/nova.conf:

[glance]

...

# Default glance hostname or IP address (string value)

host=<OVM_IP>

# Default glance port (integer value)

port=9292

...

# A list of the glance api servers available to nova. Prefix

# with https:// for ssl-based glance api servers.

# ([hostname|ip]:port) (list value)

api_servers=<OVM_IP>:9292

Далее - отключить сервис nova-compute на контроллере OpenStack (если еще не отключен):

systemctl disable openstack-nova-compute.service

systemctl stop openstack-nova-compute.service

service openstack-nova-compute stop

Затем внести изменения в файл /etc/cinder/cinder.conf :

# Default glance host name or IP (string value)

glance_host=<OVM_IP>

# Default glance port (integer value)

glance_port=9292

# A list of the glance API servers available to cinder

# ([hostname|ip]:port) (list value)

glance_api_servers=$glance_host:$glance_port

Так же требуется закомментировать строки:

# Comment out the following lines in cinder.conf

#enabled_backends=lvm

#[lvm]

#iscsi_helper=lioadm

#volume_group=cinder-volumes

#iscsi_ip_address=

#volume_driver=cinder.volume.drivers.lvm.LVMVolumeDriver

#volumes_dir=/var/lib/cinder/volumes

#iscsi_protocol=iscsi

#volume_backend_name=lvm

Затем отключить сервис cinder на контроллере OpenStack:

systemctl disable openstack-cinder-volume.service

systemctl stop openstack-cinder-volume.service

service openstack-cinder-volume stop

Затем отключить сервис glance-image на контроллере OpenStack:

systemctl disable openstack-glance-api.service

systemctl disable openstack-glance-registry.service

systemctl stop openstack-glance-api.service

systemctl stop openstack-glance-registry.service

service openstack-glance-api stop

service openstack-glance-registry stop

После изменения конфигурационных файлов требуется перезагрузить сервисы Nova и Cinder, чтобы изменения вступили в силу. Это можно сделать или используя команды ниже или запустив скрипты, которые доступны для загрузки.

# Перезапуск сервисов Nova

service openstack-nova-api restart

service openstack-nova-consoleauth restart

service openstack-nova-scheduler restart

service openstack-nova-conductor restart

service openstack-nova-cert restart

service openstack-nova-novncproxy restart

# или запустите скрипт:

~/openstack/commands/nova-restart

# Перезапуск сервисов Cinder

service openstack-cinder-api restart

service openstack-cinder-scheduler restart

service openstack-cinder-backup restart

# или запустите скрипт:

~/openstack/commands/cinder-restart

Puppet

Puppet - решение для управления жизненным циклом конфигураций (LCM) которое широко используется в DevOps.

Поиск и устранение неисправностей

Расположение основных журнальных файлов

| Компонент | Путь к журналу |

|---|---|

| Keystone | /var/log/keystone/keystone.log |

| Horizon | /var/log/horizon/horizon.log |

| Nova | /var/log/nova/nova-api.log /var/log/nova/nova-scheduler.log /var/log/nova/nove-compute.log* |

| Swift | /var/log/swift/swift.log |

| Cinder | /var/log/cinder/api.log /var/log/cinder/scheduler.log /var/log/cinder/volume.log |

| Glance | /var/log/glance/api.log /var/log/glance/registry.log |

| Neutron | /var/log/neutron/server.log /var/log/neutron/dhcp-agent.log* /var/log/neutron/l3-agent.log* /var/log/neutron/metadata-agent.log* /var/log/neutron/openvswitch-agent.log* |

Журналы помеченные звездочкой доступны только на Acropolis OVM.

Примечание

Совет от создателей

Если сервер OpenStack Manager помечен как 'down', даже если сервис в OVM функционирует - проверьте NTP. Большинство сервисов требует синхронизации времени между контроллером OpenStack и Acropolis OVM.

Справочник по командам

Загрузите источник для Keystone source (выполняется перед выполнением других команд)

source keystonerc_admin

Список сервисов Keystone

keystone service-list

Список записей Keystone

keystone endpoint-list

Создание записи Keystone

keystone endpoint-create \

--service-id=<SERVICE_ID> \

--publicurl=http://<IP:PORT> \

--internalurl=http://<IP:PORT> \

--region=<REGION_NAME> \

--adminurl=http://<IP:PORT>

Список сервисов Nova

nova list

Просмотр информации о сервисе

nova show <INSTANCE_NAME>

Список гипервизоров Nova

nova hypervisor-list

Просмотр информации о гипервизорах

nova hypervisor-show <HOST_ID>

Список образов Glance

glance image-list

Просмотр информации о образах Glance

glance image-show <IMAGE_ID>

Part III. Книга Acropolis

a·crop·o·lis - /ɘ ' kräpɘlis/ - noun - data plane

Платформа хранения, вычисления и виртуализации.

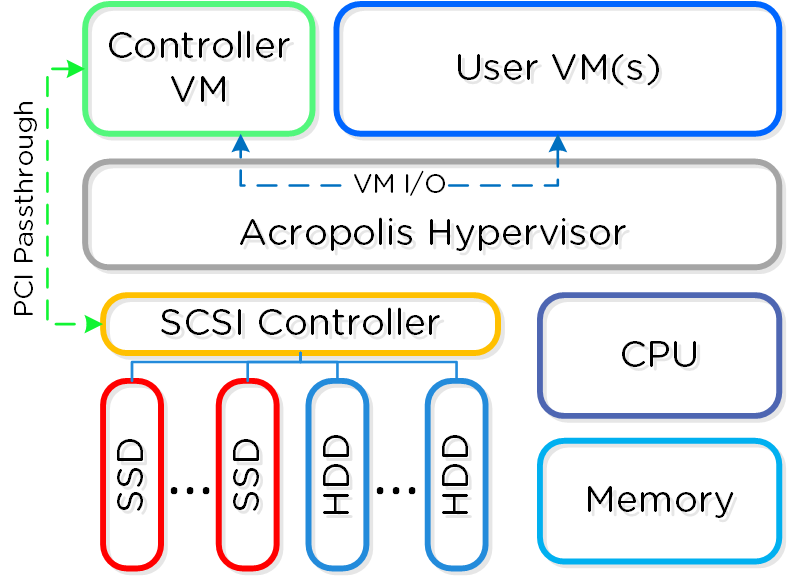

Архитектура

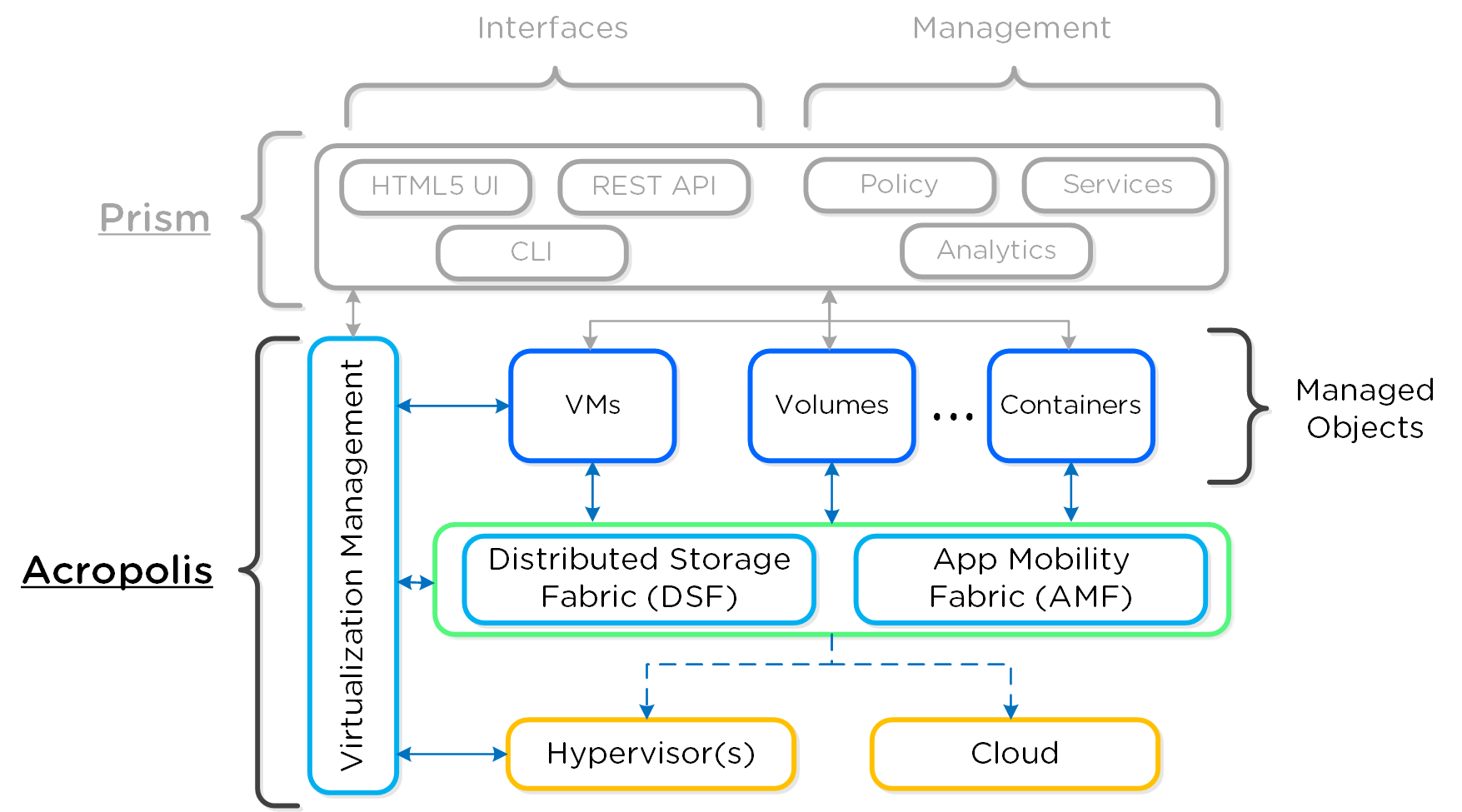

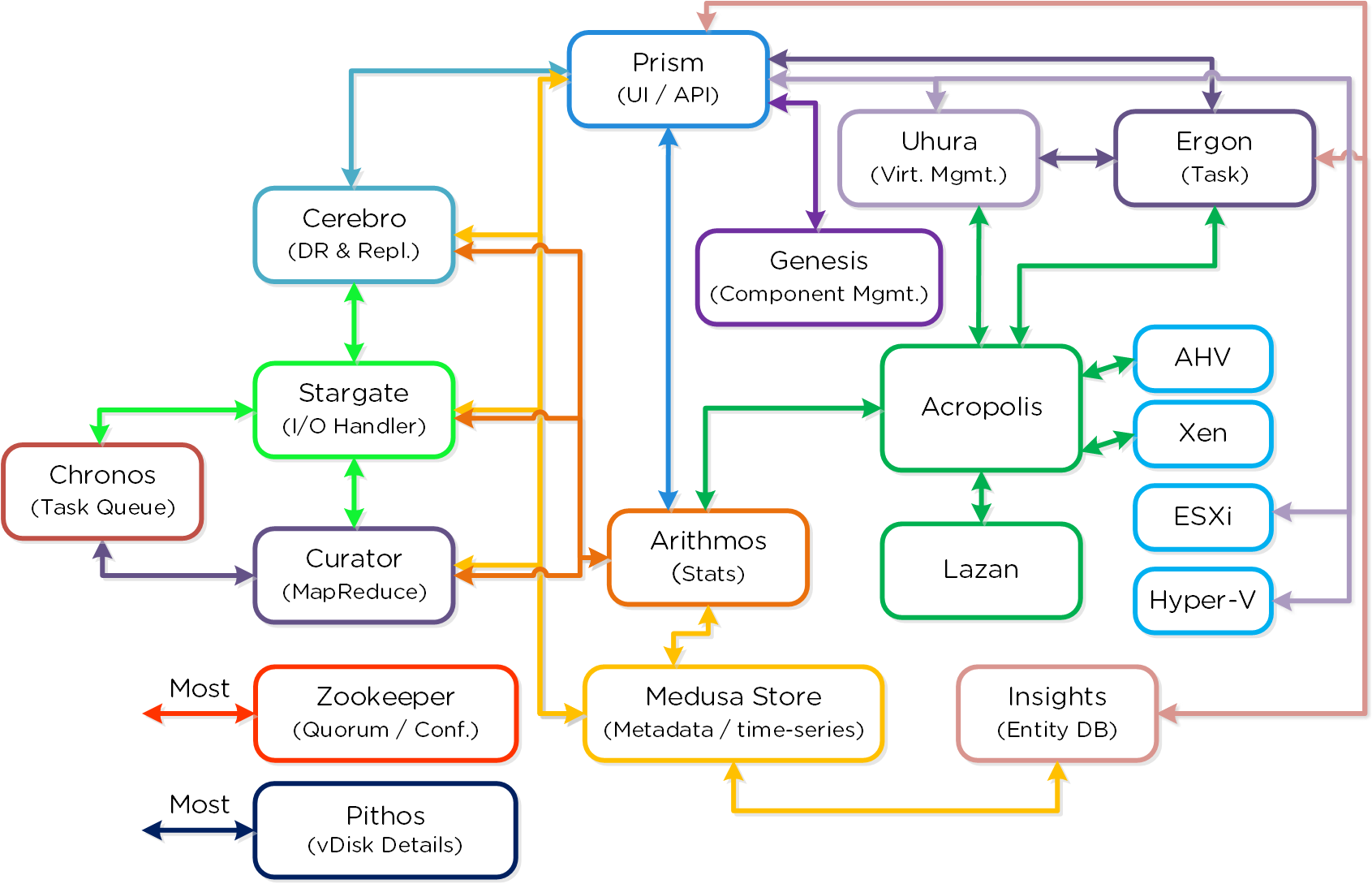

Acropolis - это распределенная программная платформа управления и оркестрации.

Рассмотрим три основных компонента:

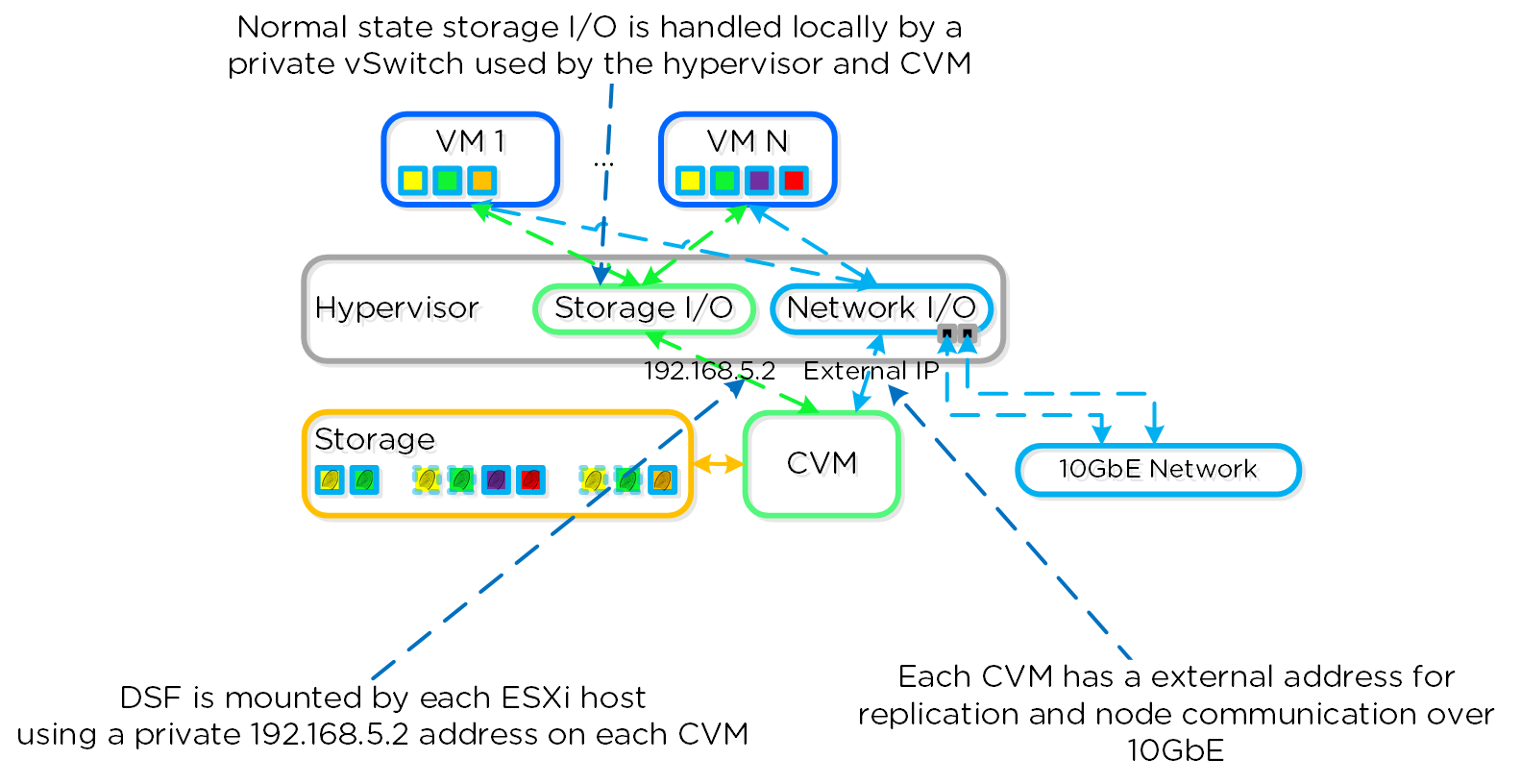

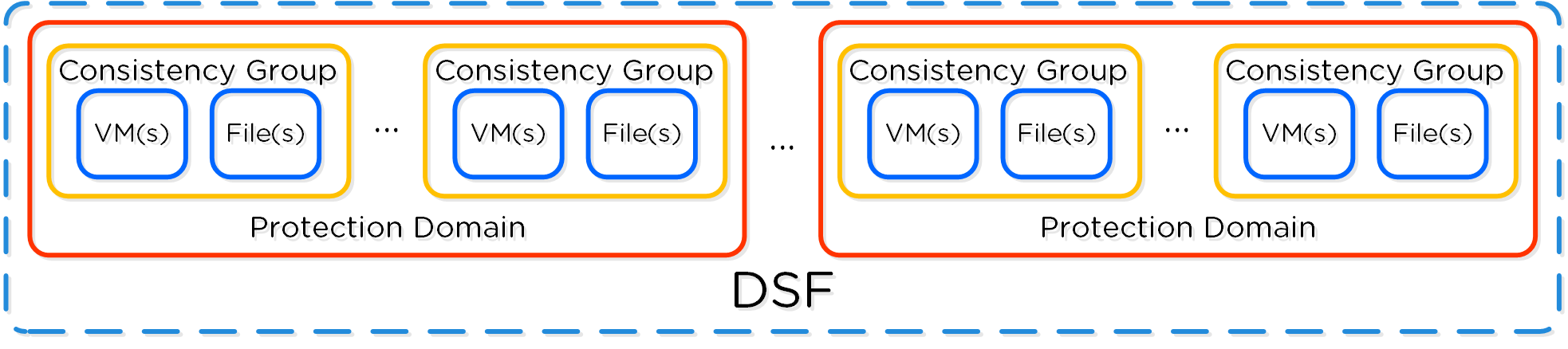

- Распределенная система управления хранилищем (Distributes Storage Fabric - DSF)

- Это то, с чего началась платформа Nutanix, это ПО тесно связано с распределённой файловой системой Nutanix (NDFS). Теперь NDFS не просто система объединяющая все диски в единый ресурсный пул, а нечто большее - платформа хранения с широчайшей функциональностью.

- Распределенная система управления приложениями (App Mobility Fabric - AMF)

- Гипервизор абстрагирует гостевые ОС от аппаратного уровня, а AMF абстрагирует выполнение задач от гипервизора (ВМ, Хранилище, контейнеры и т.д.). Это ПО позволяет динамически перемещать нагрузку между гипервизорами и облаками, именно этот компонент предоставляет возможность менять гипервизор на узлах Nutanix.

- Гипервизор

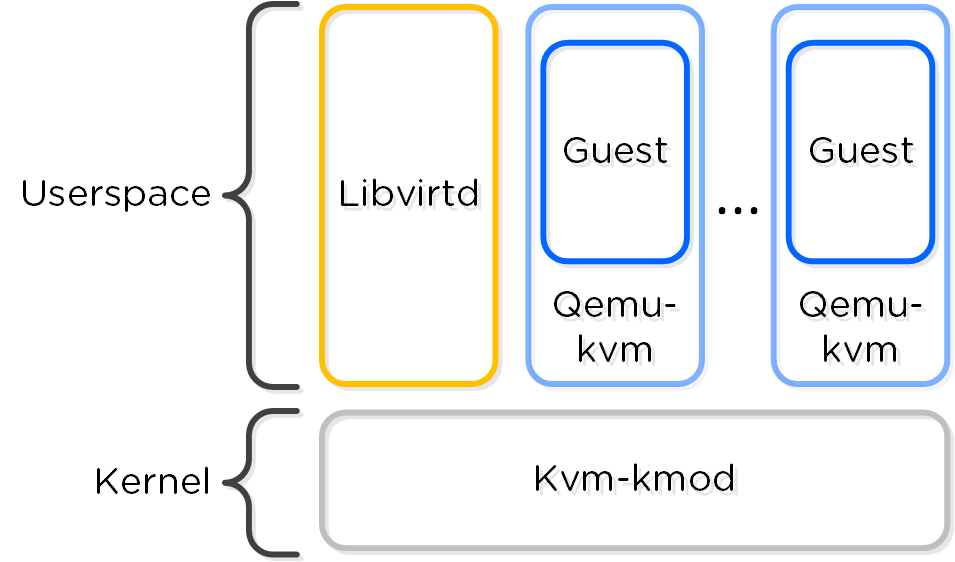

- Многофункциональный гипервизор на основе CentOS и KVM.

Все ПО Nutanix являются распределенными, такие же решения используются на уровнях виртуализации и управления ресурсами. Служебные сервисы Acropolis управляют нагрузками, ресурсами, созданием и управлением ВМ. Acropolis абстрагирует служебные подсистемы и задачи от пользовательских нагрузок.

Такая структура позволяет переносить нагрузки между гипервизорами, поставщиками облачных решений и платформами.

Ниже показана концептуальная верхнеуровневая архитектура Acropolis:

Примечание

Поддерживаемые гипервизоры

Начиная с версии ПО 4.7, управление ВМ и другими объектами поддерживаться для AHV и ESXi, однако в будущем данный список может быть увеличен. API по управлению хранилищем и операций чтения данных о объектах доступно для всех гипервизоров.

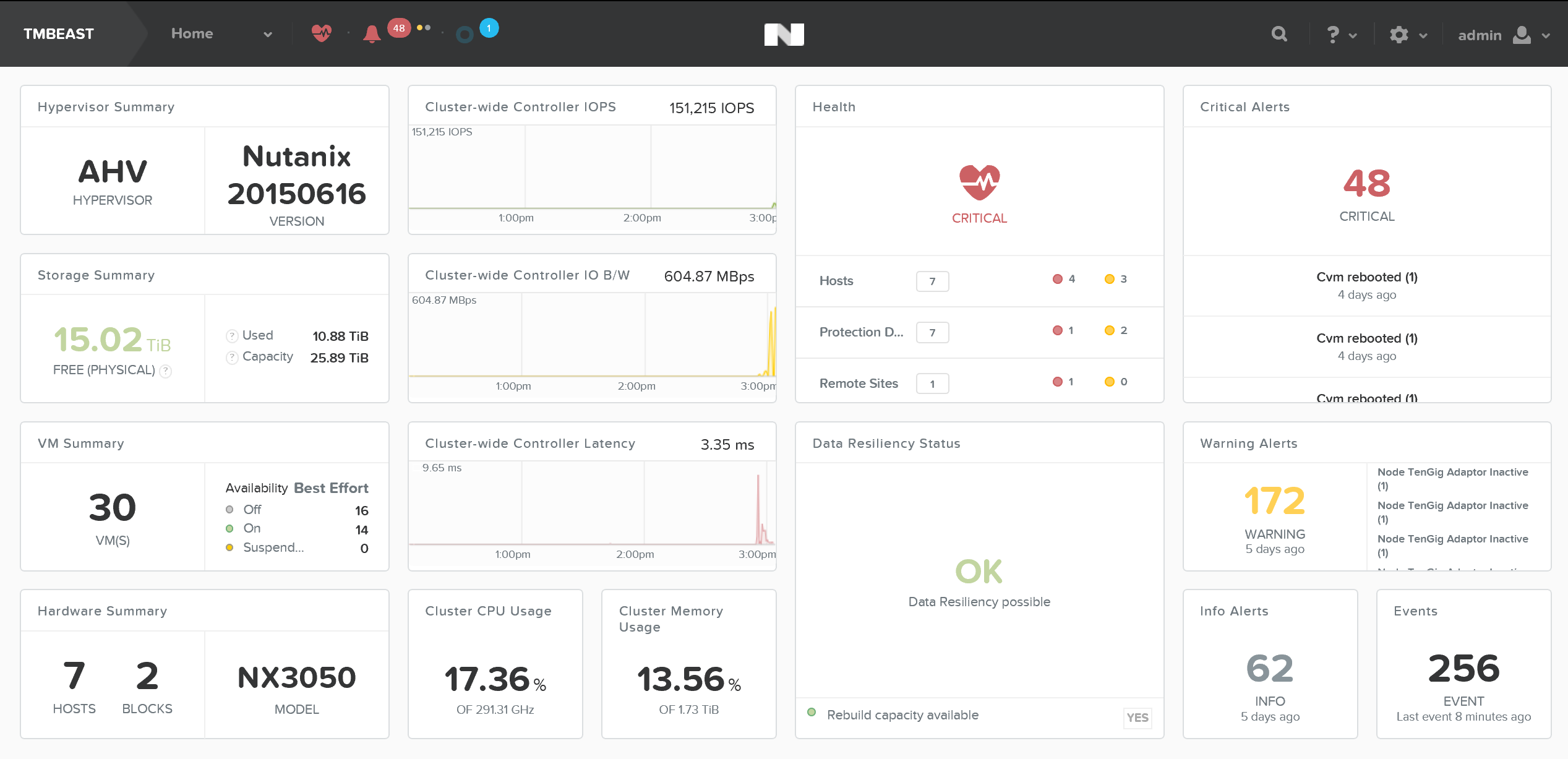

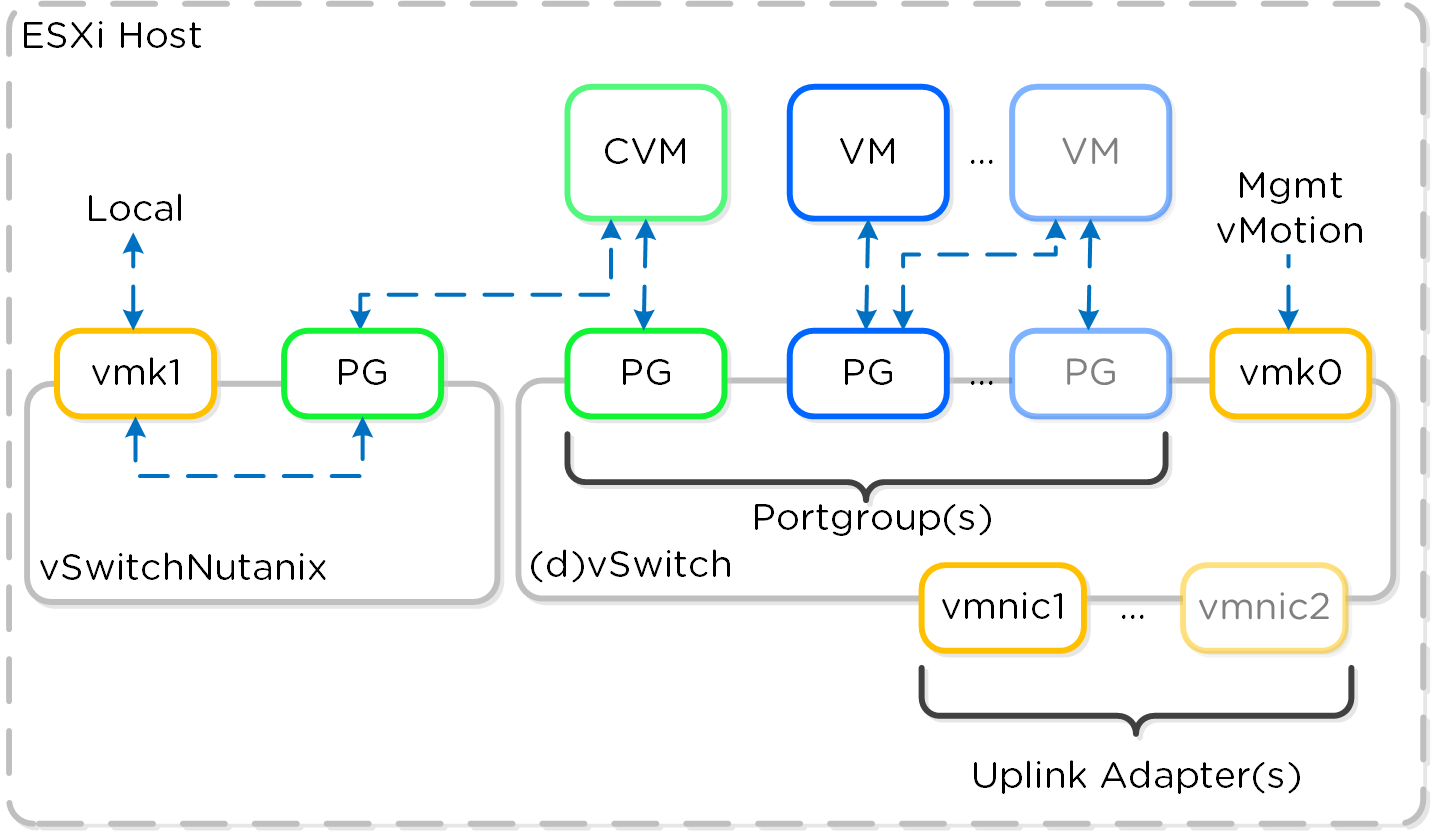

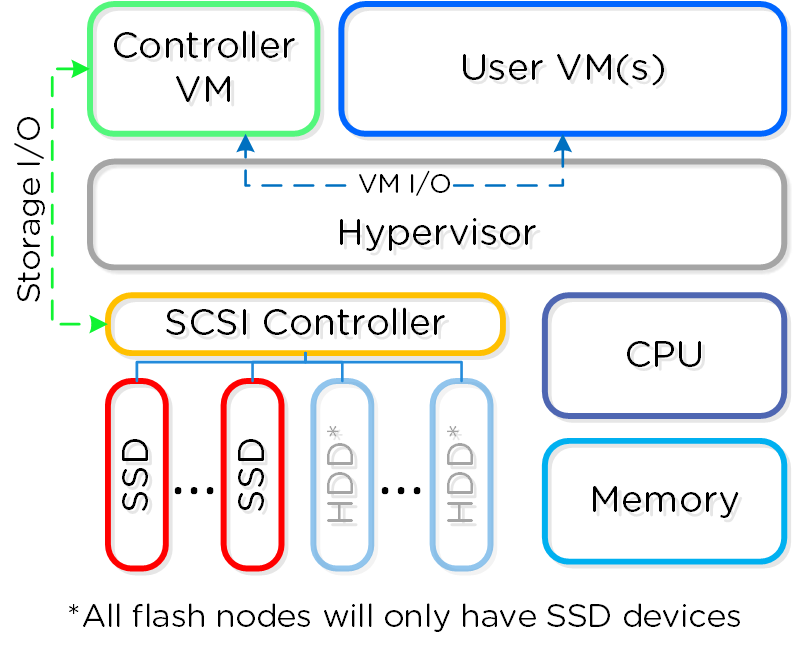

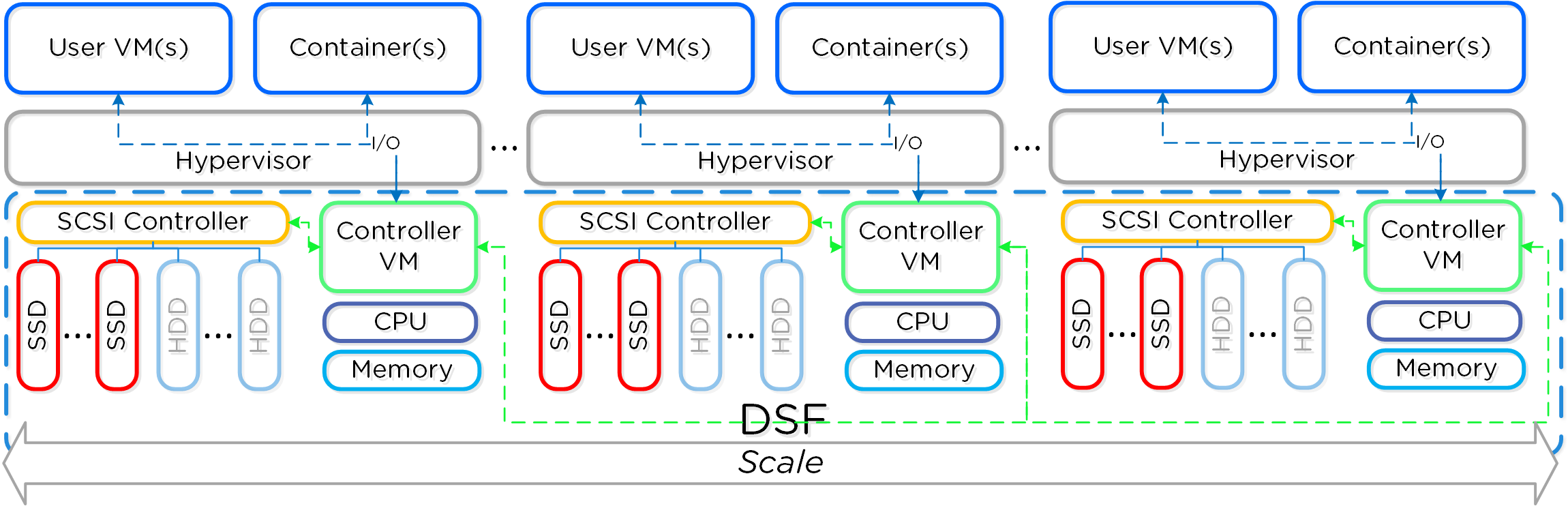

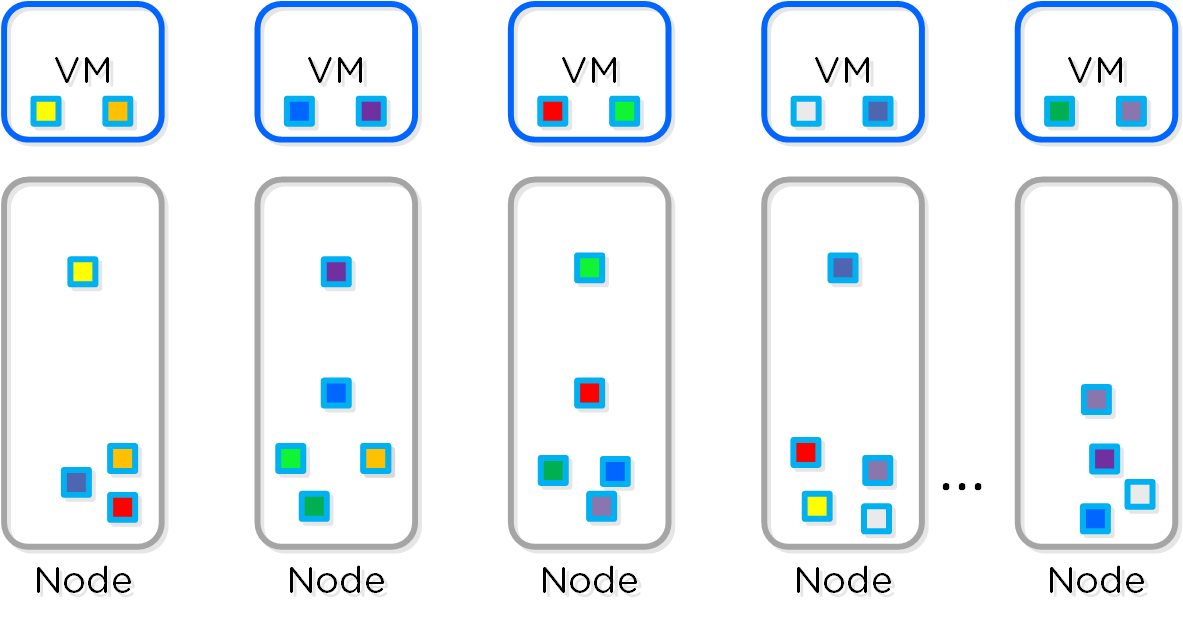

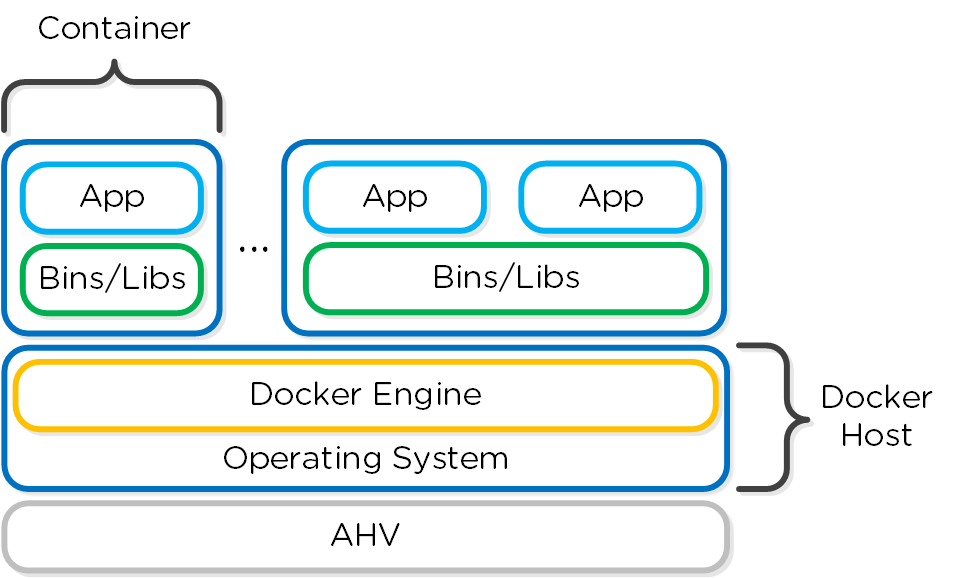

Гиперконвергентная платформа

Краткий рассказ на английском языке доступен по ссылке

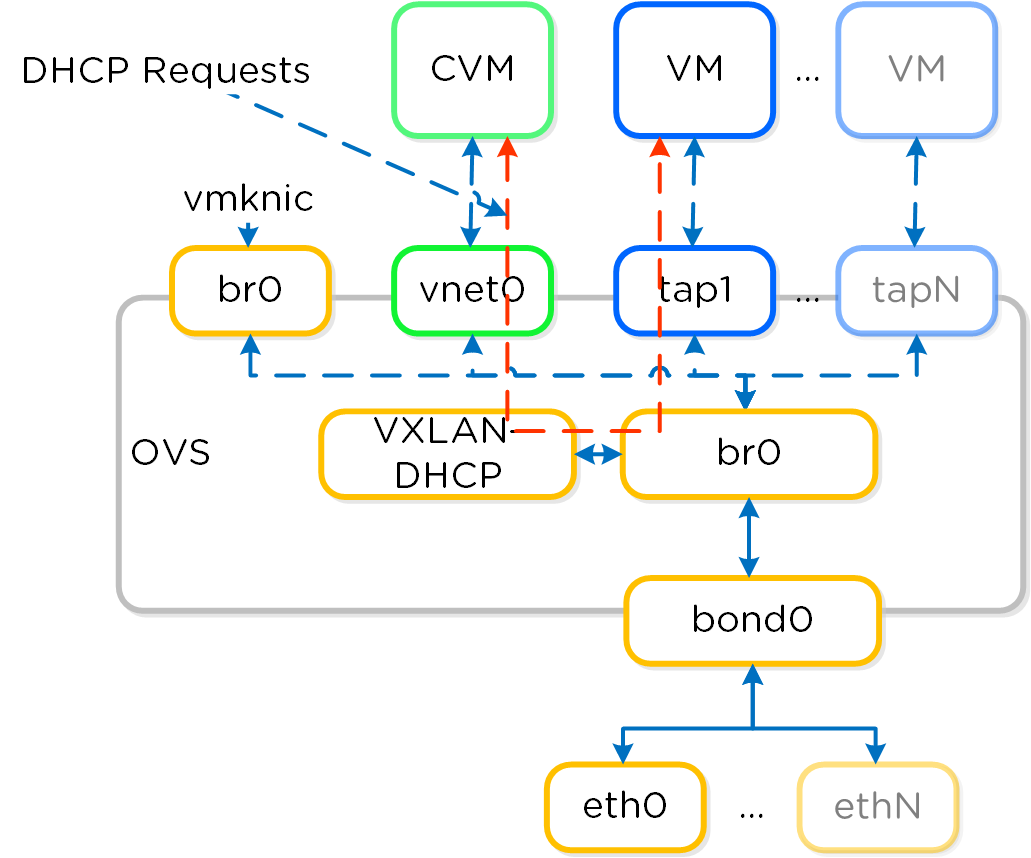

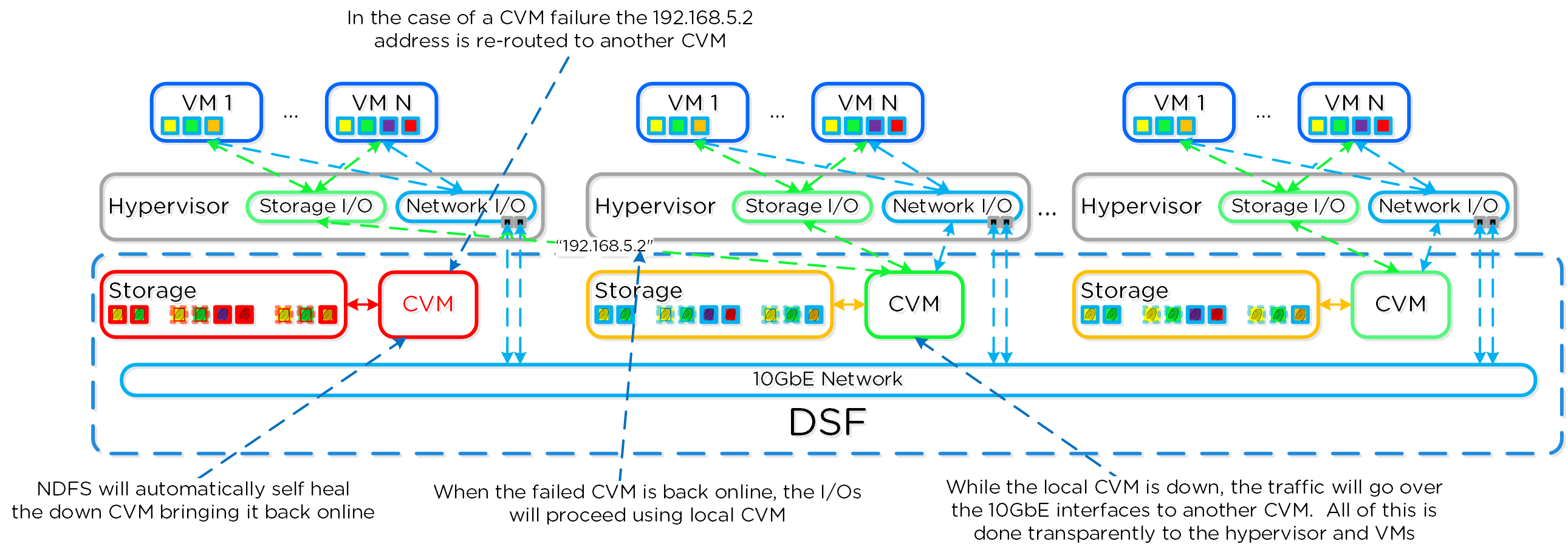

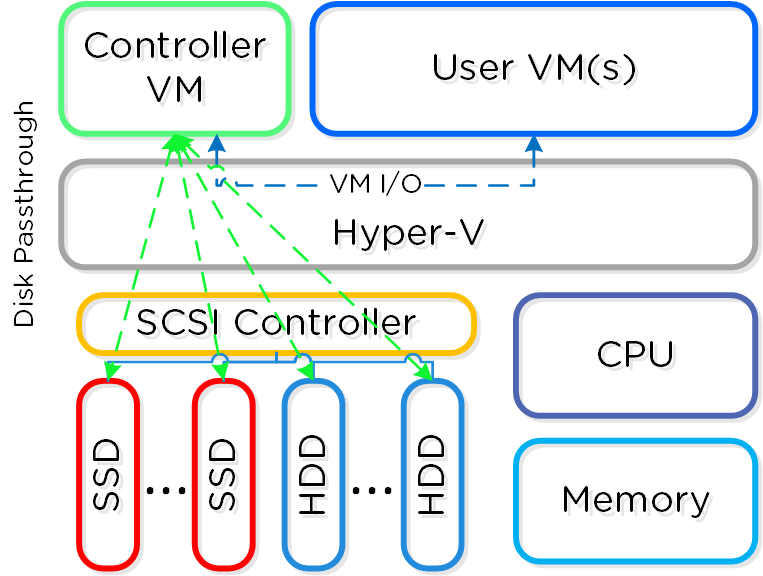

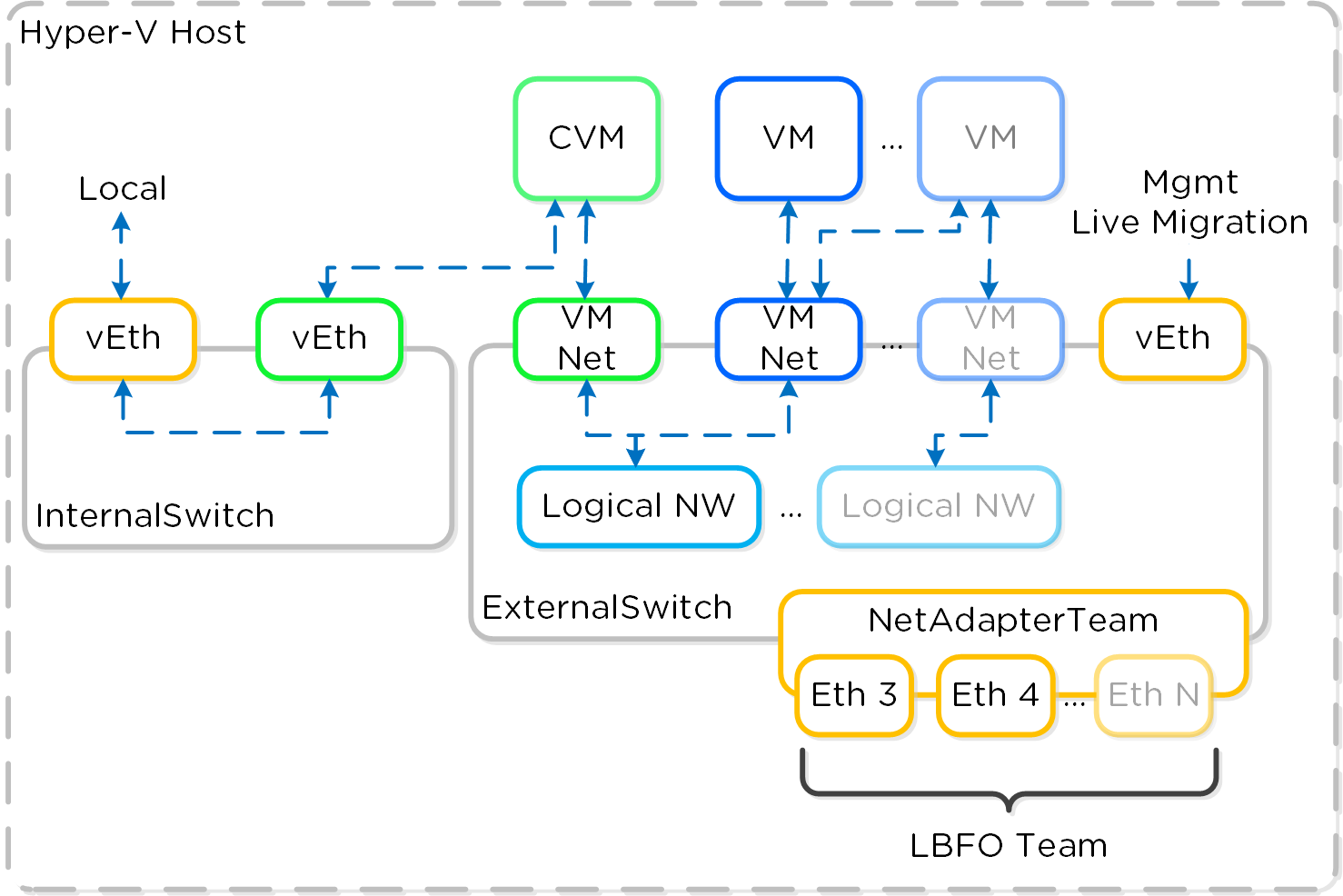

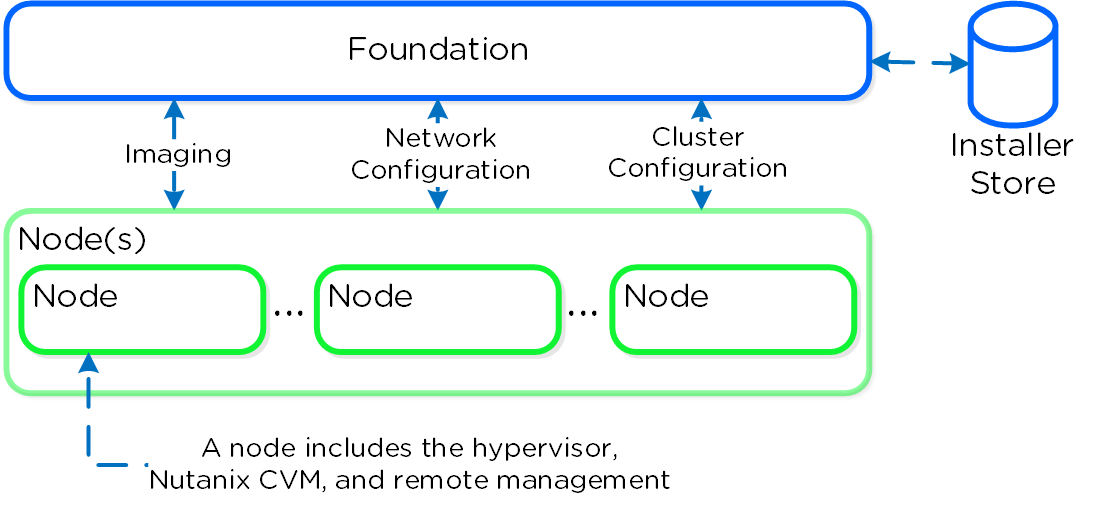

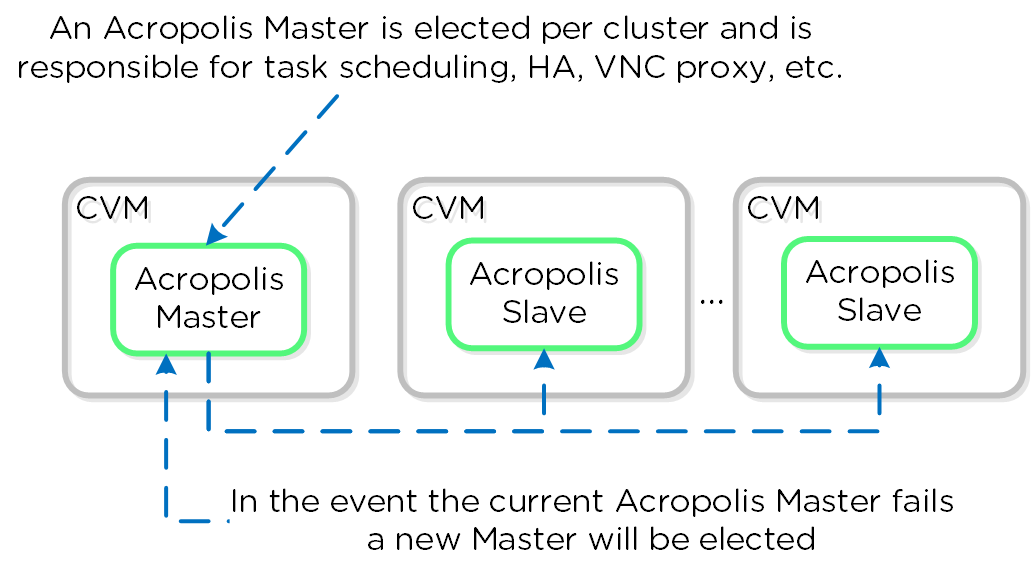

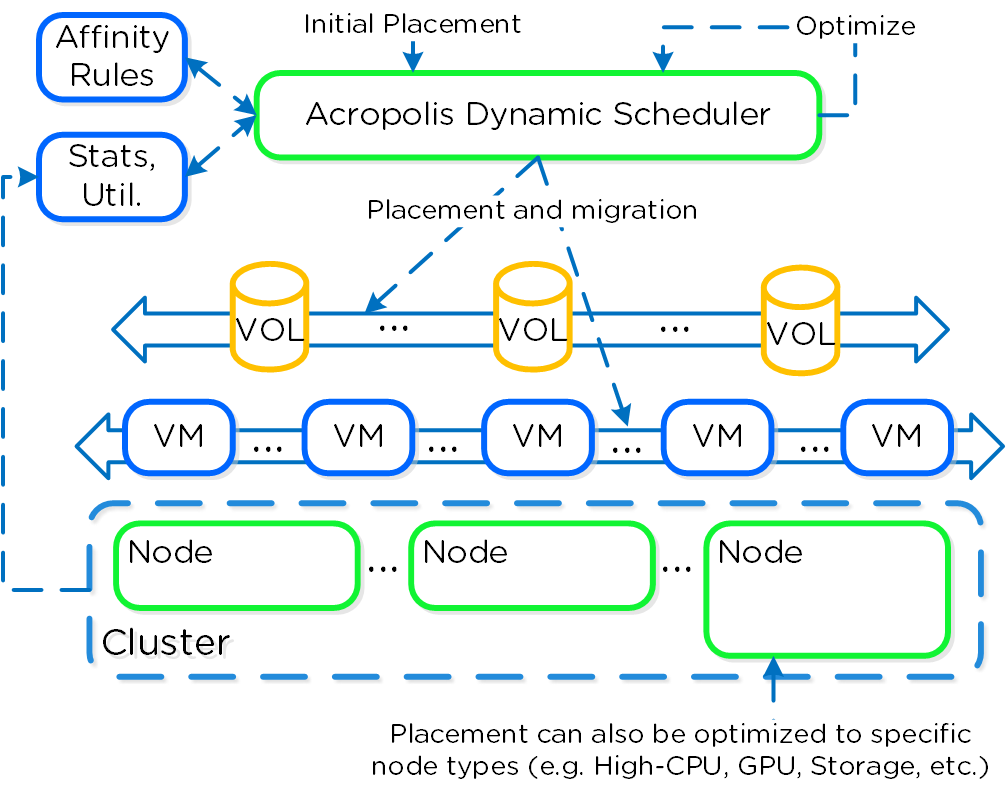

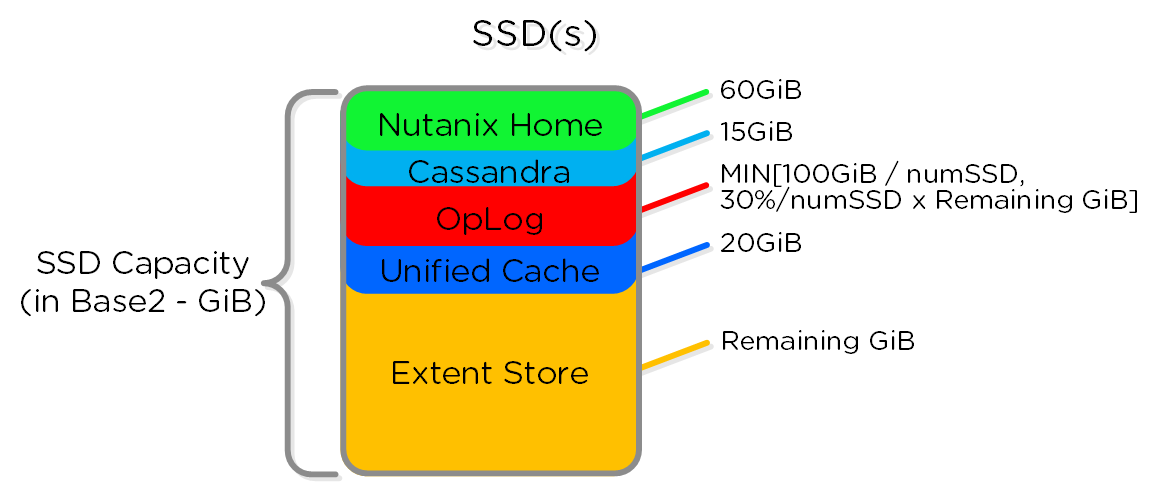

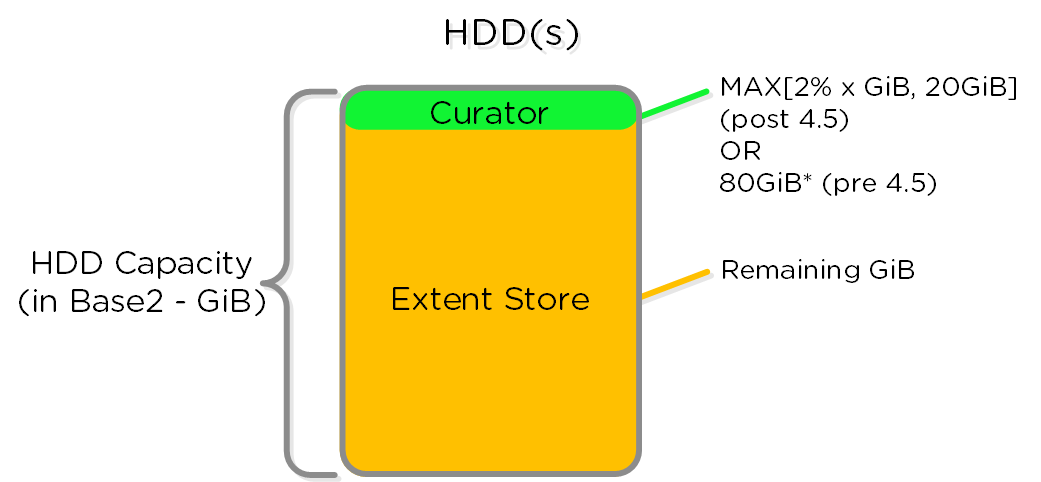

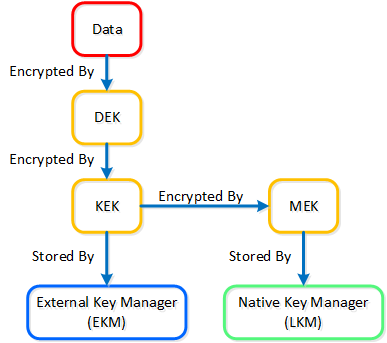

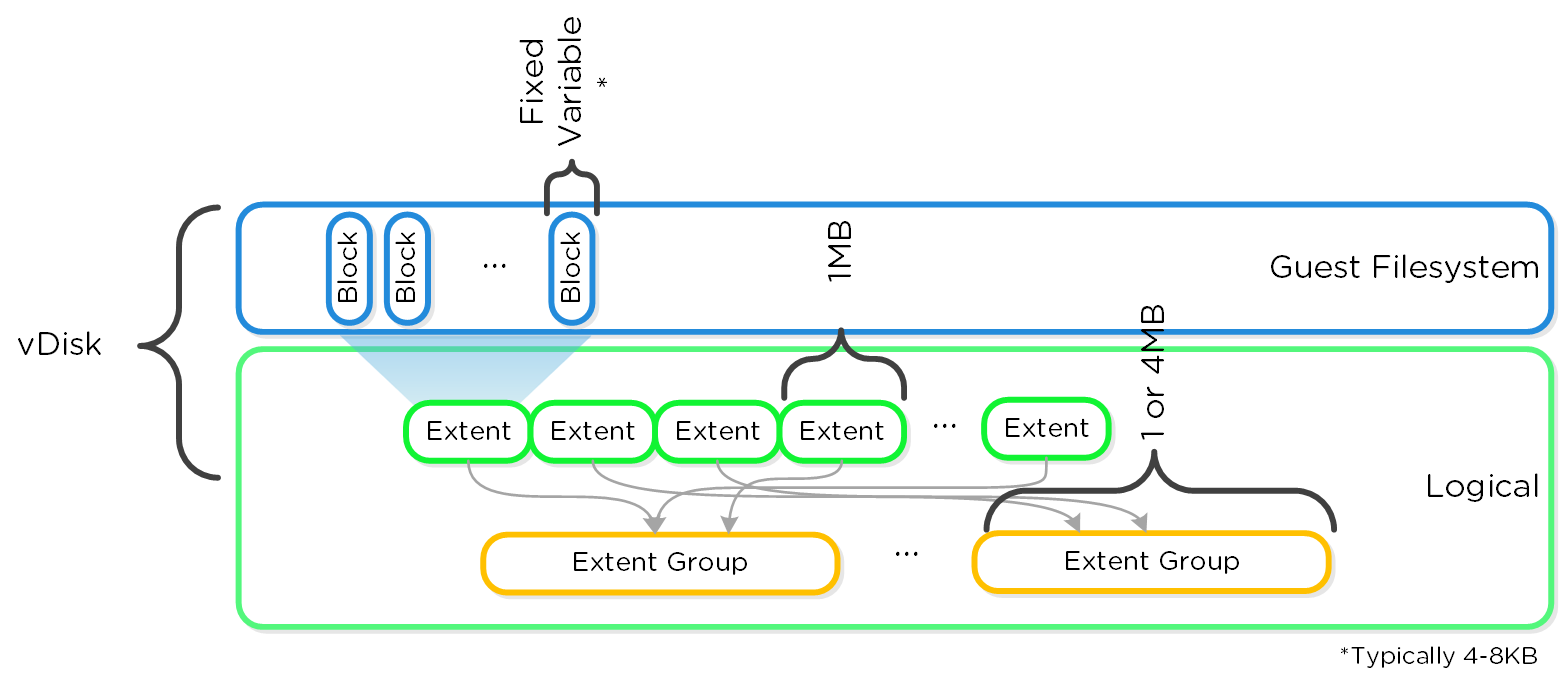

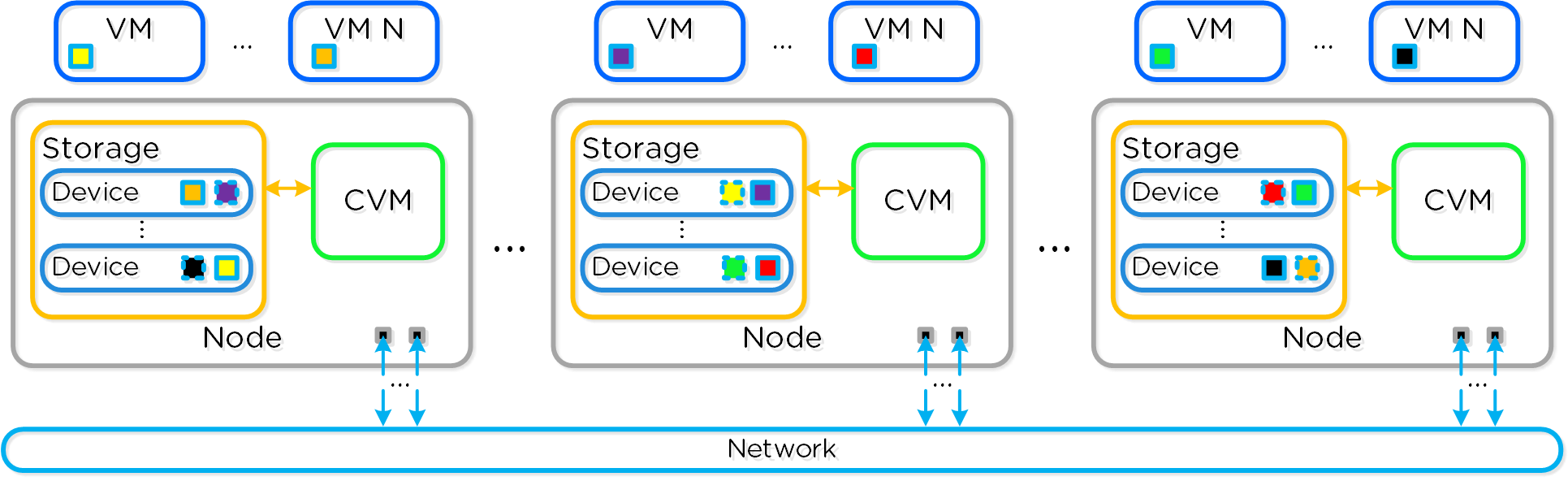

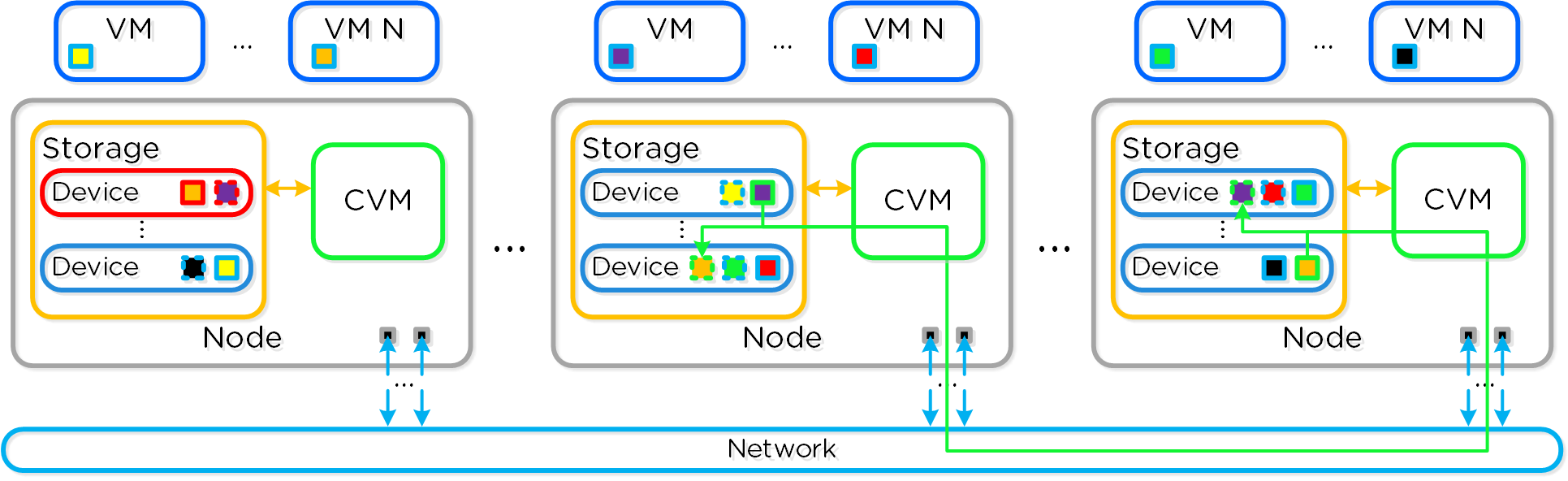

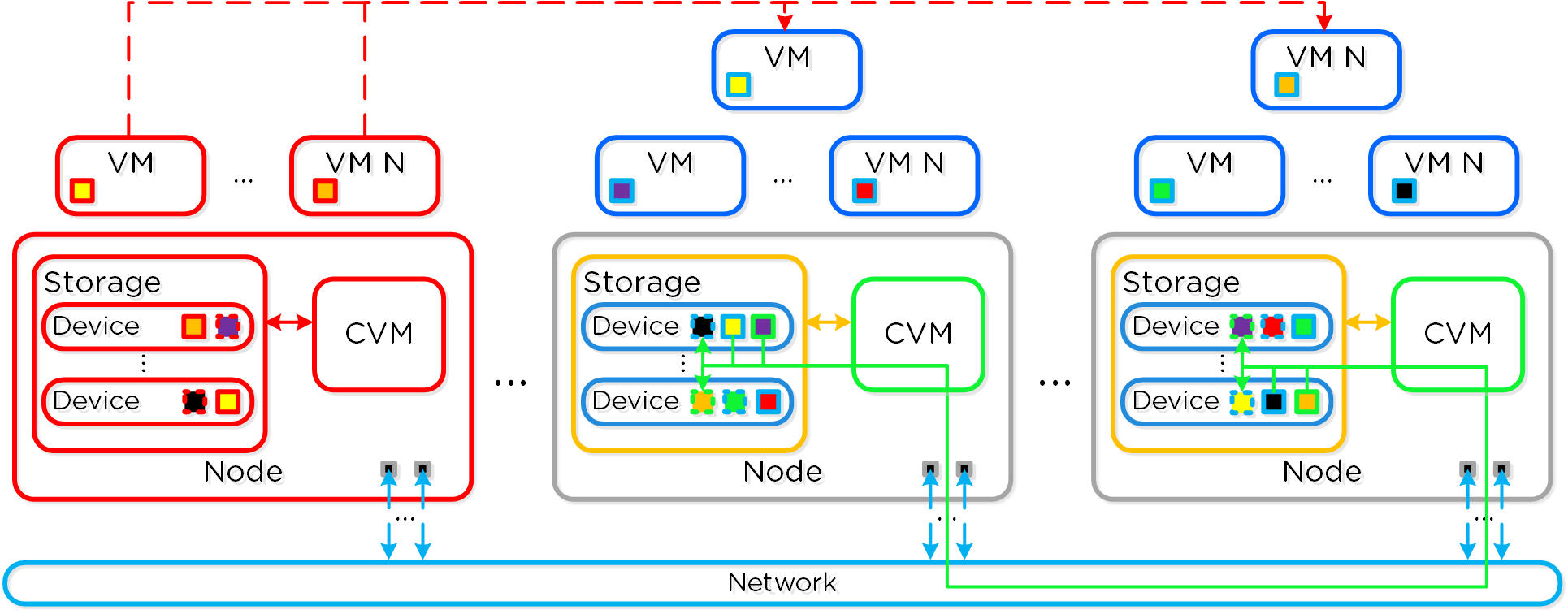

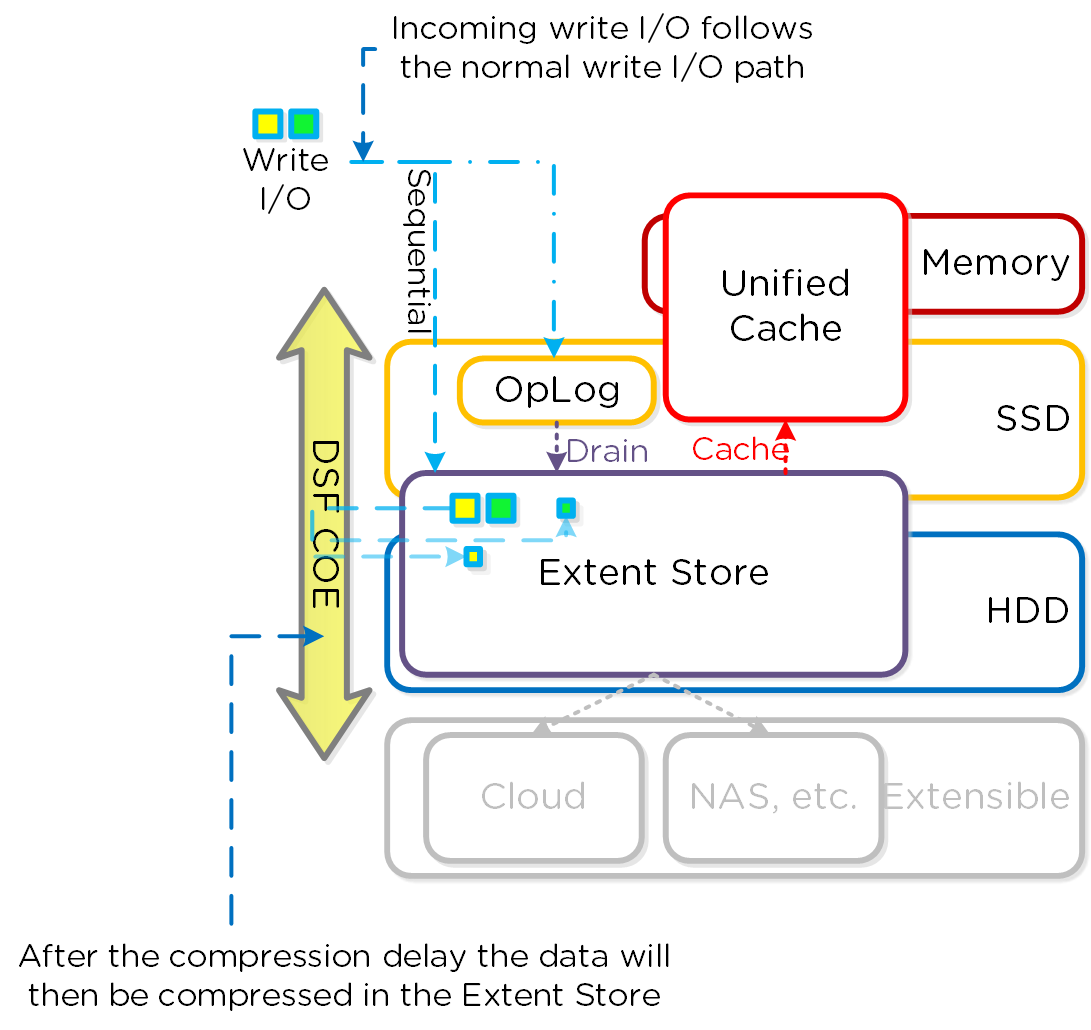

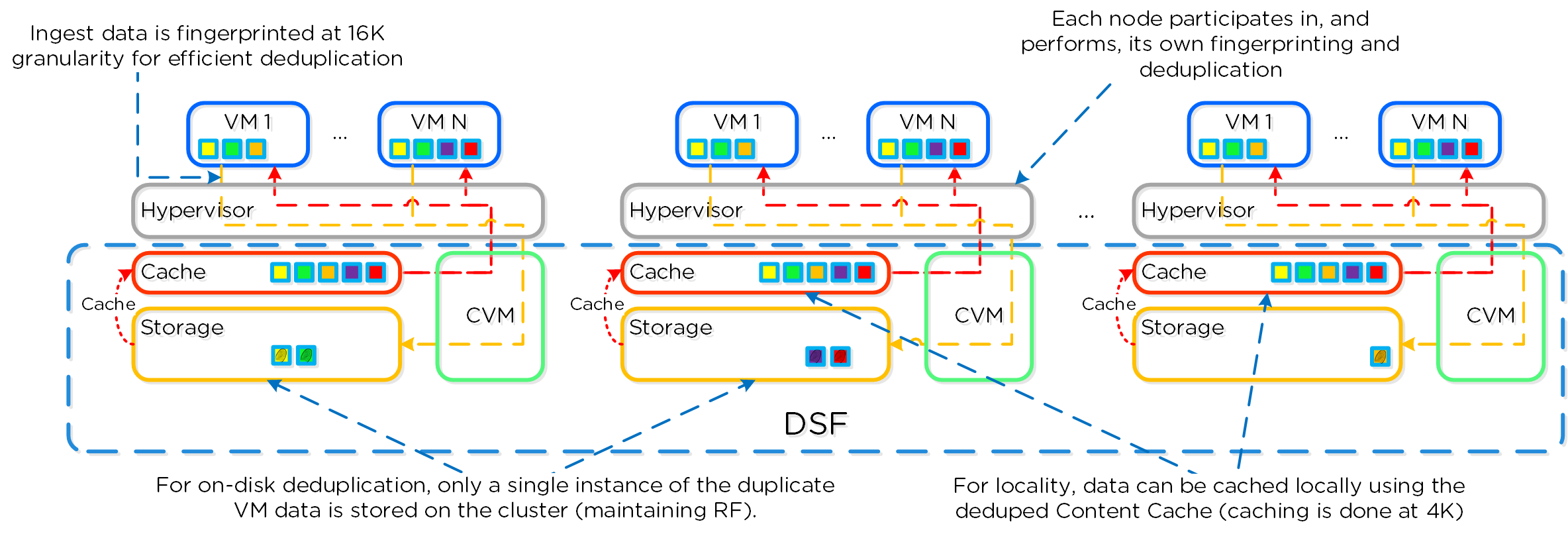

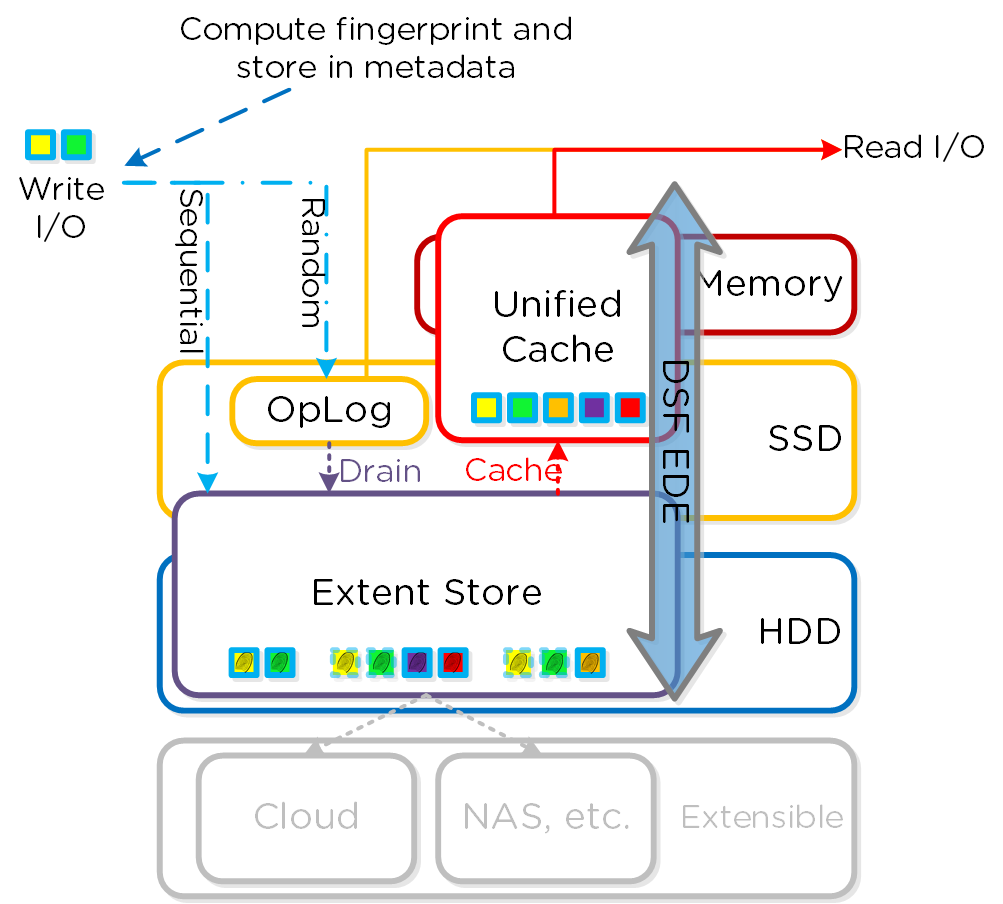

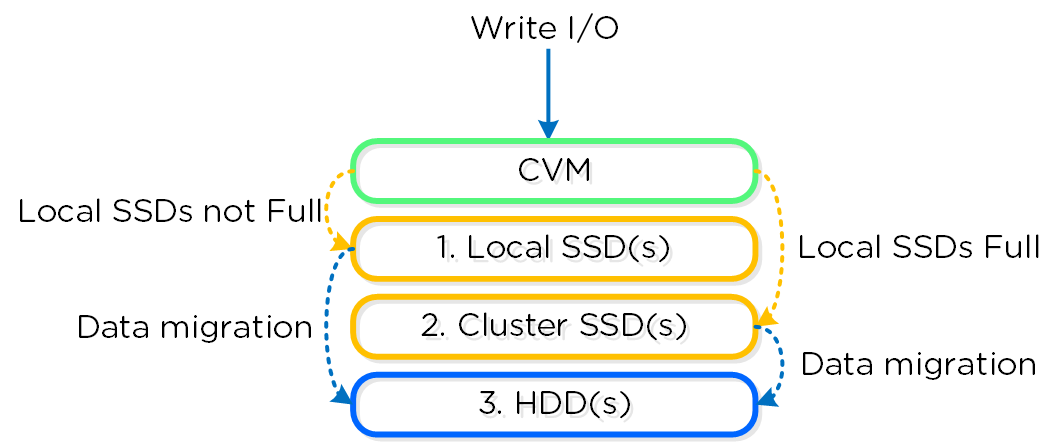

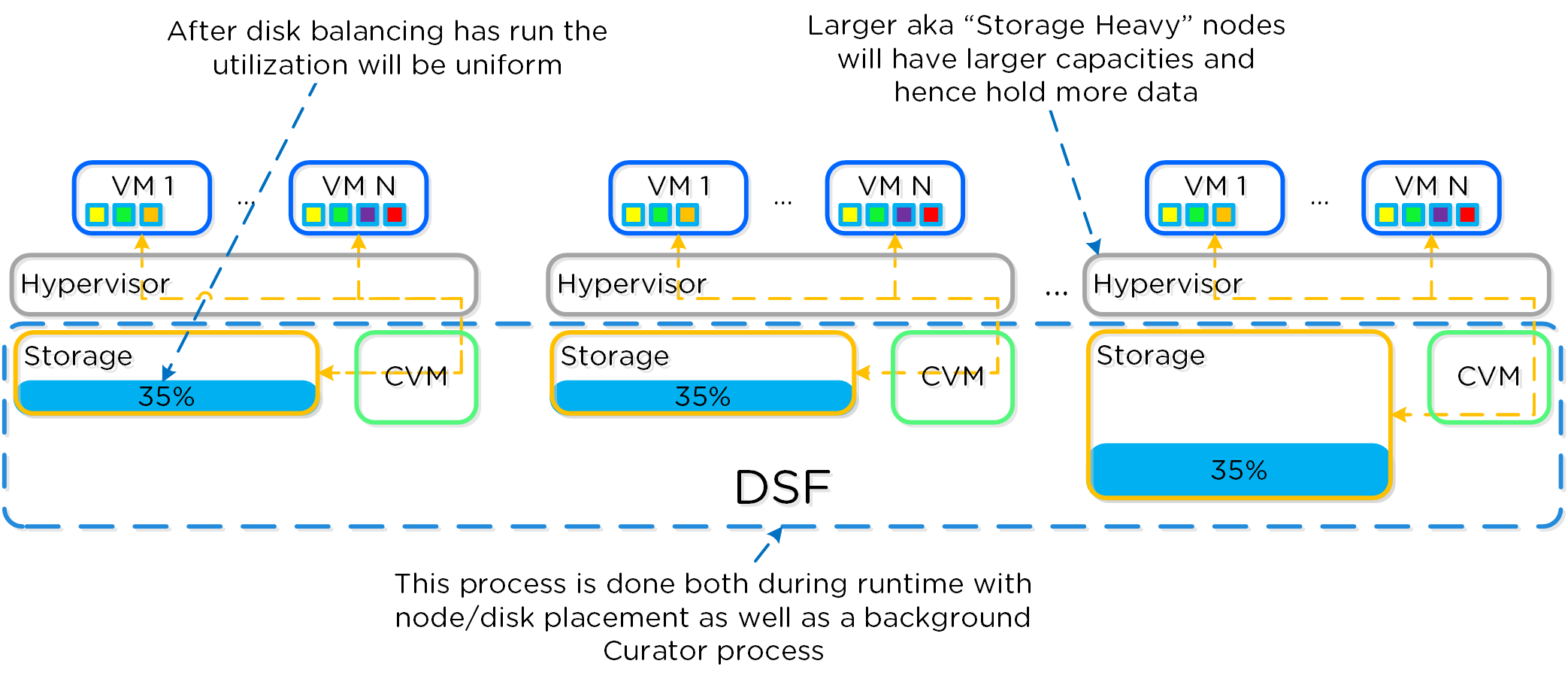

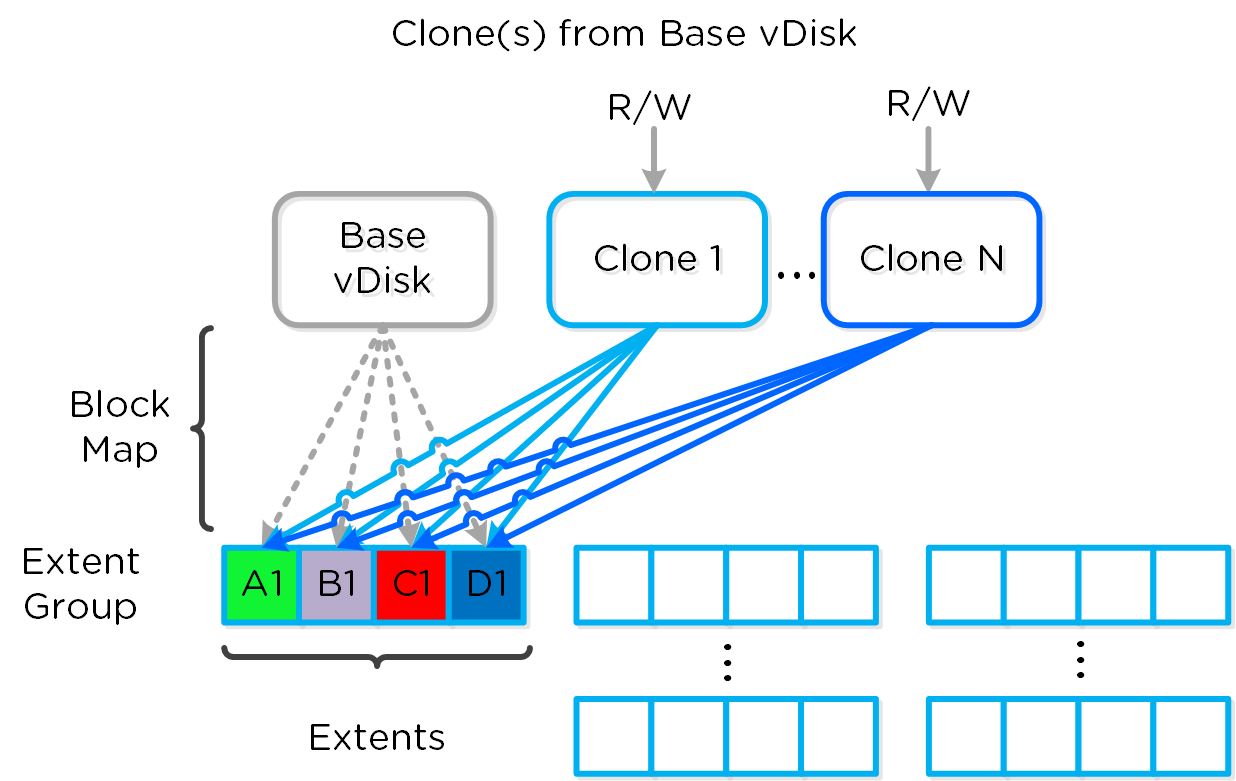

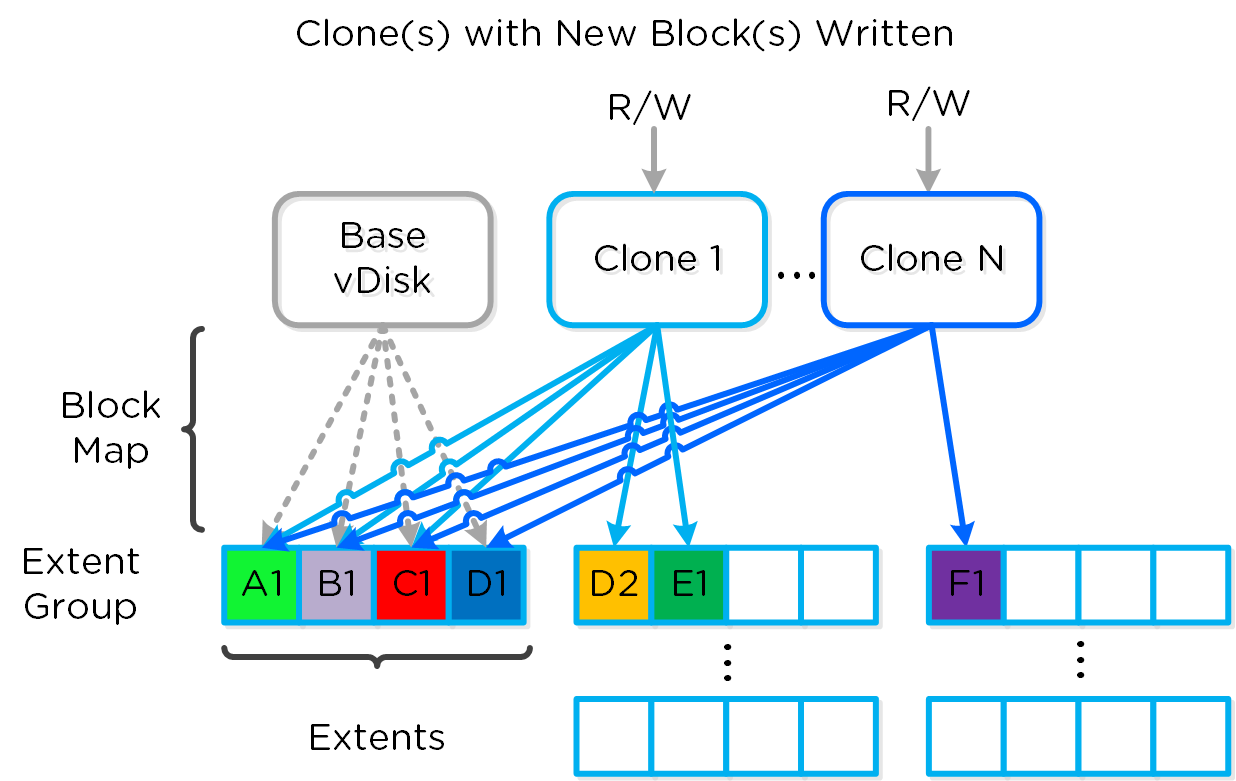

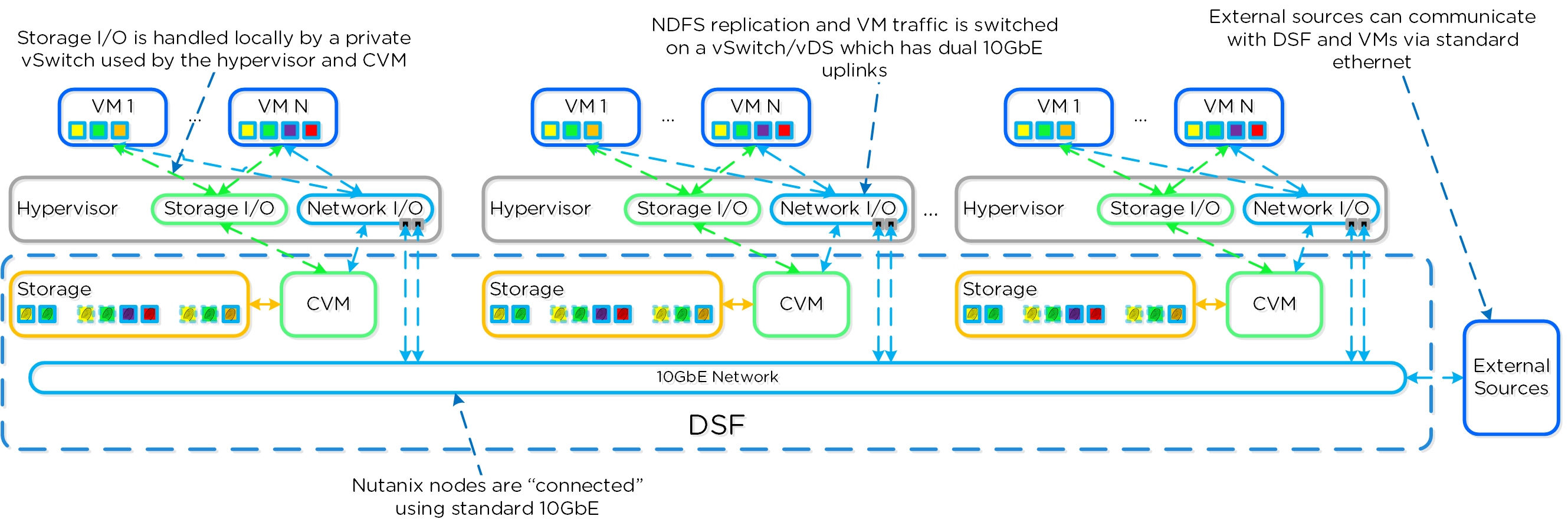

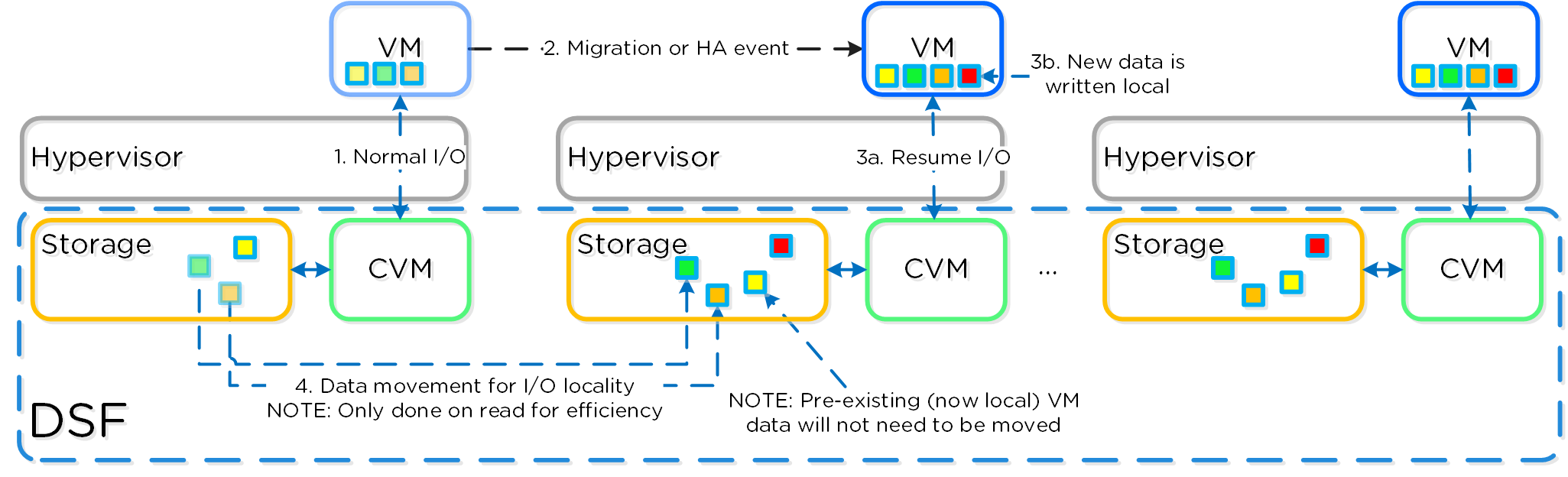

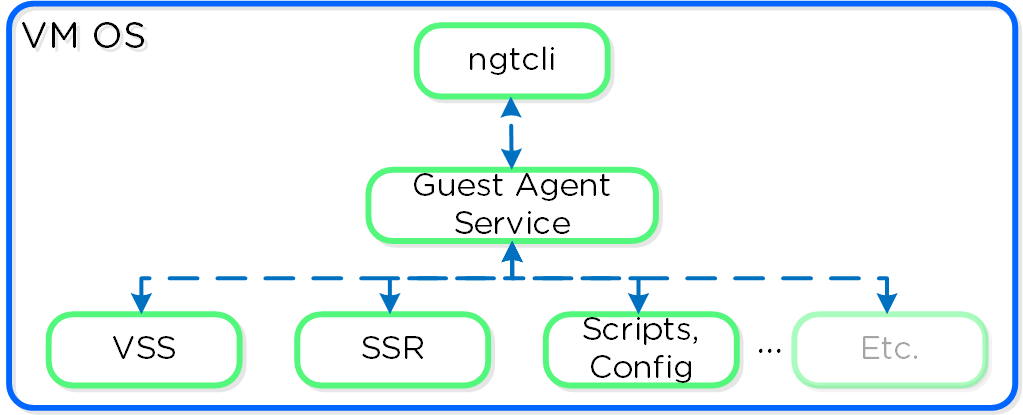

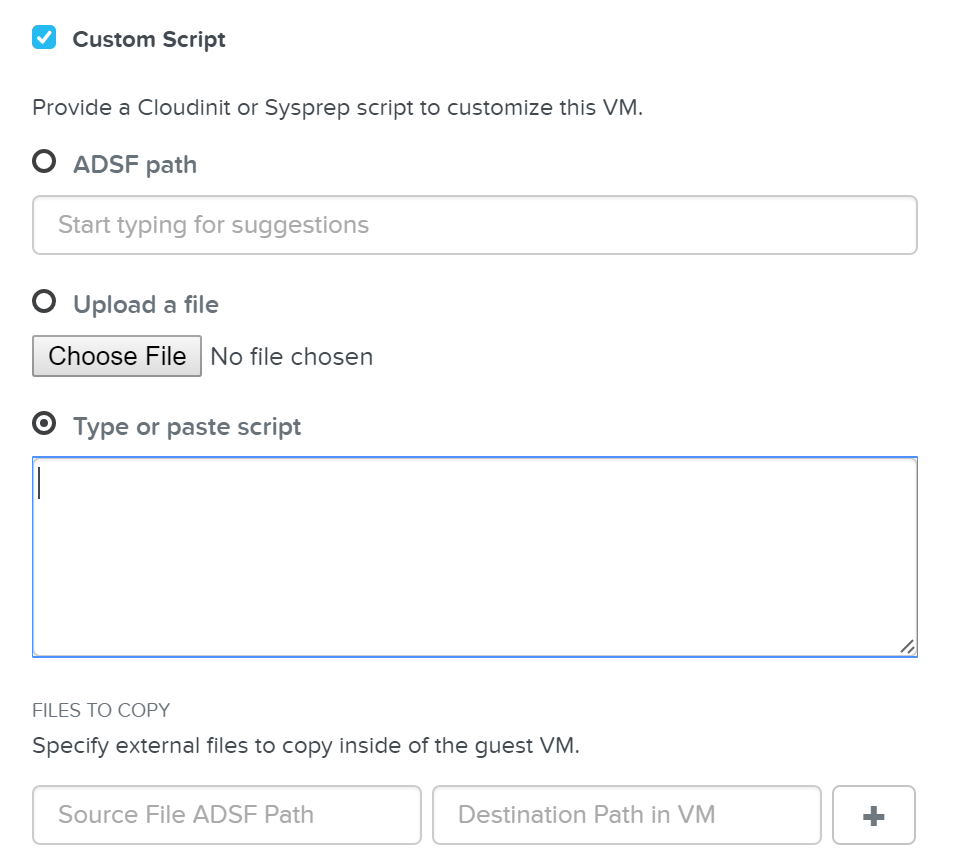

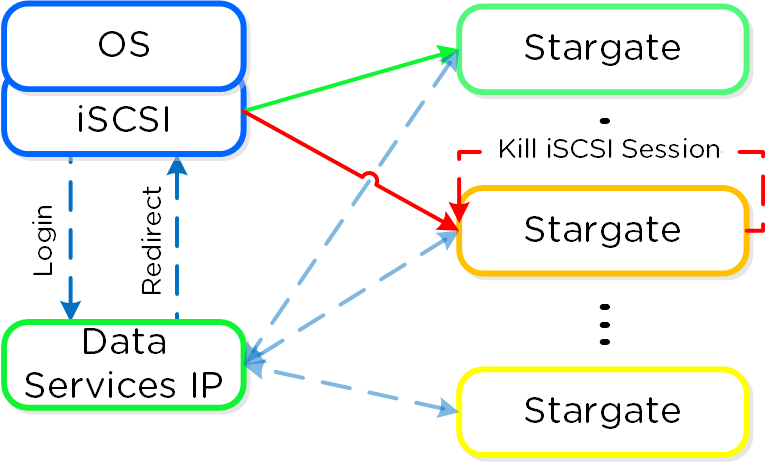

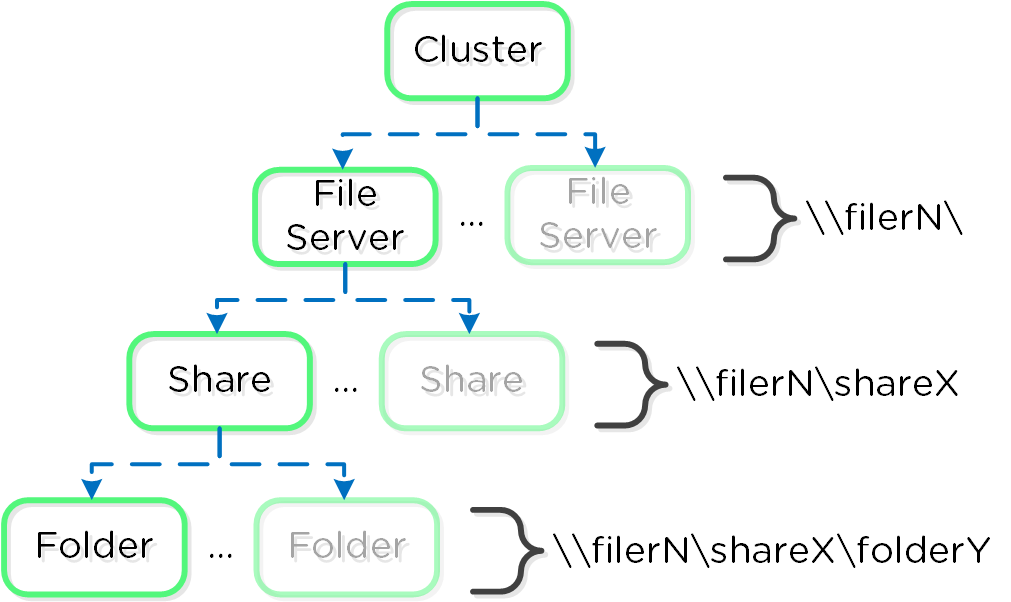

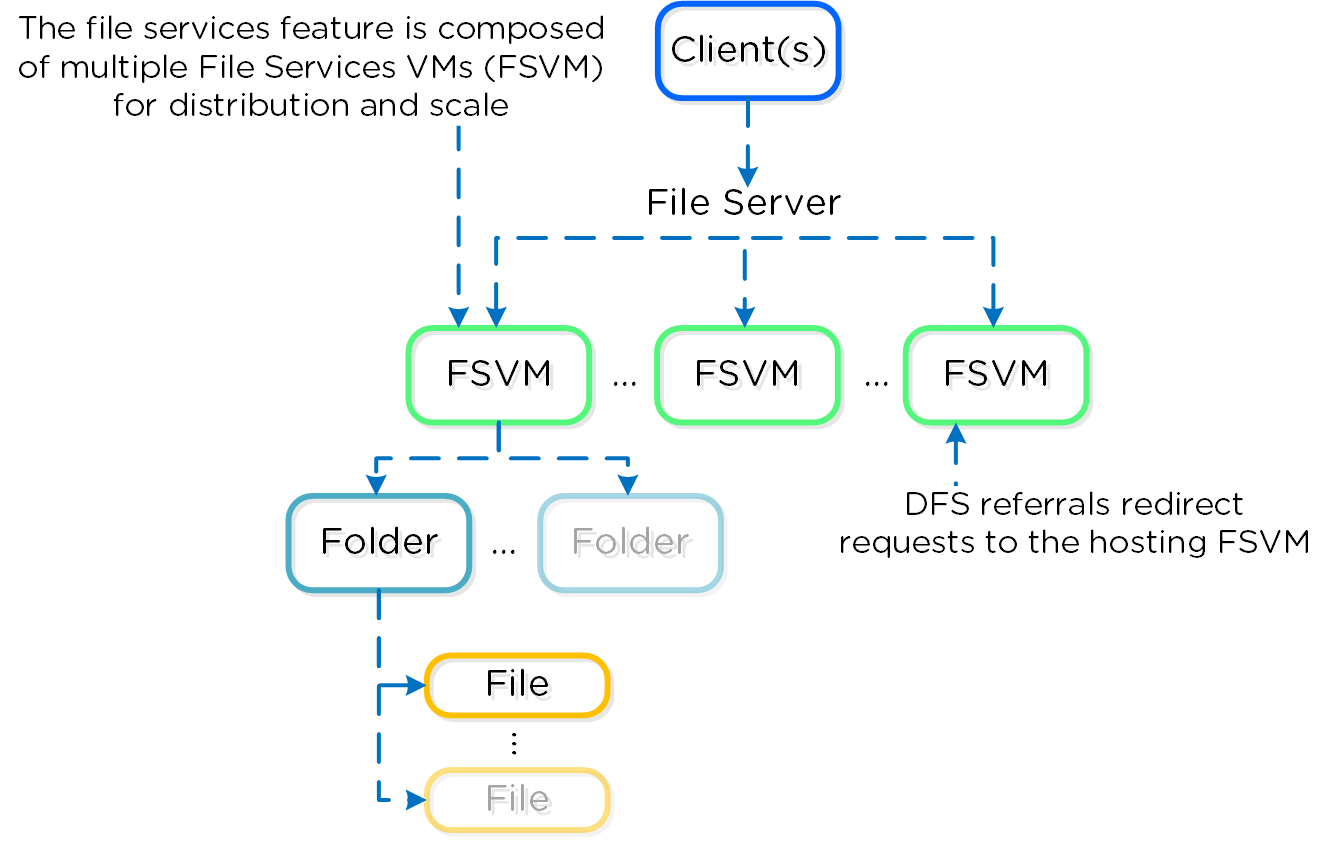

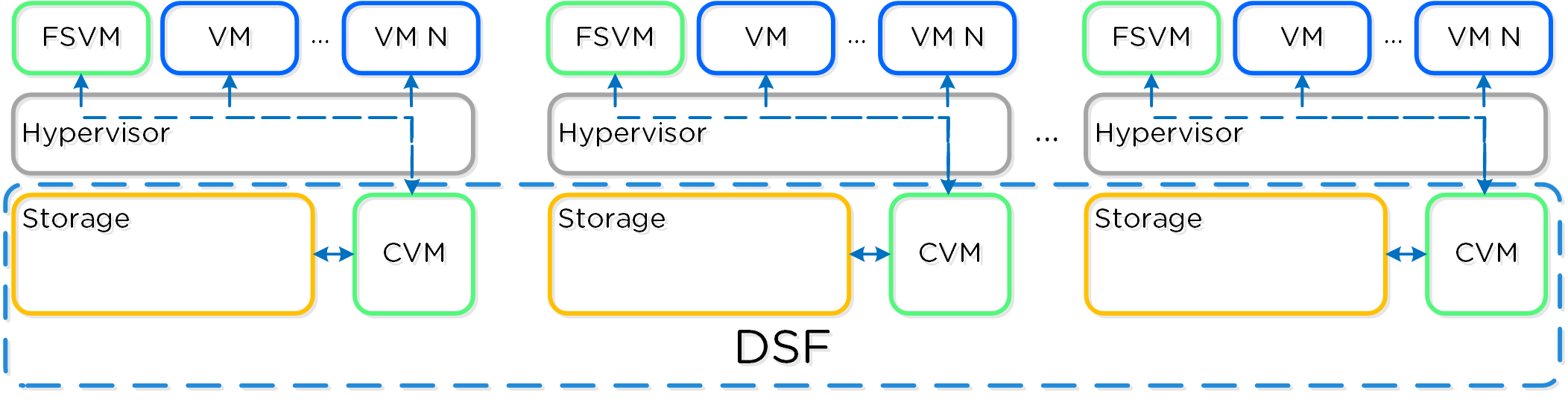

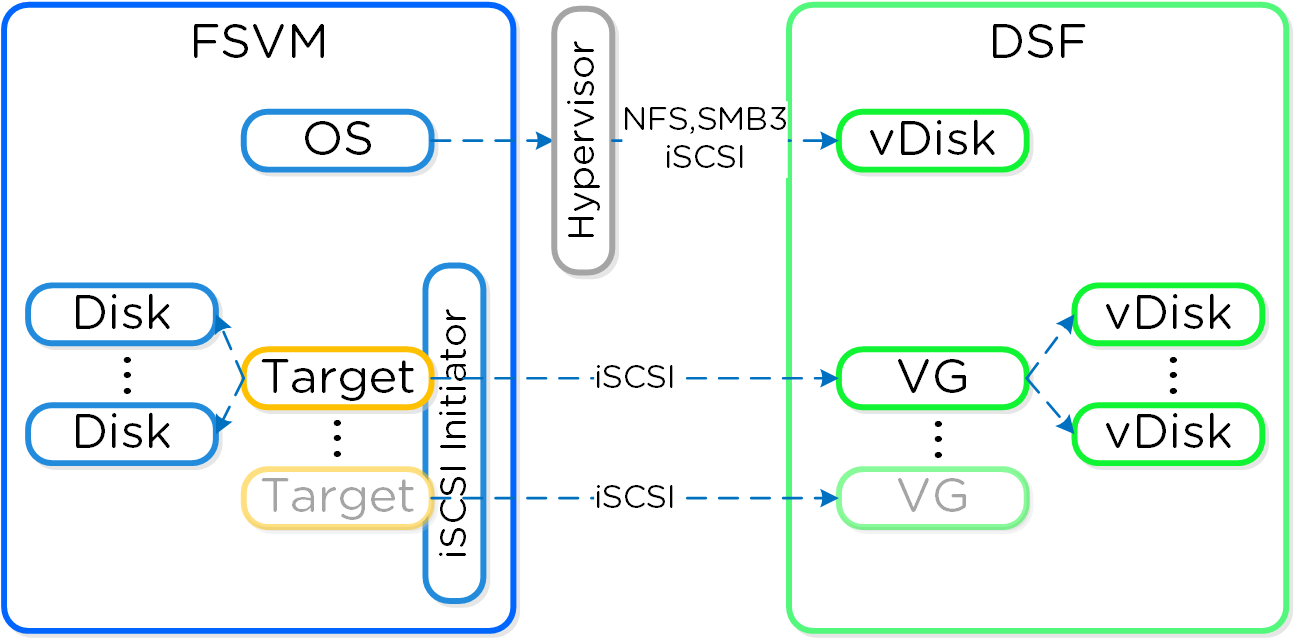

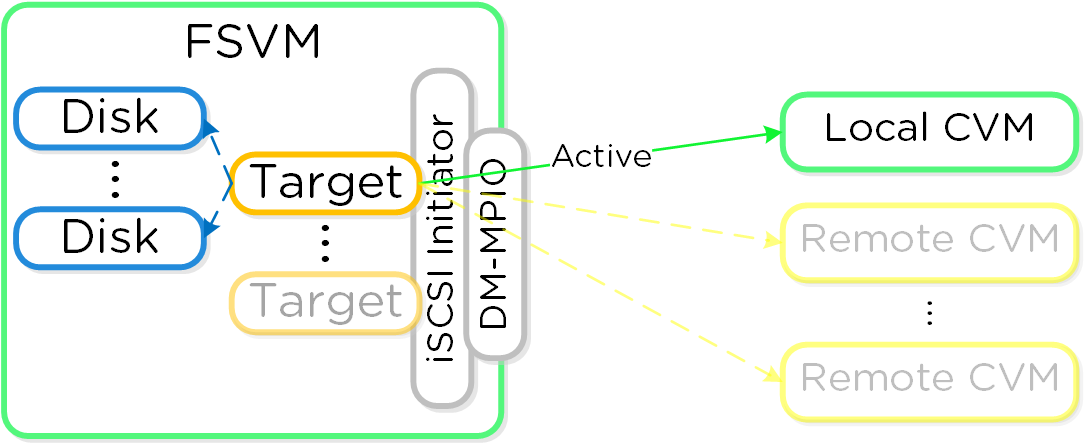

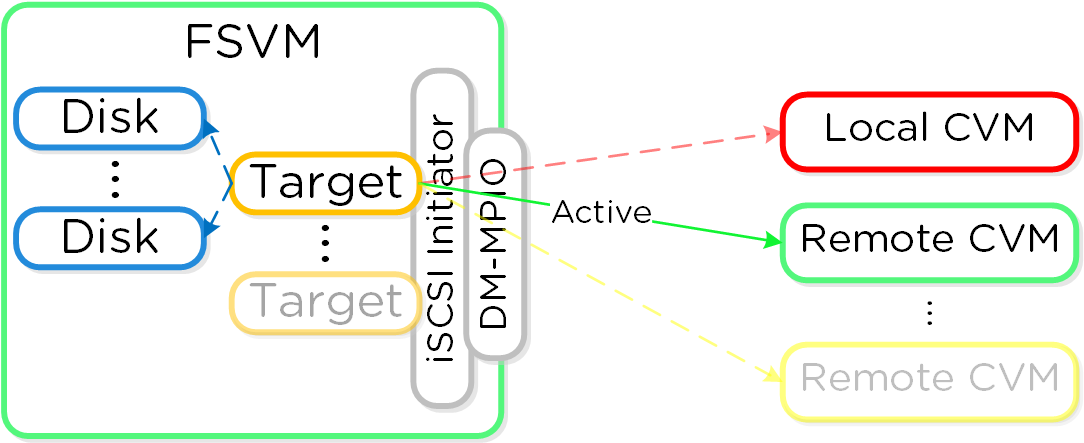

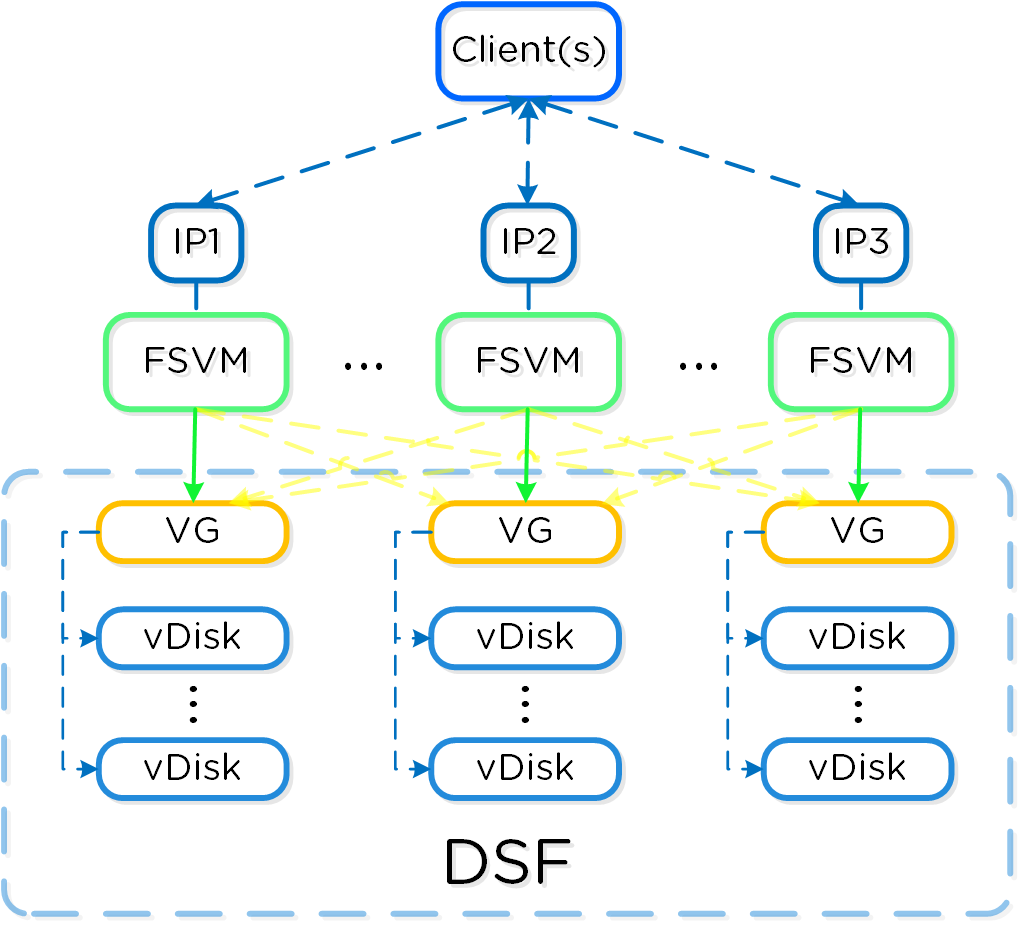

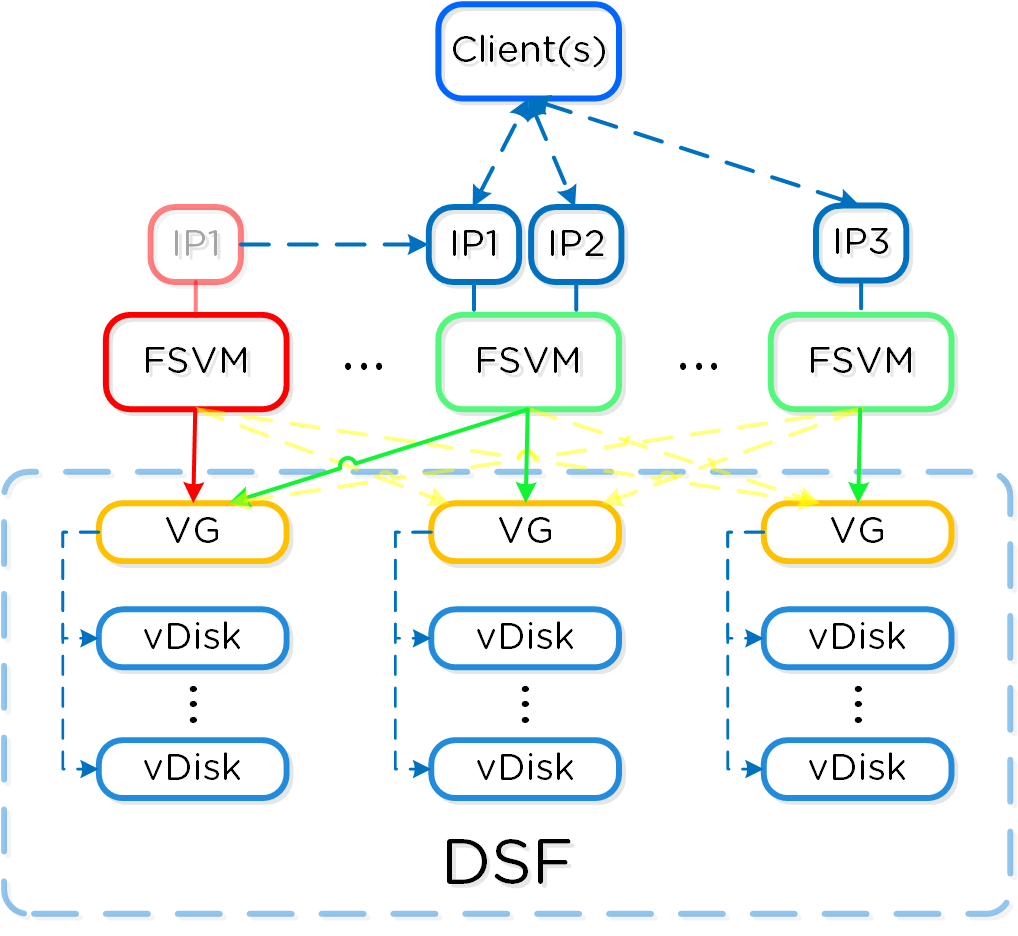

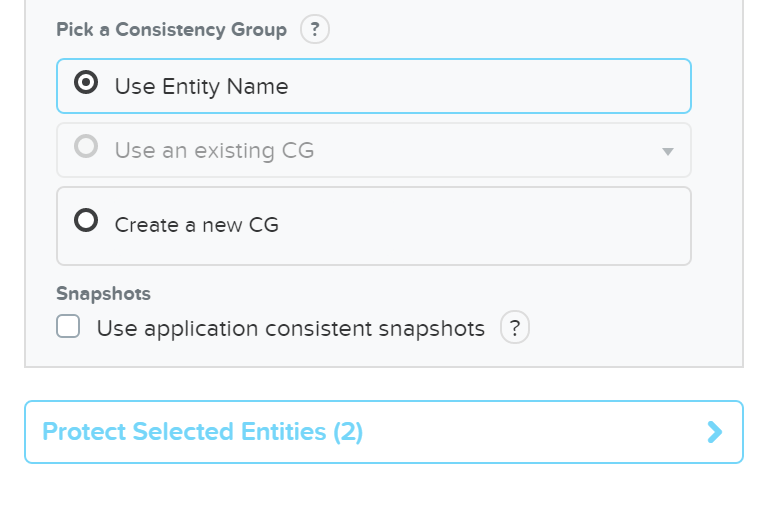

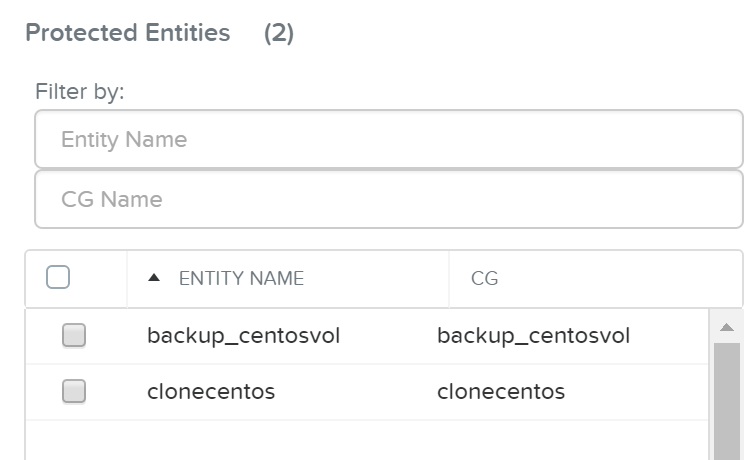

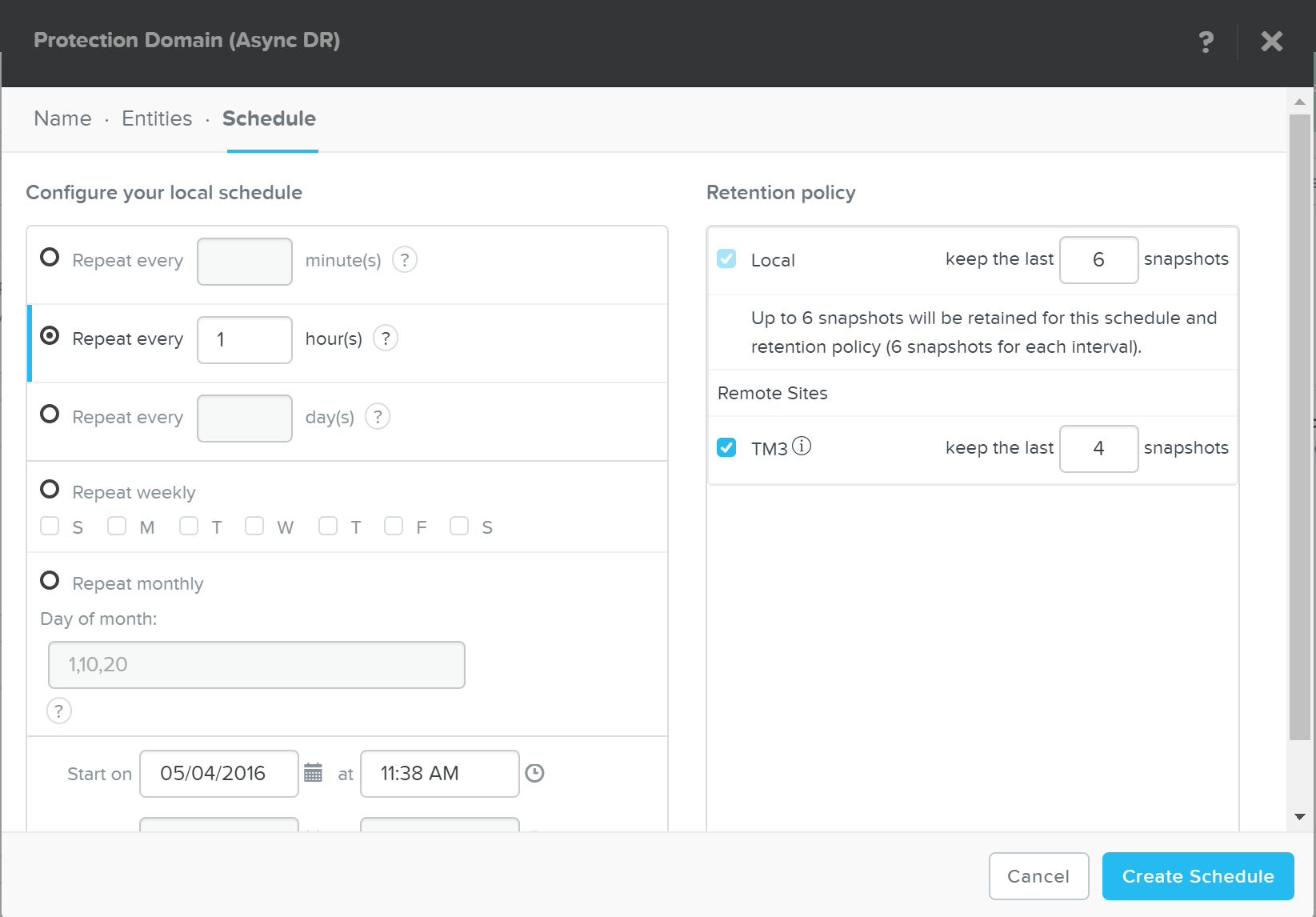

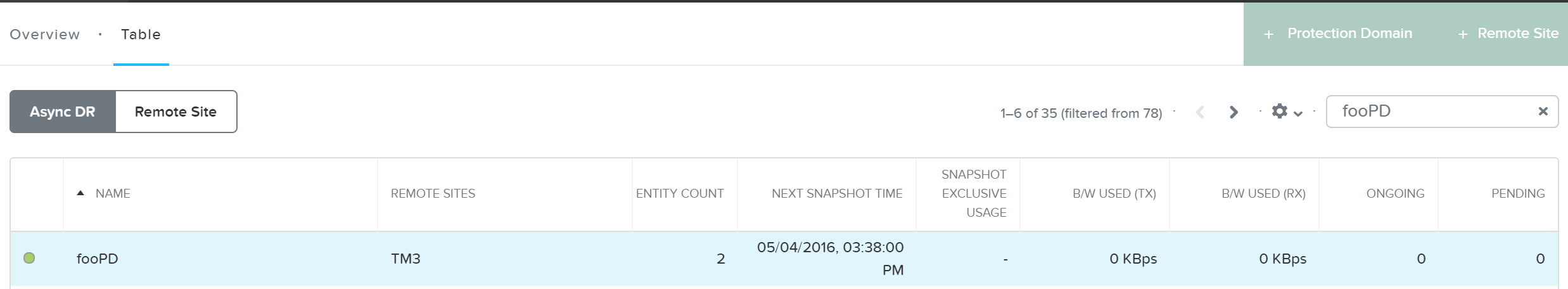

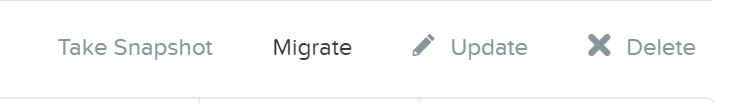

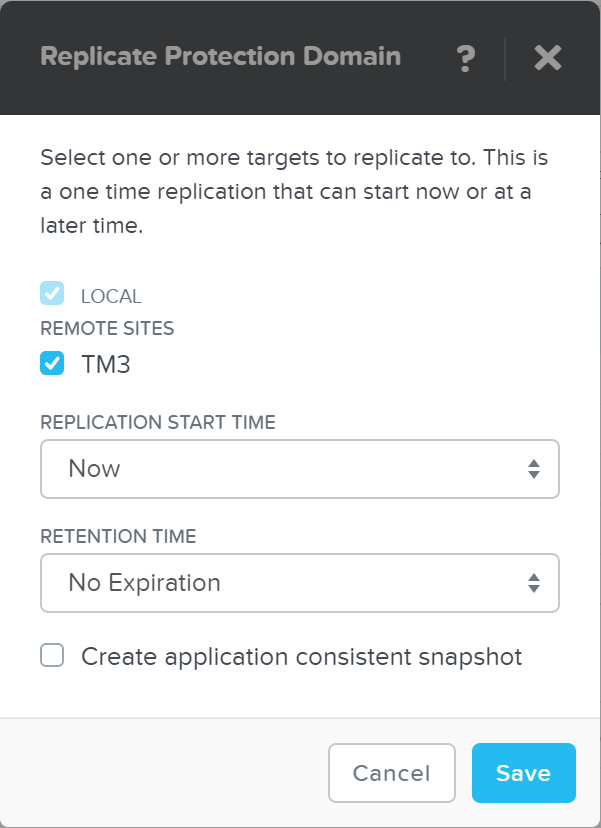

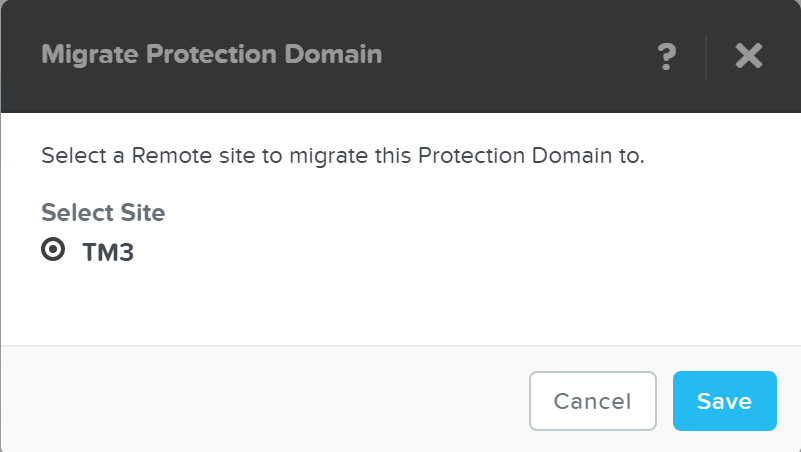

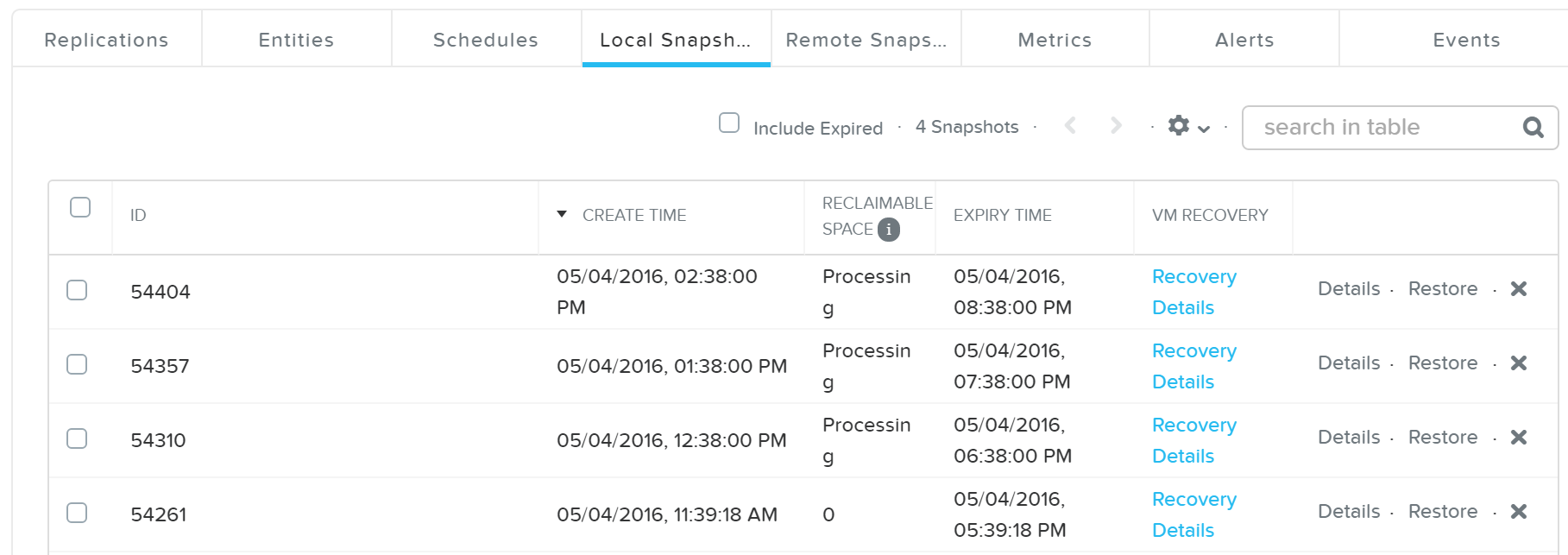

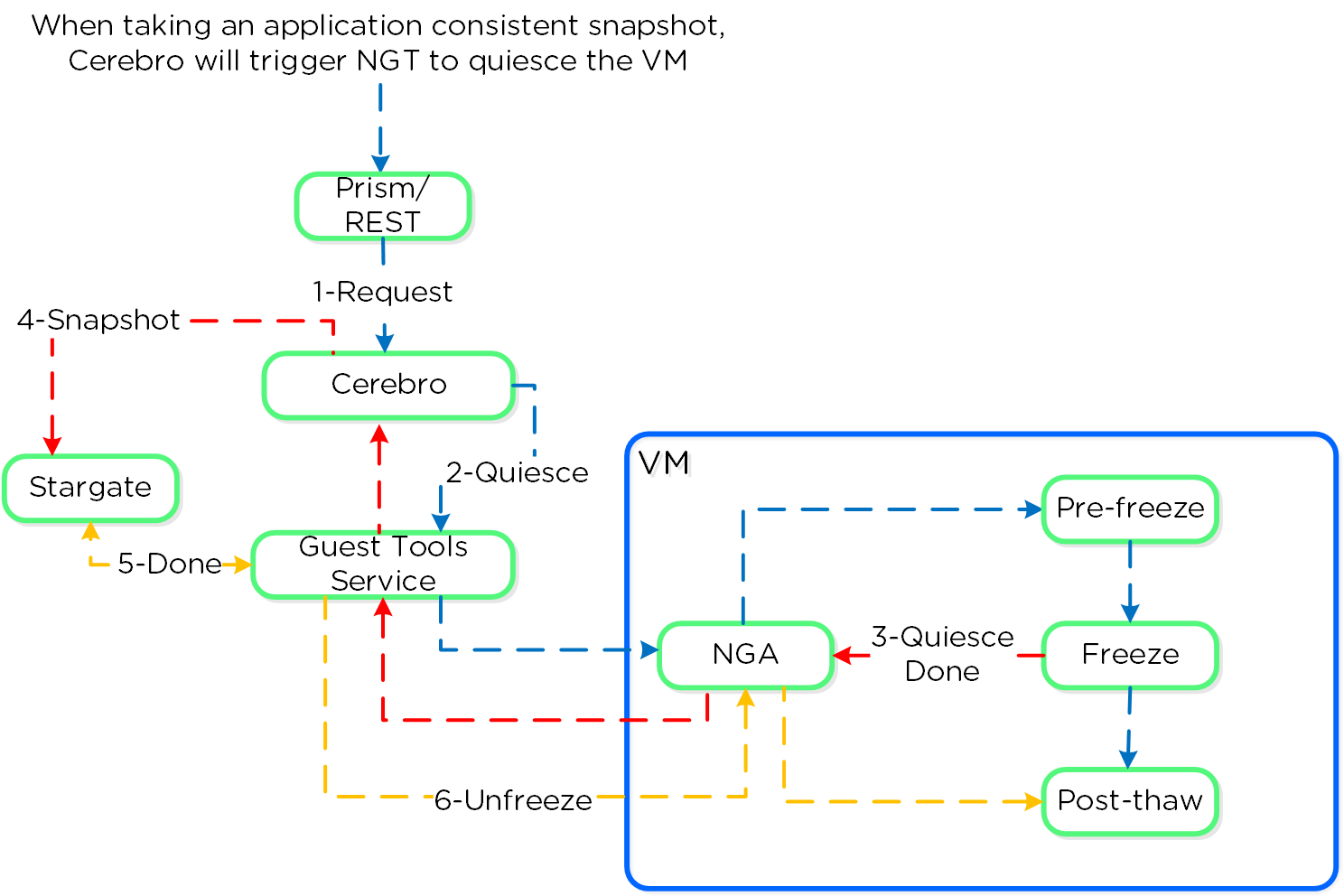

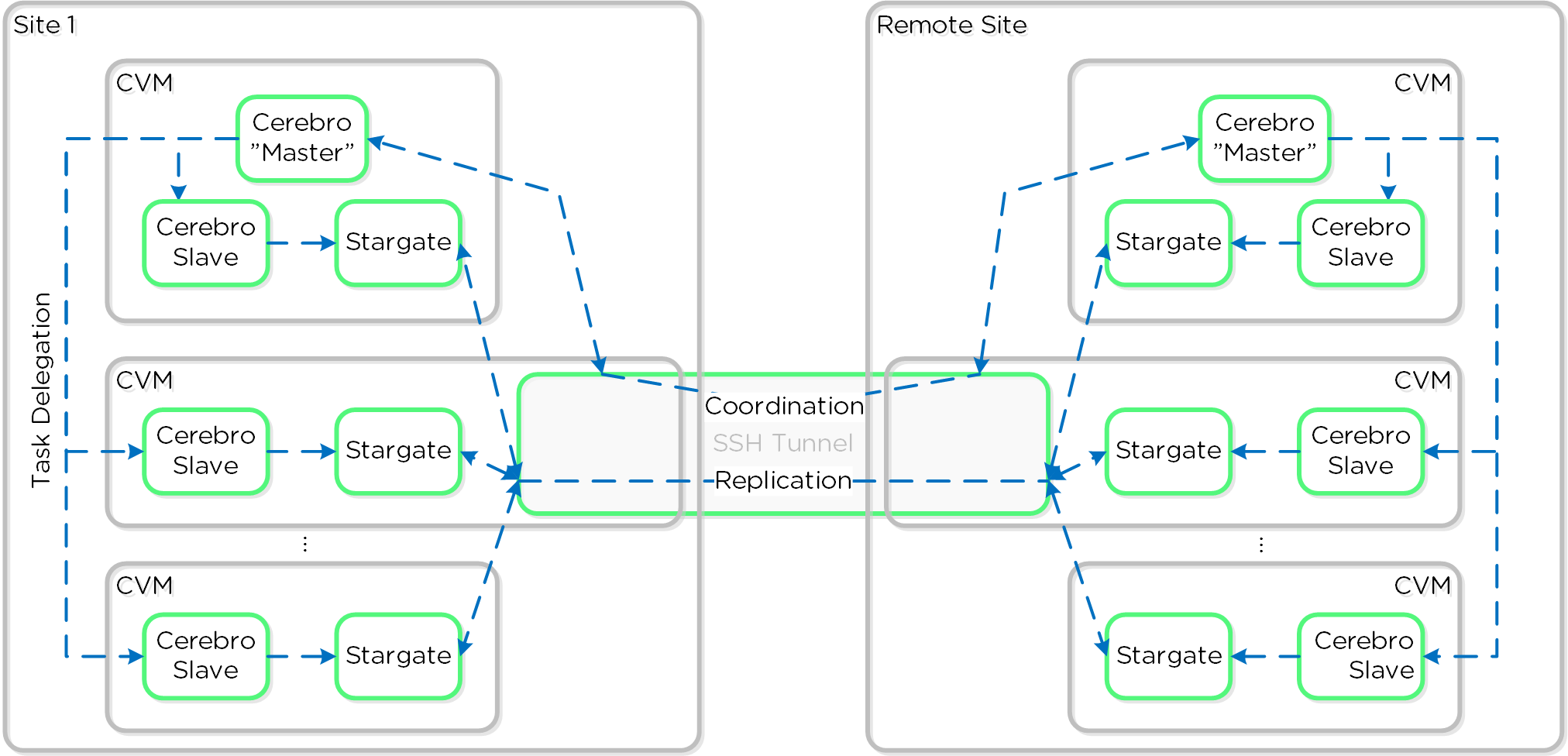

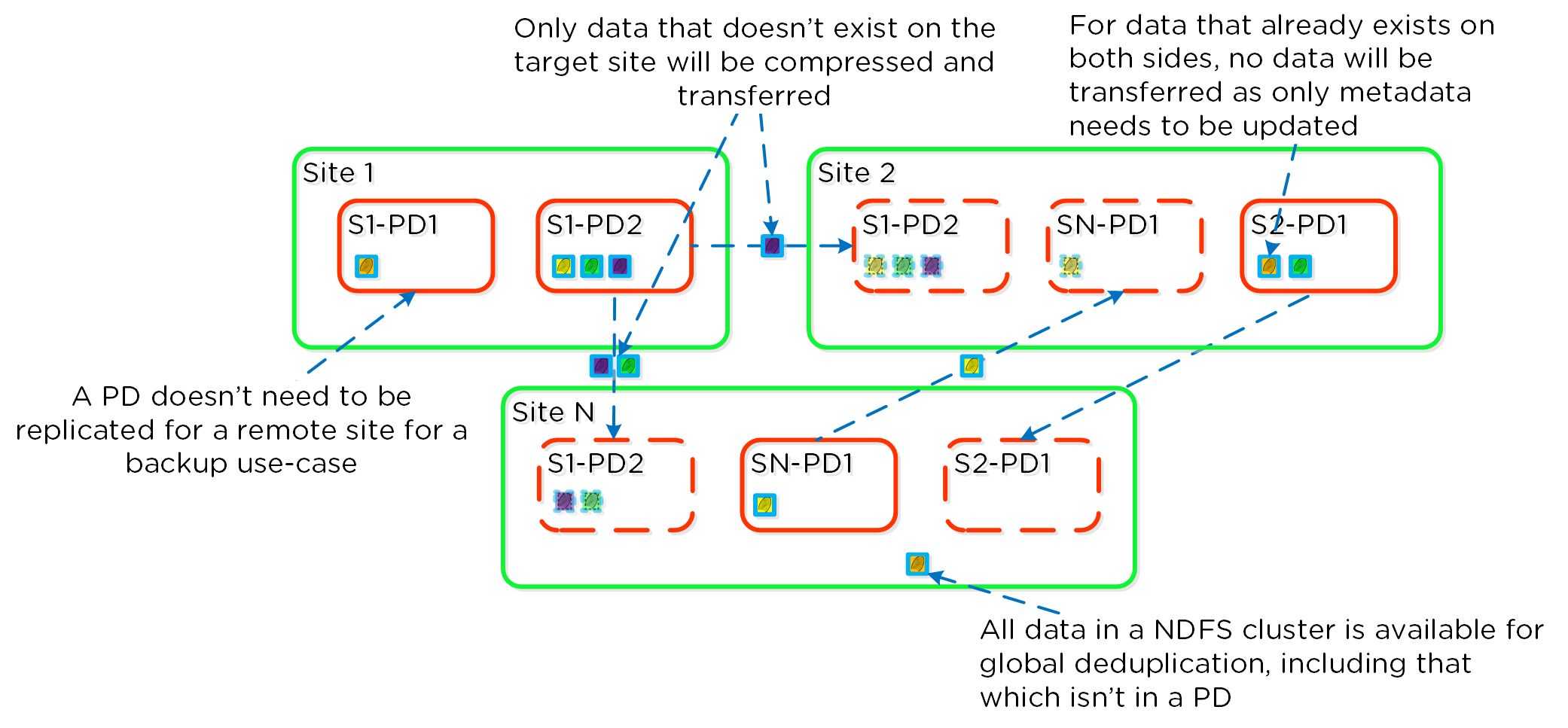

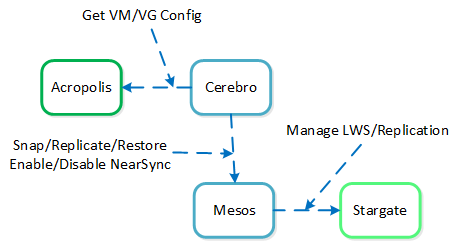

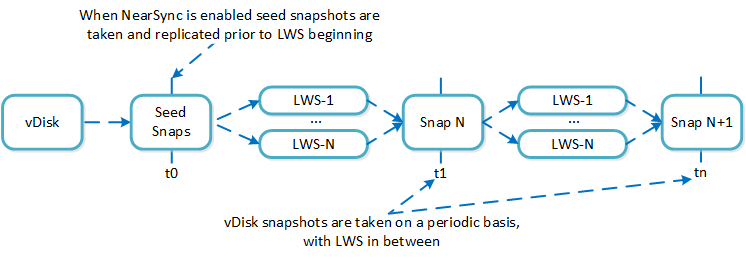

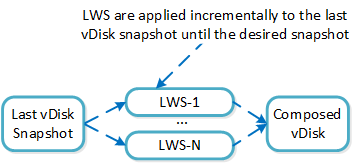

Nutanix это хранилище и вычислительные мощности объединенные в единую распределенную платформу виртуализации. Платформа поставляется как программно-аппаратное решение, в виде серверных блоков по два (серия 6000/7000) или четыре вычислительных узла (серия 1000/2000/3000/3050) высотой 2U.